?? 前言:為什么要自己搭建?

各位技術(shù)同學(xué)們,還在為ChatGPT的網(wǎng)絡(luò)限制而苦惱嗎?還在擔(dān)心敏感數(shù)據(jù)泄露給第三方嗎?今天給大家?guī)硪粋€(gè)超級實(shí)用的解決方案——自部署AI提示詞優(yōu)化平臺!

想象一下:

- ? 數(shù)據(jù)完全私有,不用擔(dān)心泄露

- ? 無需FQ,本地運(yùn)行如絲般順滑

- ? 提示詞優(yōu)化+調(diào)試,一站式解決

- ? 支持多種開源大模型,想用啥用啥

聽起來是不是很香?那就跟著我一起搭建吧!

??? 技術(shù)棧介紹

核心組件

- auto-prompt:專業(yè)的AI提示詞優(yōu)化平臺

- Ollama:本地大模型管理神器

- Docker:一鍵部署,環(huán)境隔離

- SQLite:輕量級數(shù)據(jù)庫,開箱即用

為什么選擇這個(gè)組合?

auto-prompt 是一個(gè)專業(yè)的提示詞工程平臺,具備:

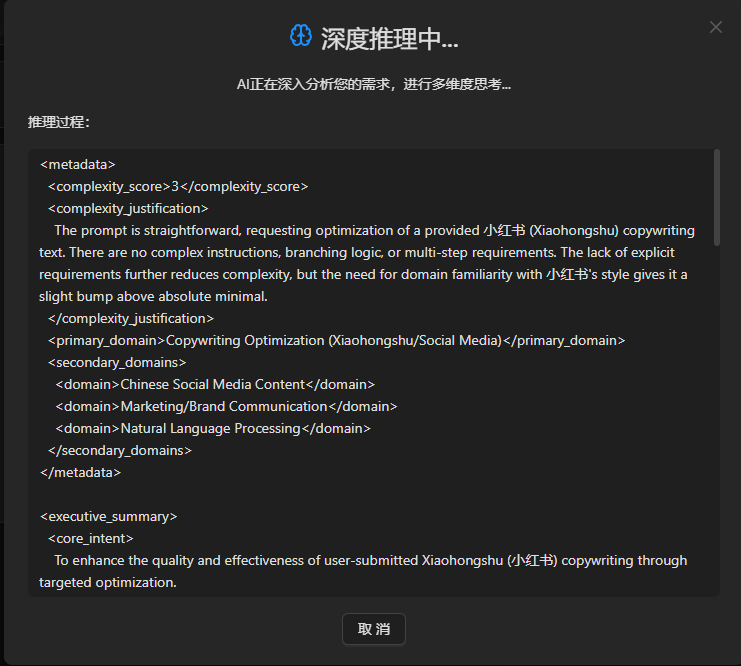

- ?? 智能提示詞優(yōu)化算法

- ?? 深度推理分析

- ?? 可視化調(diào)試工具

- ?? 社區(qū)分享功能

Ollama 則是本地AI模型的管家:

- ?? 一鍵下載各種開源模型

- ? 簡單易用的API接口

- ?? 靈活的模型管理

?? 開始部署

第一步:準(zhǔn)備環(huán)境

首先確保你的機(jī)器已經(jīng)安裝了Docker。如果沒有,請先安裝:

# Linux用戶

curl -fsSL https://get.docker.com | sh

# Windows/Mac用戶請下載Docker Desktop

第二步:啟動Ollama

# 創(chuàng)建數(shù)據(jù)卷

docker volume create ollama_data

# 啟動Ollama容器

docker run -d \

--name ollama \

-p 11434:11434 \

-v ollama_data:/root/.ollama \

--restart unless-stopped \

ollama/ollama

第三步:下載AI模型

# 下載輕量級模型(推薦新手)

docker exec ollama ollama pull llama3.2:1b

# 或者下載更強(qiáng)大的模型(需要更多內(nèi)存)

docker exec ollama ollama pull qwen2.5:7b

小貼士:第一次下載模型可能需要一些時(shí)間,建議先去泡杯茶?

第四步:部署auto-prompt平臺

創(chuàng)建 docker-compose.yaml 文件:

version: '3.8'

services:

console-service:

image: registry.cn-shenzhen.aliyuncs.com/tokengo/console

container_name: auto-prompt-service

ports:

- "10426:8080"

environment:

# 配置Ollama API地址

- OpenAIEndpoint=http://host.docker.internal:11434/v1

# 使用SQLite數(shù)據(jù)庫(默認(rèn)配置)

- ConnectionStrings:Type=sqlite

- ConnectionStrings:Default=Data Source=/data/ConsoleService.db

- TZ=Asia/Shanghai

volumes:

- ./data:/data

depends_on:

- ollama

ollama:

image: ollama/ollama

container_name: ollama

ports:

- "11434:11434"

volumes:

- ollama_data:/root/.ollama

restart: unless-stopped

volumes:

ollama_data:

第五步:一鍵啟動

# 啟動所有服務(wù)

docker-compose up -d

# 查看服務(wù)狀態(tài)

docker-compose ps

?? 驗(yàn)證部署

1. 檢查Ollama是否正常

# 測試API

curl http://localhost:11434/api/tags

# 應(yīng)該返回已安裝的模型列表

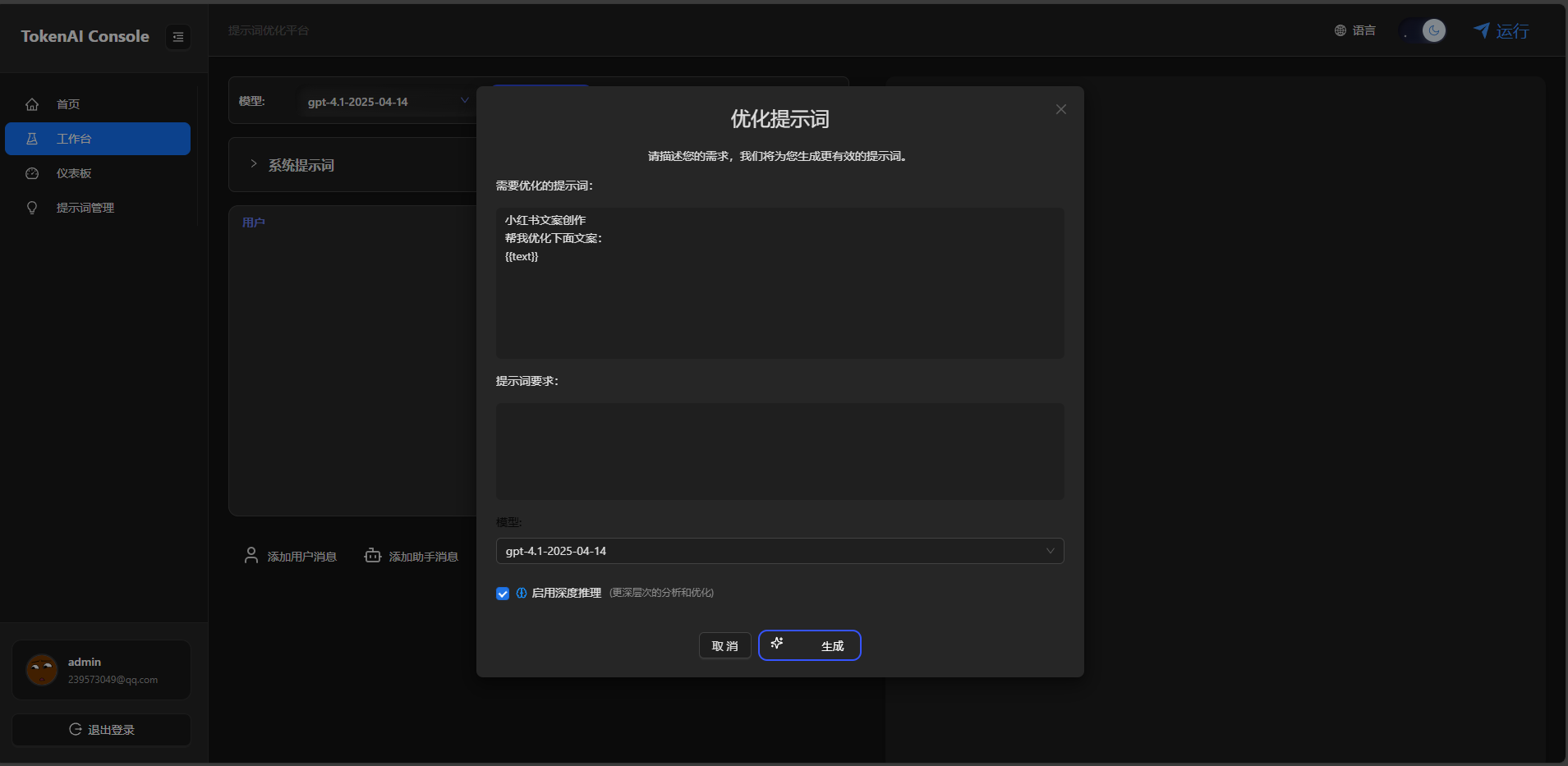

2. 訪問auto-prompt平臺

打開瀏覽器,訪問:http://localhost:10426

你應(yīng)該能看到一個(gè)漂亮的提示詞優(yōu)化界面!

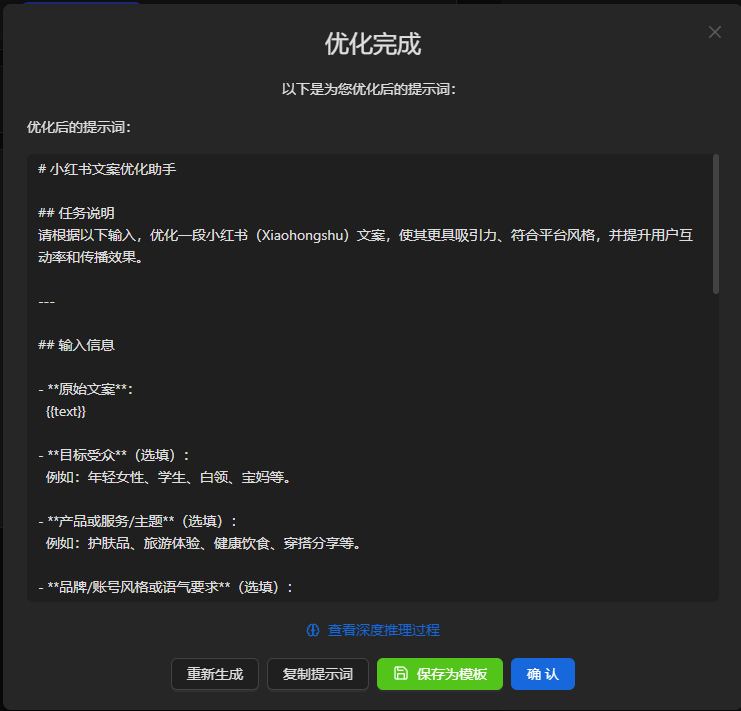

3. 測試提示詞優(yōu)化

在平臺中輸入一個(gè)簡單的提示詞,比如:

你是python專家

點(diǎn)擊"優(yōu)化"按鈕!

?? 高級配置

性能優(yōu)化建議

- GPU加速(如果有NVIDIA顯卡):

# 修改Ollama啟動命令

docker run -d --gpus all \

--name ollama \

-p 11434:11434 \

-v ollama_data:/root/.ollama \

ollama/ollama

- 內(nèi)存配置:

# 在docker-compose.yaml中添加資源限制

deploy:

resources:

limits:

memory: 4G

reservations:

memory: 2G

模型推薦

| 模型 | 大小 | 適用場景 | 內(nèi)存需求 |

|---|---|---|---|

| llama3.2:1b | 1.3GB | 輕量級任務(wù) | 4GB |

| qwen2.5:7b | 4.4GB | 通用任務(wù) | 8GB |

| deepseek-coder:6.7b | 3.8GB | 代碼生成 | 8GB |

?? 常見問題解決

Q1: Ollama連接失敗?

A: 檢查防火墻設(shè)置,確保11434端口開放

Q2: 模型下載很慢?

A: 可以配置國內(nèi)鏡像源:

# 設(shè)置環(huán)境變量

export OLLAMA_HOST=0.0.0.0:11434

Q3: 內(nèi)存不夠用?

A: 選擇更小的模型,或者增加虛擬內(nèi)存

?? 總結(jié)

恭喜你!現(xiàn)在你已經(jīng)擁有了一個(gè)完全私有化的AI提示詞優(yōu)化平臺!

你現(xiàn)在可以:

- ?? 在完全離線的環(huán)境中使用AI

- ?? 優(yōu)化和調(diào)試你的提示詞

- ?? 分析AI的推理過程

- ?? 保存和分享優(yōu)質(zhì)模板

下一步建議:

- 嘗試不同的AI模型

- 探索平臺的高級功能

- 分享你的優(yōu)質(zhì)提示詞模板

?? 相關(guān)資源

- 項(xiàng)目地址:https://github.com/AIDotNet/auto-prompt

- Ollama官網(wǎng):https://ollama.ai

- 模型庫:https://ollama.ai/library

最后的最后:如果這篇文章對你有幫助,別忘了點(diǎn)個(gè)贊??,轉(zhuǎn)發(fā)給更多需要的小伙伴!

有問題歡迎在評論區(qū)討論,我會及時(shí)回復(fù)的~

#AI #Docker #Ollama #提示詞工程 #私有化部署

浙公網(wǎng)安備 33010602011771號

浙公網(wǎng)安備 33010602011771號