吳恩達深度學習課程一:神經網絡和深度學習 第四周:深度神經網絡的關鍵概念

此分類用于記錄吳恩達深度學習課程的學習筆記。

課程相關信息鏈接如下:

- 原課程視頻鏈接:[雙語字幕]吳恩達深度學習deeplearning.ai

- github課程資料,含課件與筆記:吳恩達深度學習教學資料

- 課程配套練習(中英)與答案:吳恩達深度學習課后習題與答案

本篇為第一課第四周的內容,即4.1到4.7的內容。

4.8 這和大腦有什么關系?是吳恩達老師的一個3分鐘拓展,不涉及具體知識,因此就不在筆記里出現了。

本周為第一課的最后一周內容,就像標題一樣,我們從第二周的邏輯回歸,到第三周的淺層神經網絡, 再到本周的深度神經網絡的概念層層遞進,第一課內容主要還是對神經網絡框架的基本介紹,因此本周實際上的主要內容還是對深層神經網絡傳播過程的梳理。

但對于公式的推導,我們在之前的部分已經重復過不止一次了,因此,針對本周的深層神經網絡,我會結合課程內容,盡量少列公式計算,多做概念的推導和理解,并在相關部分附上之前對公式詳細推導內容的鏈接。

本篇即是本周的全部理論內容。

1. 深層神經網絡

1.1深層神經網絡長什么樣?

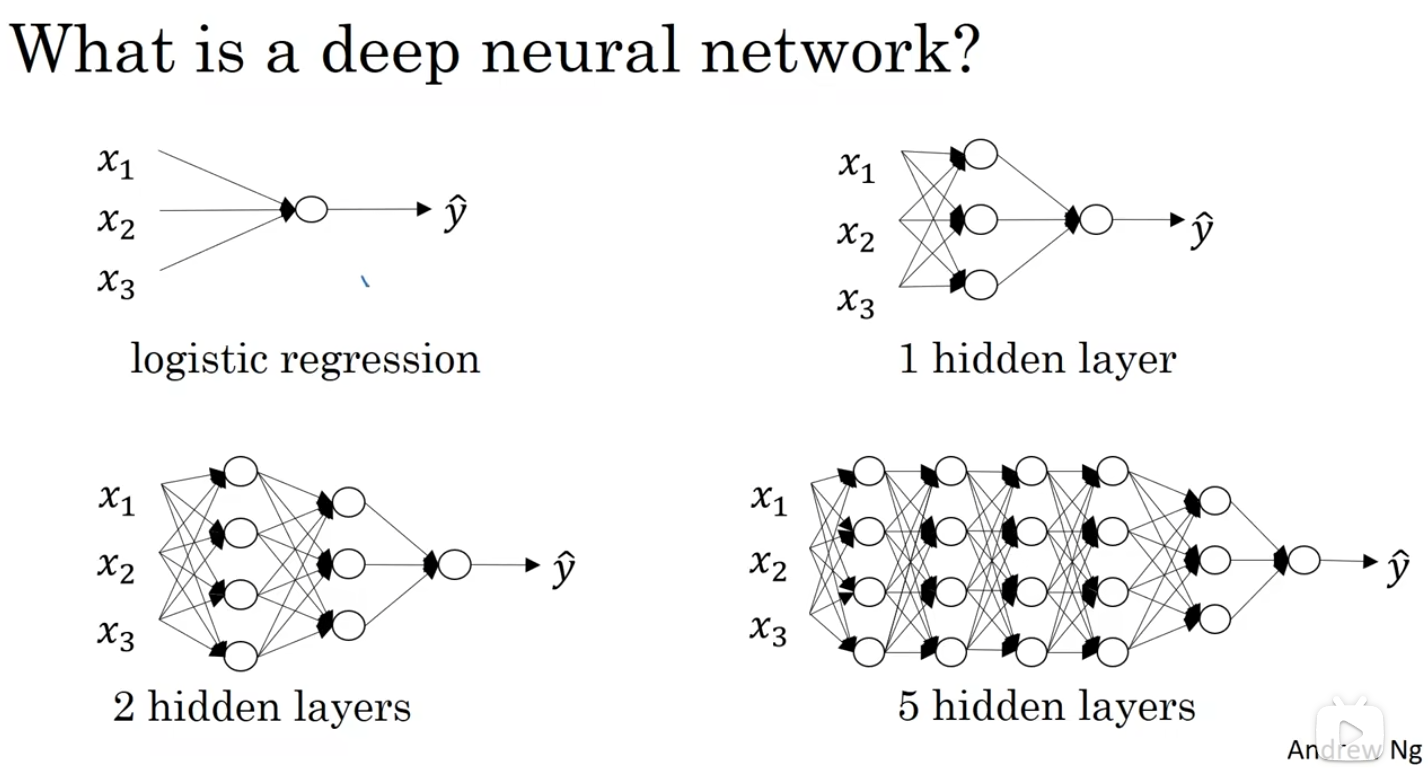

說實話,當進行到這一部分,想必大家也已經猜到深層神經網絡的形狀了,我們直接用課程里的圖:

簡單來說,相比淺層神經網絡,深層神經網絡就是神經元更多,隱藏層更復雜的神經網絡。

1.2 直觀理解深層網絡的效果

依舊看課程里的一張圖:

圖下方的三幅圖可以比較好的表現深層網絡的效果,我們在淺層提取低級特征,而低級特征經過線性組合和激活后有作為下一層的輸入提取更高級些的特征,就像圖里的從邊緣到整張臉。

要說明的一點是圖里的圖像處理實際上更常出現在卷積神經網絡中,這是后面吳恩達老師在這個系列里單獨作為一門的內容。

這里我們只要理解到,隨著網絡規模的增加,更深的層數能讓我們提取更高級的特征即可。

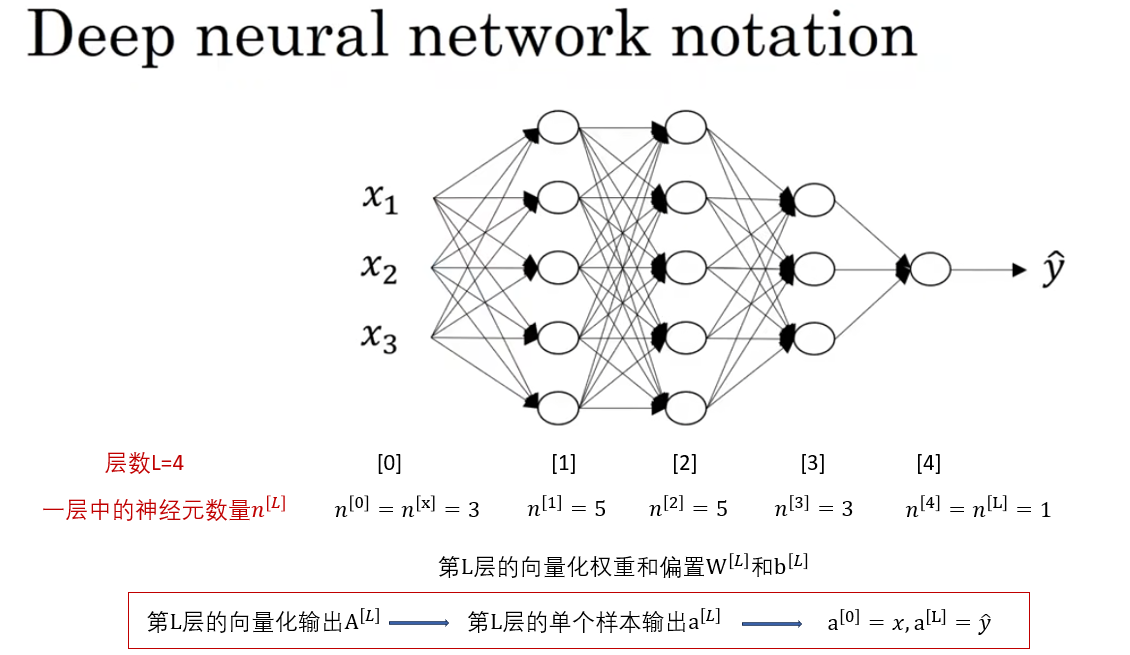

1.3 符號規范

同樣如圖所示,這些符號我們也在之前使用過很多次了,并不陌生,就不再重復描述了。

1.4 深層神經網絡的正向傳播

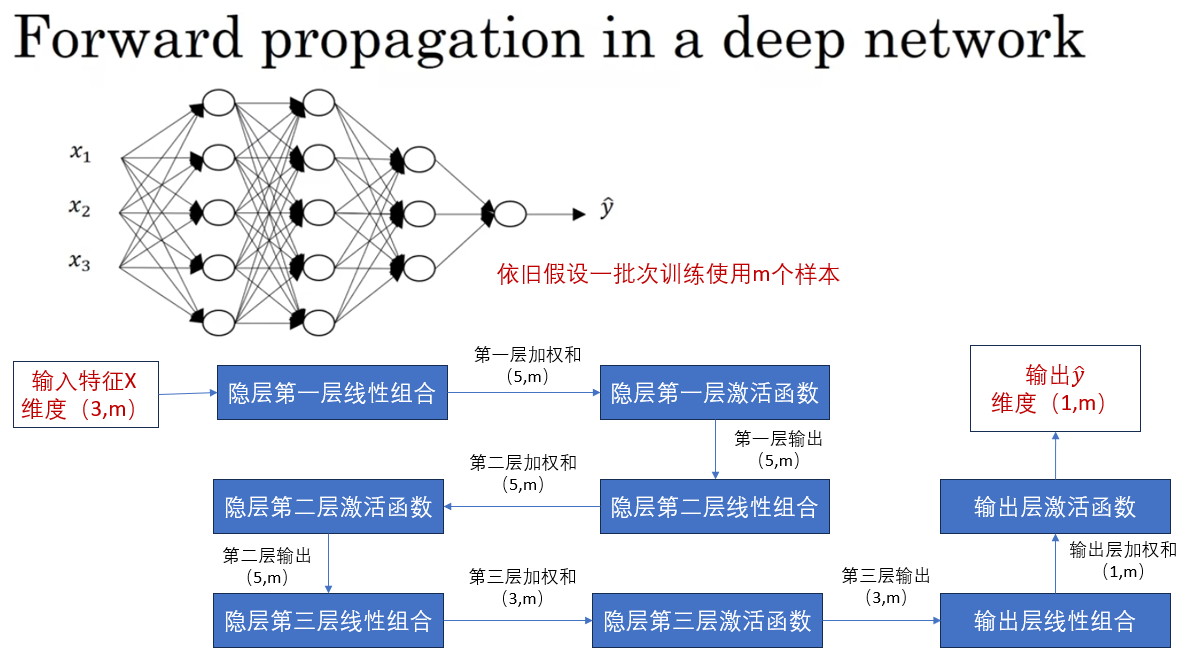

我們用剛剛的網絡為例:

我在圖中繪制了這個網絡從輸入到最終輸出的向量化正向傳播過程,待會我們會再補充上反向部分。

不難發現,這只是之前的淺層神經網絡中又增加了兩個隱藏層傳播。

我們之前在淺層神經網絡中已經推導過這部分的公式計算了,就不再展開了。

正向傳播的詳細公式推導在這里

1.5 向量化神經網絡中的維度變化

我們已經計算過不少次輸入在神經網絡里的傳播,在向量化的計算過程中往往使用矩陣乘法來實現并行計算,這也就伴隨著維度的變化。

這里便總結一下維度變化的規律:

先看貫穿始終的兩個公式:

首先,這里的 \(\mathbf{W^{[L]}}\) 的維度應該是\((該層的神經元數量,輸入該層樣本的特征數)\)

這是因為\(W\)每行的元素個數應和輸入的特征數相等,作為每一個特征的權重。

而每多一個神經元就會多一次這樣的行為。

推廣起來,用符號表示就是:

于此同時,每有一組權重,就會有與之配合的一個偏置,因此:

現在,我們通過矩陣乘法即可計算得到:

而激活函數和求導都不會改變輸入維度,所以:

我們總結一下:

| 量 | 維度 |

|---|---|

| \(\mathbf{W^{[L]}}\) | \((n^{[L]},n^{[L-1]})\) |

| \(\mathbf{b^{[L]}}\) | \((n^{[L]},1)\) |

| \(\mathbf{Z^{[L]}}\) | \((n^{[L]},m)\) |

| \(\mathbf{A^{[L]}}\) | \((n^{[L]},m)\) |

| 導數 | 與求導量維度相同 |

2.模塊化網絡傳播

我們通常在代碼里才說模塊化,這代表著我們對一些需要重復使用的函數進行了一定程度的封裝,或者干脆定義了一些對象。

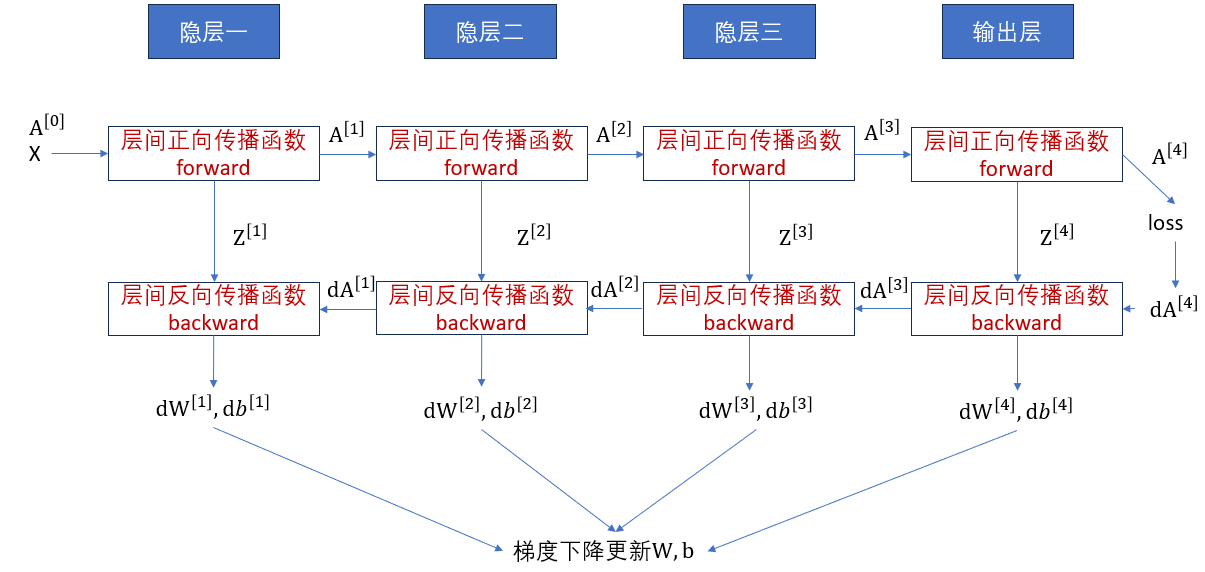

那么當網絡深度不斷增加,那層級之間的正向傳播和反向傳播也在不斷重復,因此進行模塊化也就十分必要,我們來簡單看一看這個框架。

2.1.文字傳播

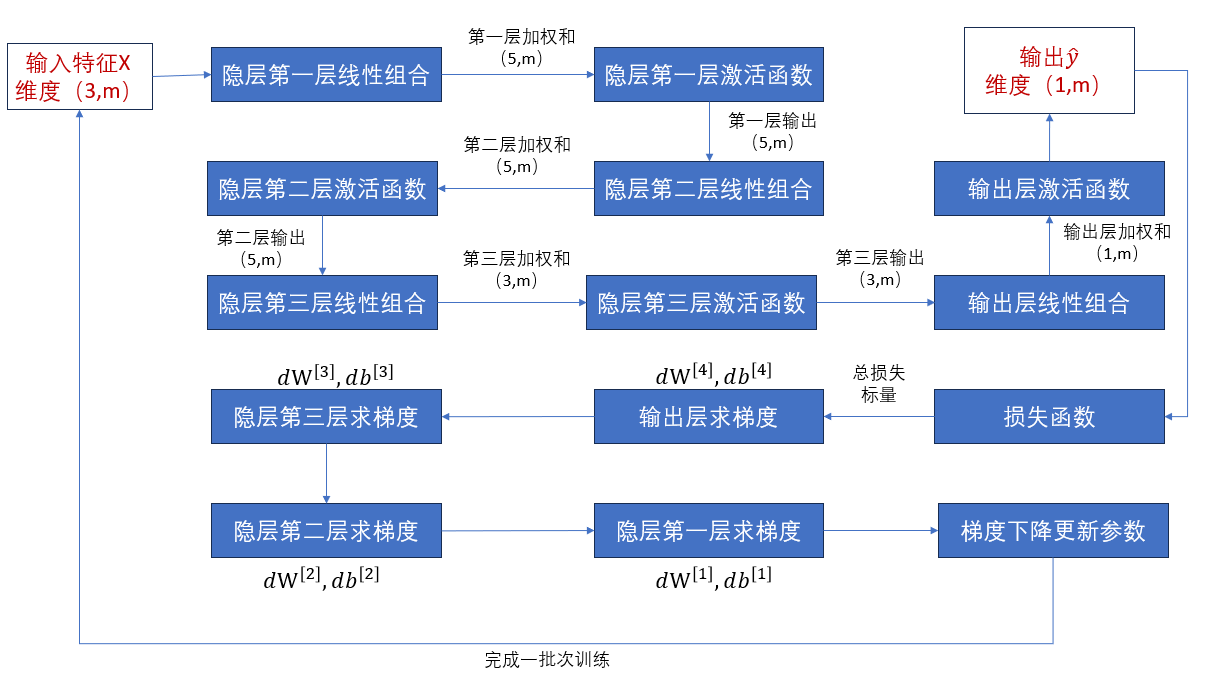

我們先補充完剛剛的傳播過程,用文字理順一下各個量的傳遞。

這便是上面的網絡結構一批次訓練的完整傳播過程。

反向傳播的詳細推導過程在這里

理順邏輯后,我們把這個過程模塊化,用函數,函數的參數,函數的輸出的格式再來看一看。

2.2 模塊化函數

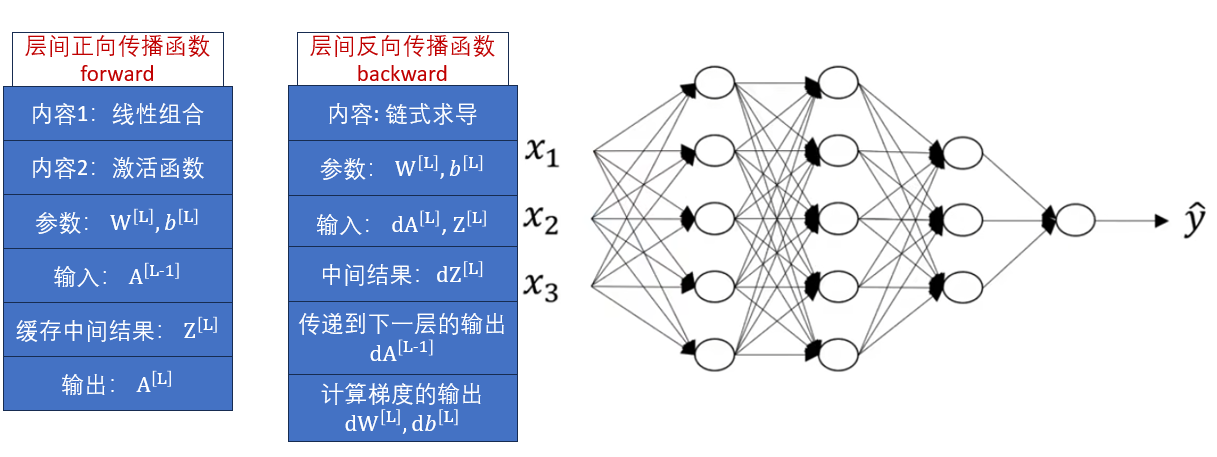

我們定義層間的正向傳播函數forward和反向傳播函數backward如下:

直接解釋兩個函數的各個屬性可能不太清晰,我們直接用右側的網絡來演示這兩個函數的使用。

2.3 模塊化傳播流程

對比圖中的過程,我們就可以比較容易的理順模塊化后的傳播。

2.4 總結

以上便是第四周課程的全部內容,課程里還提到了超參數的概念,我們在第二周的習題實踐部分就已經對其進行了介紹,就不再重復了。

總的來說,經過較多的基礎補充,第四周的內容并不多,我們從淺層神經網絡再拓展到深層一些的神經網絡,并對傳播過程中的計算變化進行了總結,給編碼實現提供了思路。

下一篇就是本周課程的習題和編碼,同時也是課程一的最后一篇。

浙公網安備 33010602011771號

浙公網安備 33010602011771號