最近發現了一個讓人眼前一亮的工具——FramePack,它能用一塊普通的6GB顯存筆記本GPU,生成60秒電影級的高清視頻畫面,效果堪稱炸裂!那么我們就把他本地部署起來玩一玩、下載離線一鍵整合包,或者是用云算力快速上手。接下來,我帶大家看看FramePack的硬核實力,以及如何用它讓一張靜態美女圖片“舞動”起來!

實際效果怎么樣?先來個小實驗!

想生成一段高質量視頻,起點自然是一張高質量圖片。你可以先用Stable Diffusion 或者 Midjourney生成了一張精美的美女寫實圖片。接下來,用FramePack讓這張靜態圖片“動起來”,變成一段優雅的舞蹈視頻。

實驗步驟:

-

生成靜態圖片:用Stable Diffusion或 Midjourney 生成一張高分辨率美女圖片。

![]()

-

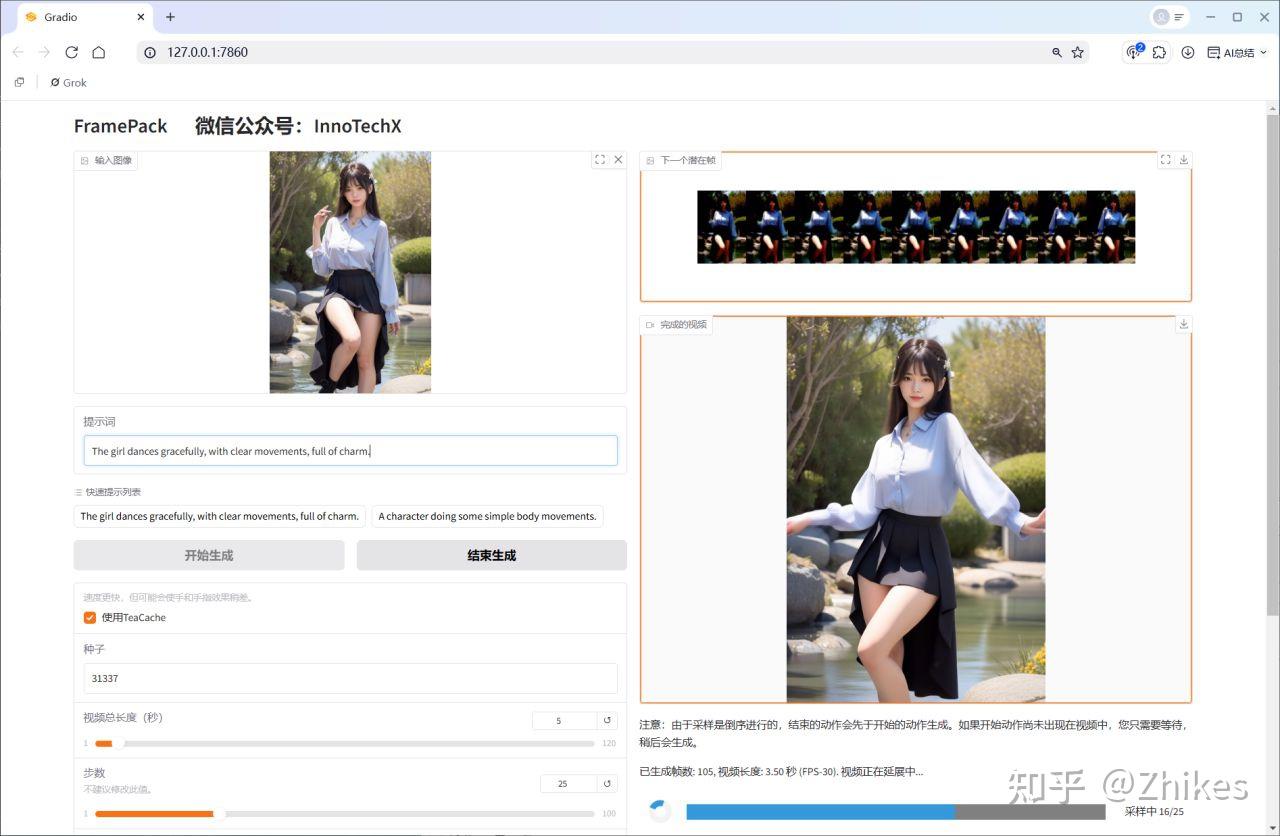

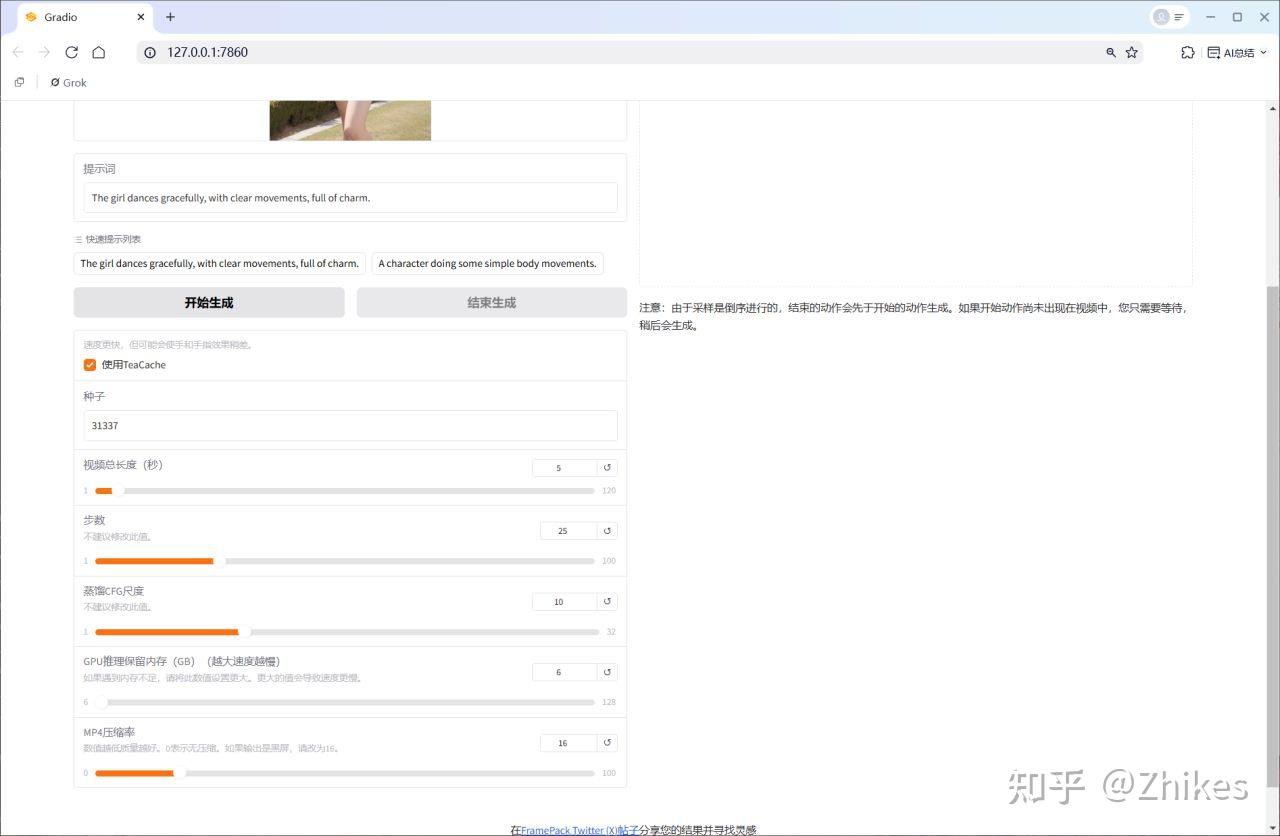

FramePack上場:將圖片上傳到本地部署/云算力的FramePack網頁。

![]()

-

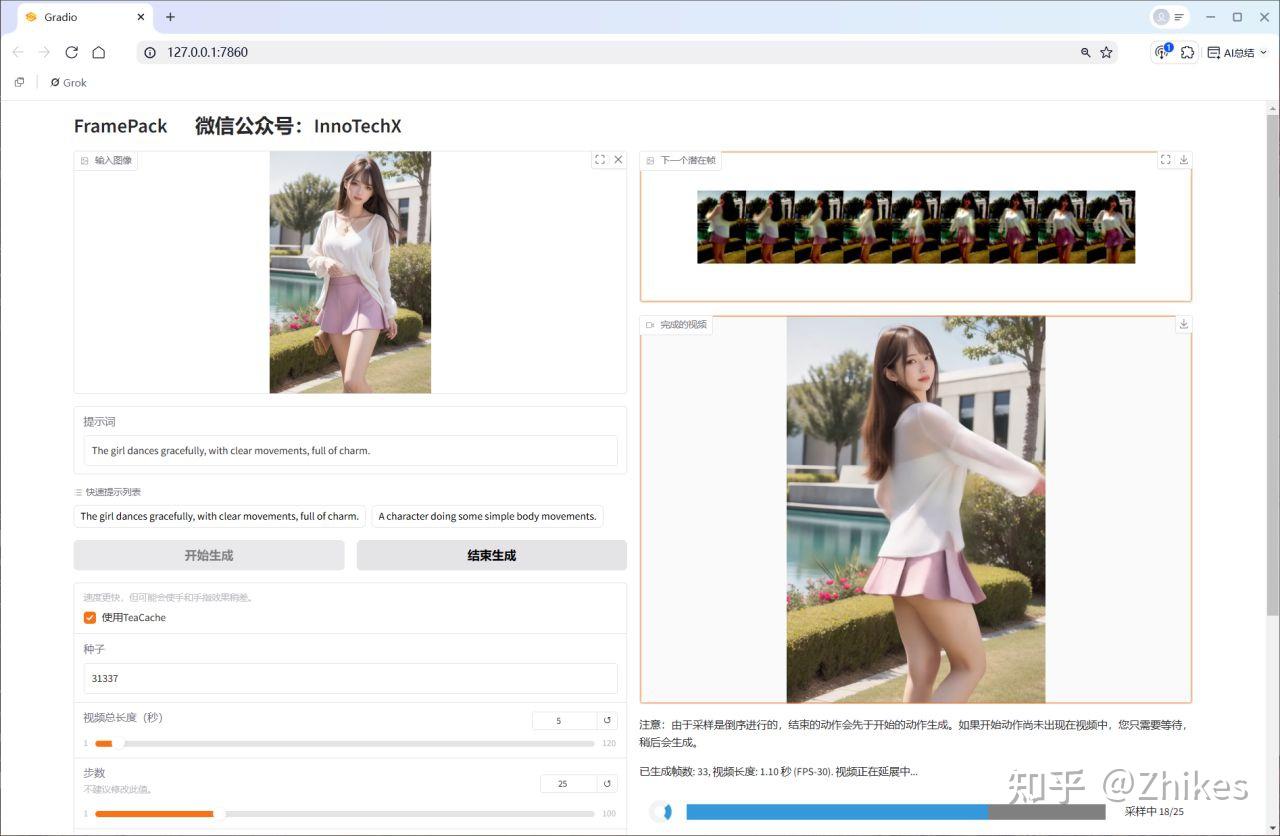

生成視頻:運行后,FramePack逐幀預測,畫面流暢,動作自然,宛如電影鏡頭!

![]()

生成過程中,你可以實時看到每一幀的生成效果,這種即時反饋真的太友好!

生成結果如下

https://mp.weixin.qq.com/s/k_4F_bzP_bnUPaRqFrCXTA (公眾號查看)

下面在使用相同圖片在可靈上生成,看下對比效果。

可靈2.0 大師版 VS FramePack

可靈生成結果如下(公眾號可看效果)

FramePack是什么?為什么這么強?

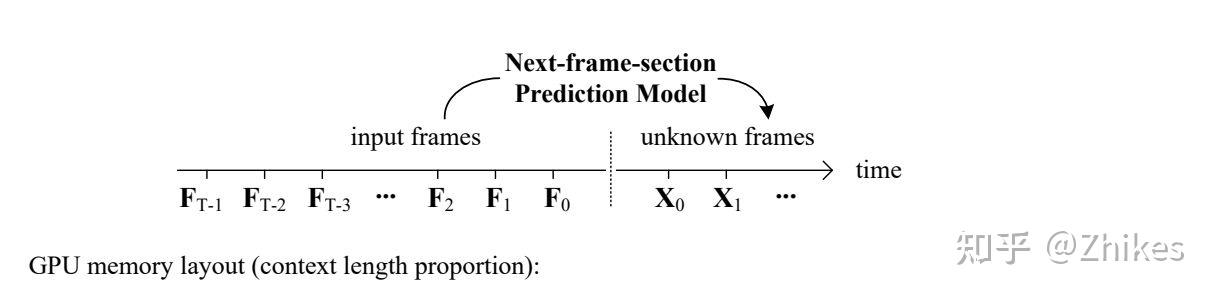

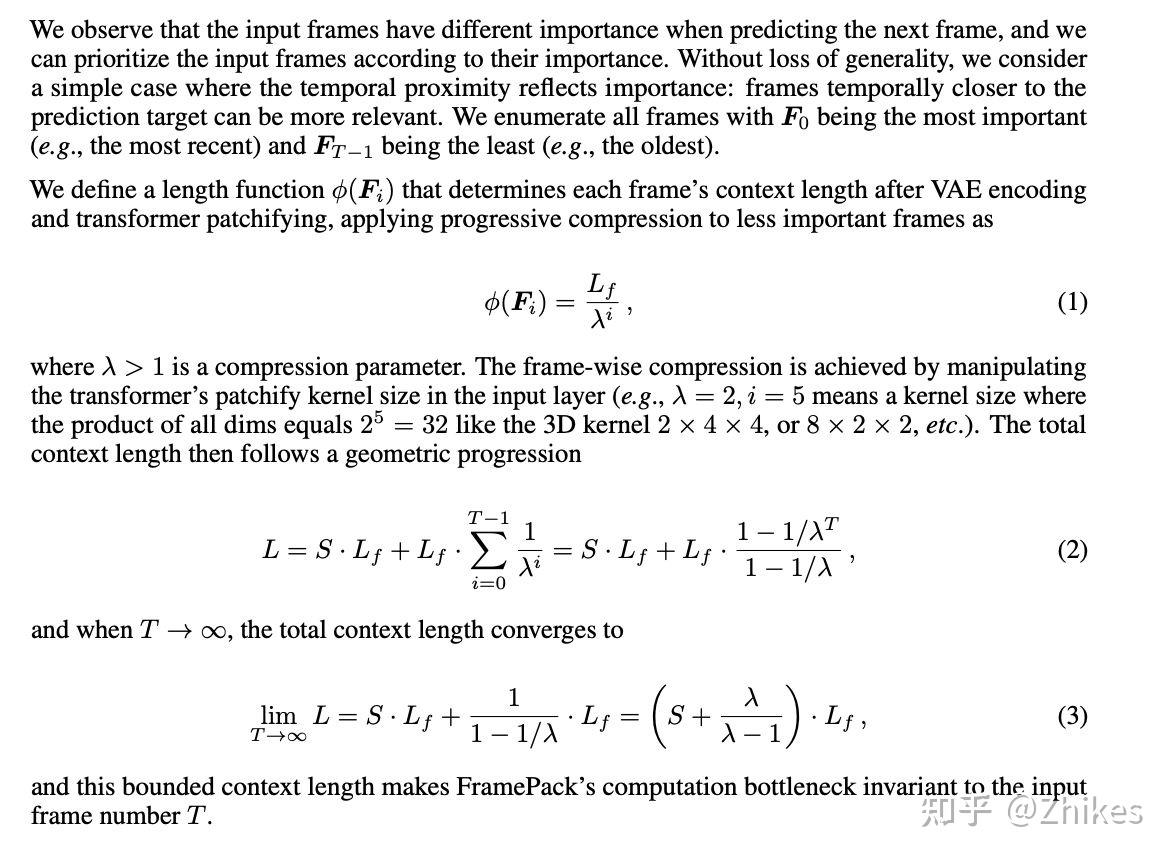

FramePack是由斯坦福大學張律敏和Maneesh Agrawala團隊開發的一種神經網絡結構,專門為視頻生成優化。它通過預測“下一幀”或“下一幀段”,讓視頻生成變得高效又高質量。核心亮點有以下幾點:

1. 高效的神經網絡設計

FramePack通過一種獨特的壓縮技術,將輸入幀的上下文長度固定為一個常數,完全不受視頻長度的限制。這意味著:

-

它能輕松處理超多幀,計算開銷跟圖像擴散模型差不多。

-

訓練時可以大幅增加視頻批次大小,接近圖像擴散模型的訓練規模,效率直接拉滿。

2. 反漂移采樣,告別誤差累積

FramePack提出了一種“倒序時間生成”的新方法,提前設定視頻的起點和終點。這種反漂移采樣技術可以:

-

有效減少生成過程中的誤差累積,避免畫面“跑偏”。

-

讓視頻的視覺質量更穩定,細節更清晰。

3. 對現有模型的“即插即用”改進

如果你已經在用其他視頻擴散模型,FramePack可以無縫微調現有模型。它優化了擴散調度,減少了極端時間步的偏移,顯著提升畫面質量。

4. 筆記本GPU也能玩轉

最讓人震驚的是,FramePack只需要6GB顯存就能生成60秒、30fps(共1800幀)的高清視頻!這意味著你用一臺普通的RTX 3060筆記本就能體驗電影級視頻生成,門檻低到飛起。

FramePack的硬件需求和運行速度

FramePack的硬件門檻低得讓人感動,但也有一些基本要求:

硬件要求:

-

GPU:Nvidia RTX 30XX/40XX/50XX系列(支持fp16和bf16)。GTX 10XX/20XX未測試。

-

操作系統:Linux或Windows。

-

顯存:最低6GB(是的,6GB也可以!)。

-

推薦配置:用13B模型生成60秒、30fps視頻,6GB顯存完全hold得住。

運行速度:

-

在RTX 4090臺式機上,未優化時每幀約2.5秒,優化后(teacache)可達1.5秒。

-

在RTX 3070ti或3060筆記本上,速度大約是臺式機的1/4到1/8,但依然流暢。

-

得益于“下一幀預測”設計,你能邊生成邊看到畫面,體驗感滿分。

怎么上手FramePack?

提供了三種部署方式,滿足不同需求:

1. 本地部署

適合喜歡自己動手的技術愛好者,步驟簡單:

# 創建并激活conda環境

conda create -n FramePack python=3.10

conda activate FramePack

# 克隆倉庫

git clone https://github.com/lllyasviel/FramePack.git

cd FramePack

# 安裝依賴

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118

pip install -r requirements.txt

# 運行Demo

python demo_gradio.py

2. 離線一鍵整合包

不想折騰環境?直接用離線包!關注“衛星公眾號”,回復“FramePack”,下載解壓后即可開跑,省時省力。

3. 云算力部署

如果你本地部署,甚至是一鍵整合包都失敗的情況,那么你只有使用云算力快速體驗,這個是非常簡單并且不會失敗的方法。

-

鏡像地址:https://www.xiangongyun.com/image/detail/85454460-f2d5-4146-91fe-a501096e747d

-

部署教程:https://mp.weixin.qq.com/s/kwzpFrIfR8F6i2kcr3rJvw 參考此鏈接,基本操作差不多。

-

部署過程只需2-3分鐘,簡單到不行。

為什么FramePack這么值得一試?

FramePack不僅技術硬核,還非常接地氣:

-

低門檻:6GB顯存就能跑,普通筆記本也能玩。

-

高效率:上下文壓縮和反漂移采樣讓生成又快又好。

-

更重要的是,FramePack讓視頻生成變得像圖像生成一樣簡單高效,為長視頻創作打開了新大門。無論是想做一部短片、動畫,還是給靜態圖片加點動態魔法,FramePack都能幫你實現。

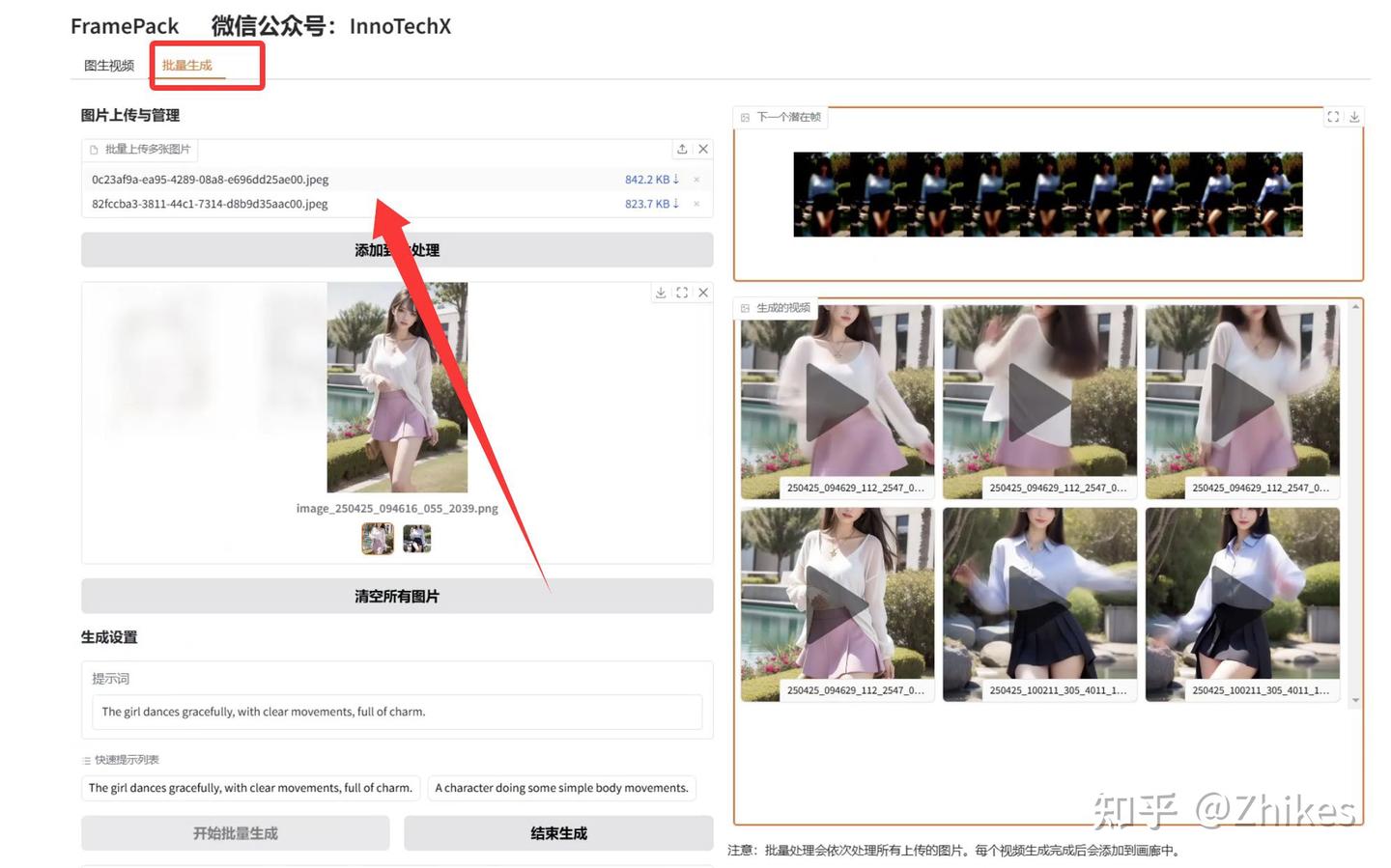

避免生成的效果達不到自己想要的,需要重復抽卡,所以修改了代碼,支持批量生成。

一鍵整合包:點擊一鍵啟動包的一鍵啟動后,點擊批量生成,上傳多張圖片,即可實現批量處理。

云算力部署:部署在仙宮云的鏡像也支持批量操作。

FramePack用6GB顯存就能生成60秒電影級視頻,這性價比簡直無敵。它的神經網絡設計高效又聰明,反漂移采樣讓畫面質量更上一層樓。

快去試試吧!用一張美女圖片,配合FramePack,生成一段屬于你的電影級視頻,絕對驚艷!效果媲美可靈大師版2.0,最重要的是免費!!!還要啥自行車!

有啥問題,或者部署上的問題,歡迎加入星球得到支持快速解決你的問題https://t.zsxq.com/8RmqH

浙公網安備 33010602011771號

浙公網安備 33010602011771號