今天要聊一聊AI文生視頻的最新進展。一直以來,AI生成視頻對硬件的要求都讓人望而卻步,尤其是家用顯卡,總是感覺“心有余而力不足”。

AI文生視頻以前 基本需要的顯存大概幾十上百G

但最近,阿里開源的 Wan2.1 徹底改變了這一局面!它不僅讓普通消費級GPU也能輕松生成視頻,還能在短短10分鐘左右搞定一段480P的視頻。這讓我這個技術愛好者忍不住想跟大家分享一下它的魅力,順便奉上 離線一鍵包 和 本地部署教程,讓你零門檻上手!

官方示例

我生成貓貓打拳

我生成怪獸打奧特曼(這個指定是失敗作品)

最新動態:Wan2.1強勢來襲

就在幾天前,2025年3月3日,Wan2.1迎來了一次大更新:它的 T2V(文本轉視頻) 和 I2V(圖像轉視頻) 功能正式集成到了 Diffusers 框架中(T2V | I2V)。這意味著你可以用更簡潔的方式調用它,社區支持也更豐富了。如果你還沒試過,現在正是時候!

Wan2.1是什么?為什么這么火?

Wan2.1 是由阿里團隊打造的一款開源大型視頻生成模型,基于目前最流行的 擴散變換器(Diffusion Transformer) 技術。它通過一系列創新,比如獨特的 時空變分自編碼器(Wan-VAE)、高效的訓練策略和海量數據處理,硬是把視頻生成能力推到了一個新高度。簡單來說,它不僅性能炸裂,還特別“親民”,讓家用顯卡也能玩得轉。

核心亮點

- SOTA 性能:Wan2.1在多個基準測試中始終優于現有的開源模型和最先進的商業解決方案。

- 支持消費級 GPU:T2V-1.3B 型號僅需 8.19 GB VRAM,可兼容幾乎所有消費級 GPU。它可在約 4 分鐘內(未使用量化等優化技術)在 RTX 4090 上生成 5 秒的 480P 視頻。其性能甚至可與一些閉源模型相媲美。

- 多項任務:Wan2.1在文本轉視頻、圖像轉視頻、視頻編輯、文本轉圖像和視頻轉音頻方面表現出色,推動了視頻生成領域的發展。

- 視覺文本生成:Wan2.1是第一個能夠生成中英文文本的視頻模型,具有強大的文本生成功能,可增強其實際應用。

- 強大的視頻 VAE:Wan-VAE提供卓越的效率和性能,可對任意長度的 1080P 視頻進行編碼和解碼,同時保留時間信息,使其成為視頻和圖像生成的理想基礎。

技術細節揭秘

- 3D因果VAE(Wan-VAE)

Wan團隊設計了一種全新的架構,通過時空壓縮和優化內存使用,讓視頻生成既高效又穩定。相比其他開源VAE,它的性能提升不是一點半點。 - 視頻擴散DiT

Wan2.1 用的是 Flow Matching 框架,搭配 T5 編碼器處理多語言輸入,再加上跨注意力機制和共享MLP調制參數,硬生生把生成質量拉到了新高度。 - 與頂尖模型的較量

他們用1035個內部測試提示,覆蓋14個大維度和26個子維度,做了全面對比。結果顯示,Wan2.1 不管是開源還是閉源對手,都能穩穩勝出。

本地部署教程:手把手教你玩轉 Wan2.1

好了,廢話不多說,直接上干貨!以下是我整理的本地部署步驟,簡單易懂,保證你能快速上手。

1. 準備環境

首先,我們得搭個干凈的運行環境,用 Conda 創建一個虛擬環境是個好習慣:

conda create -n wan python=3.10

conda activate wan

2. 克隆項目

把 Wan2.1 的代碼拉下來:

git clone https://github.com/Wan-Video/Wan2.1.git

cd Wan2.1

3. 安裝依賴

依賴文件在 requirements.txt 里,但有些細節得注意:

打開 requirements.txt,先把這3行注釋掉,避免安裝出錯:

# flash_attn

# torch>=2.4.0

# torchvision>=0.19.0

然后運行:

pip install -r requirements.txt

單獨安裝 Torch 和 Torchvision

如果你用的是 CUDA 12.6,可以這樣:

pip install torch torchvision --index-url https://download.pytorch.org/whl/cu126

對應上你自己本地cuda版本即可

4. 安裝基于Windows的flash_attn,下載對應的cuda124 torch2.6 版本 到當前目錄

Windows 用戶可以去 https://github.com/kingbri1/flash-attention/releases?page=2 下載適合的版本,比如我用的是 CUDA 12.4 + Torch 2.6 的輪子:

我本地電腦的cuda是12.6,但是高版本兼容低版本,沒有問題

下載完,復制到當前文件目錄安裝即可

pip install flash_attn-2.7.4.post1+cu124torch2.6.0cxx11abiFALSE-cp310-cp310-win_amd64.whl

5. 下載模型

用 ModelScope 下載 T2V-1.3B 模型:

pip install modelscope

modelscope download Wan-AI/Wan2.1-T2V-1.3B --local_dir ./Wan2.1-T2V-1.3B

6. 生成你的第一個視頻

用官方示例跑一下試試:

python generate.py --task t2v-1.3B --size 832*480 --ckpt_dir ./Wan2.1-T2V-1.3B --prompt "Two anthropomorphic cats in comfy boxing gear and bright gloves fight intensely on a spotlighted stage."生成后,你會在目錄里找到一個 MP4 文件,打開看看效果吧!

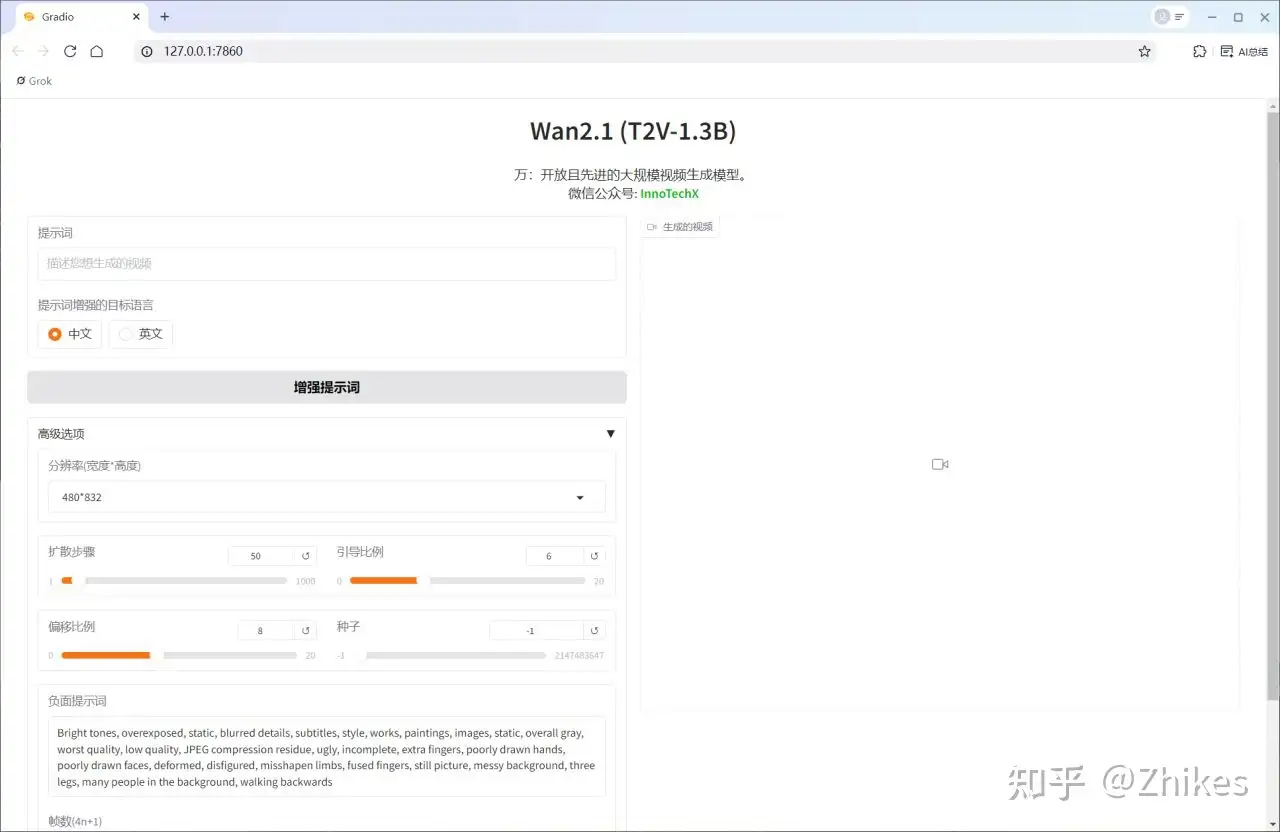

7. 啟動 Gradio 界面

想更方便地操作?試試 Gradio 的本地界面:

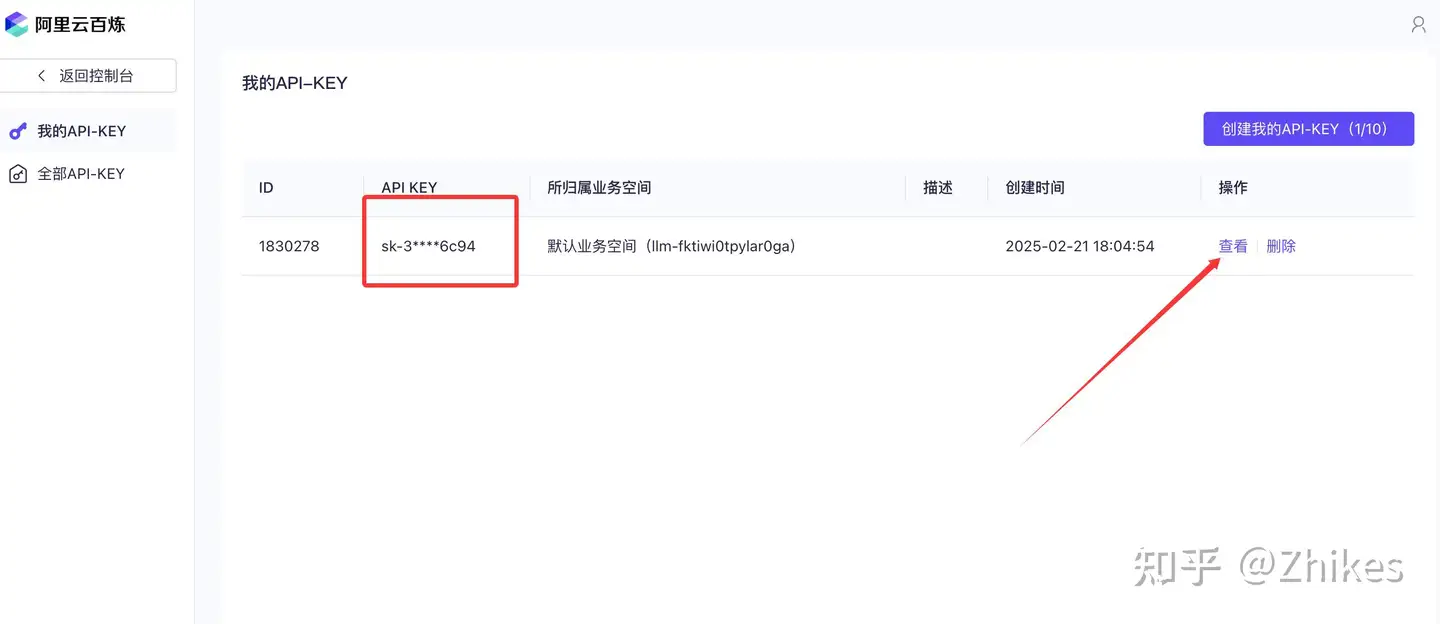

這里順便啟動qwen模型的API接口,豐富提示詞

阿里云百煉API申請地址

https://bailian.console.aliyun.com/?spm=a2c4g.11186623.0.0.266b4823b4SU8P#/model-market

cd gradio

Windows:

set DASH_API_KEY=sk-xxxxxxxxx

python t2v_1.3B_singleGPU.py --prompt_extend_method dashscope --ckpt_dir ./Wan2.1-T2V-1.3BLinux:

DASH_API_KEY=your_key python t2v_1.3B_singleGPU.py --prompt_extend_method dashscope --ckpt_dir ./Wan2.1-T2V-1.3B

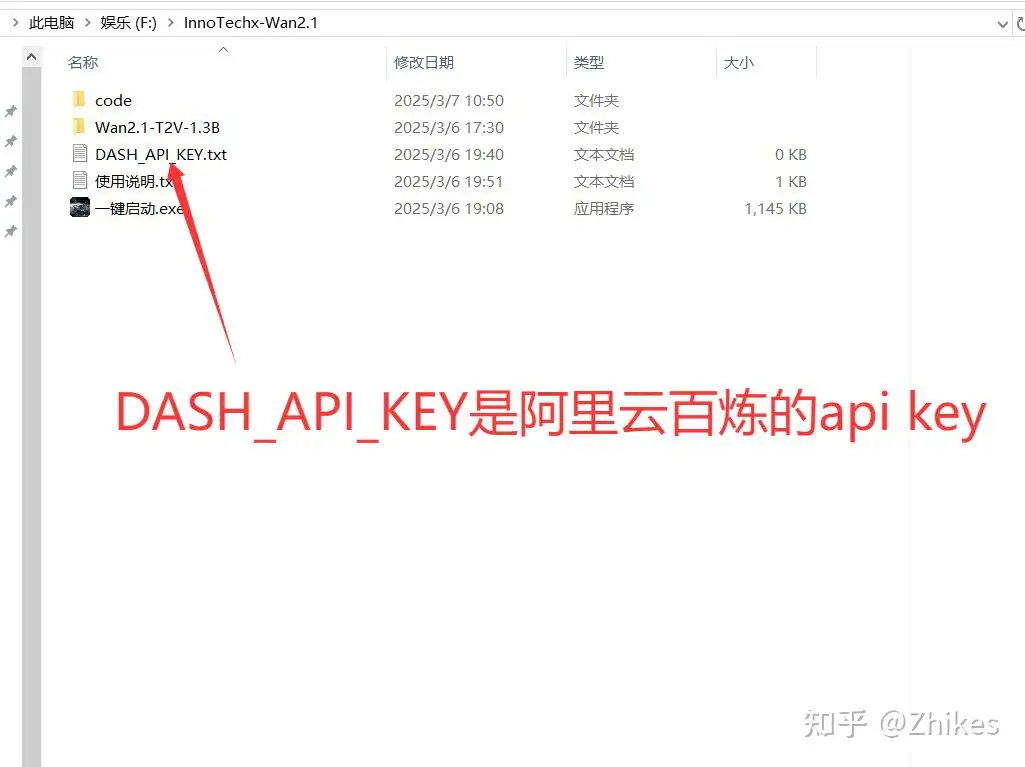

一鍵啟動包:懶人福音

為了讓大家少折騰,我還準備了一個 一鍵啟動包,直接解壓運行就能用。

英偉達顯卡30系及以上的的顯卡,8G及以上。顯卡不好還是不要嘗試了。

如果需要豐富提示詞的,就去申請,申請后填入文本即可。

類似這樣的

sk-xxxxxxxxxxxx

申請地址

https://bailian.console.aliyun.com/?spm=a2c4g.11186623.0.0.266b4823b4SU8P#/model-market

一鍵包獲取方式:

wx公眾號 InnoTechX

發送: wan

也可以丟給AI去豐富提示詞,那就不用管他。直接一鍵啟動即可

幾個關鍵參數說明一下:

- frame_num(默認81):控制視頻幀數,必須是 4n+1 的形式。幀數多視頻就長,但生成時間也增加。

- shift(默認5.0):調整噪聲調度,影響動態效果。調小點會更平滑,調大點動態更明顯。

- sample_solver(默認'unipc'):采樣算法,unipc 又快又好,其他選項像 ddim 也可以試試。

- sampling_steps(默認50):去噪步數,越多質量越好,但也越慢。

- guide_scale(默認5.0):控制提示詞的嚴格程度,值越大越貼近描述。

如果啟動報錯,尤其是顯卡不支持 FlashAttention

提示RuntimeError: FlashAttention only supports Ampere GPUs or newer

那就是

GTX 10xx/20xx 等較舊的 GPU 不適用于此版本的 FlashAttention,那只能另找途徑,或者去萬人同騎的huggingface和modelscope官網玩兒。

在線體驗:

https://huggingface.co/spaces/Wan-AI/Wan2.1

https://modelscope.cn/studios/Wan-AI/Wan-2.1

AI文生視頻的“江湖”現狀

Wan2.1 這么強,你覺得 它在AI文生視頻領域算老幾?

- Sora (OpenAI)

高質量、電影感強,但目前門檻高,普通人摸不到。 - Pika Labs

易用又靈活,社區口碑好,適合個人創作者。 - Vidu (清華大學)

國產黑馬,長視頻和高動態性很強,中文用戶福音。 - 智譜清言 (CogVideoX)

高清快生成,專業玩家首選,但硬件要求不低。 - Runway Gen-2

多功能創意工具,設計圈的寵兒。 - 快手可靈

短視頻利器,接地氣又好上手,社交媒體創作者的最愛。

浙公網安備 33010602011771號

浙公網安備 33010602011771號