ollama系列01:輕松3步本地部署deepseek,普通電腦可用

本文主要介紹如何通過ollama快速部署deepseek、qwq、llama3、gemma3等大模型,網速好的小伙伴10分鐘就能搞定。讓你擺脫GPU焦慮,在普通電腦上面玩轉大模型。

安裝指南(無廢話版)

第一步:安裝ollama

我們可以從官網下載ollama,此步驟支持windows、mac、ubuntu操作系統,此處僅以windows作為演示。

打開ollama官網:https://ollama.com 點擊download按鈕進行下載,下載完成后點擊安裝。

安裝完成后,你的電腦右下角會有ollama的圖標(如果沒有看到,可以展開折疊的狀態欄檢查)

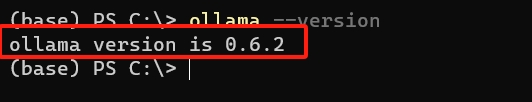

驗證安裝是否成功:打開命令行(WIN+R,在運行中輸入cmd后回車),輸入ollama --version,如果命令執行成功,并輸出了版本信息,說明安裝成功了。

第二步:下載deepseek

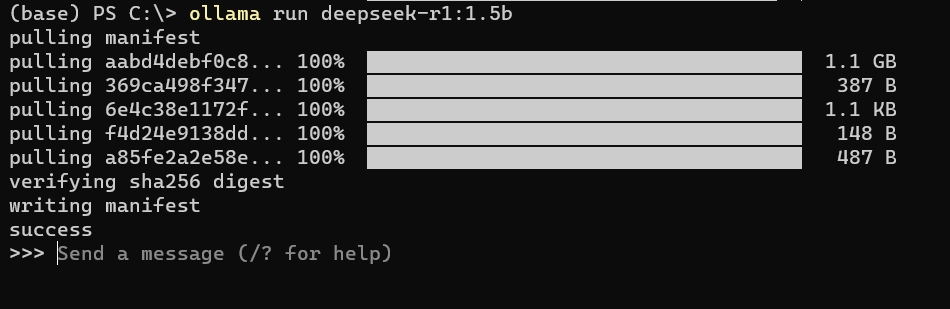

打開命令行(WIN+R,在運行中輸入cmd后回車),下載并運行deepseek-r1 1.5b蒸餾版。

ollama run deepseek-r1:1.5b

下載完成后,ollama會為我們運行剛下載的大模型。下面是我運行成功的截圖:

第三步:使用大模型

恭喜你已經在本地成功安裝了第一個私有大模型。運行成功以后,我們可以直接在命令行和deepseek對話。

如你所見,這就是一個簡單的對話窗口,也是大模型最原始的形態。

在本系列的后面章節中,我們會介紹如何使用工具來和大模型進行交互,構建專屬于你的、數據安全的、私有可定制的AI工具集。

關注[拓荒者IT]公眾號,獲取最新內容,文末有福利。

內容講解(干貨)

ollama是什么?

Ollama 是一款開源工具,能讓你在個人電腦上本地運行各種大語言模型(如 DeepSeek、QwQ等)。

簡單說,它像是一個“離線版DeepSeek”,無需聯網就能用AI聊天、寫代碼或處理文檔。

下載模型后,電腦斷網也能用,數據隱私更有保障。支持命令行操作,開發者能快速測試模型效果,或集成到自己的項目中。

適合技術愛好者、想保護隱私的用戶,或需要定制AI功能的人。開源免費,對硬件要求不高,普通電腦也能跑小模型。

ollama常用的指令

| 命令 | 描述 |

|---|---|

ollama serve |

啟動 Ollama |

ollama create |

從 Modelfile 創建模型 |

ollama show |

顯示模型信息 |

ollama run |

運行模型 |

ollama stop |

停止正在運行的模型 |

ollama pull |

從注冊表中拉取模型 |

ollama push |

將模型推送到注冊表 |

ollama list |

列出所有模型 |

ollama ps |

列出正在運行的模型 |

ollama cp |

復制模型 |

ollama rm |

刪除模型 |

ollama help |

顯示任意命令的幫助信息 |

| 標志 | 描述 |

|---|---|

-h, --help |

顯示 Ollama 的幫助信息 |

-v, --version |

顯示版本信息 |

獲取更多模型

在ollama官網,有非常多的開源模型供我們選擇,地址:https://ollama.com/search

在模型列表中,我們點擊deepseek-r1,打開頁面如下:

選擇自己電腦適配的模型大小,然后復制右側的啟動命令,在命令行執行即可。

總結

本文介紹了如何使用ollama本地部署DeepSeek等大模型,通過干貨分享了ollama常用的指令,以及如何獲取更多大模型。

但是我們目前仍然只是在命令行使用大模型,非常的不友好。下一章我們將介紹如何擺脫命令行的束縛,將ollama集成到本地的AI工具中,實現聊天、自定義智能體等功能。

?? 關注我,持續分享AI工具,AI應用場景,AI學習資源 ??

浙公網安備 33010602011771號

浙公網安備 33010602011771號