【打造自己的 DeepSeek】第 2 期:怎么安裝自己的 DeepSeek?

上一期介紹了為什么要打造自己的 DeepSeek,本期將介紹怎么安裝自己的 DeepSeek。

這里要使用的工具是 Ollama。

它是一個免費開源的本地大語言模型運行平臺,可以幫我們把 DeepSeek 模型下載到我們自己的電腦上運行,支持 Windows、MacOS 和 Linux 三大主流操作系統(本月 8 日,華為發布了鴻蒙電腦操作系統,相信在不久的將來,Ollama 也會支持)。

具體的部署步驟如下:

一、下載 Ollama

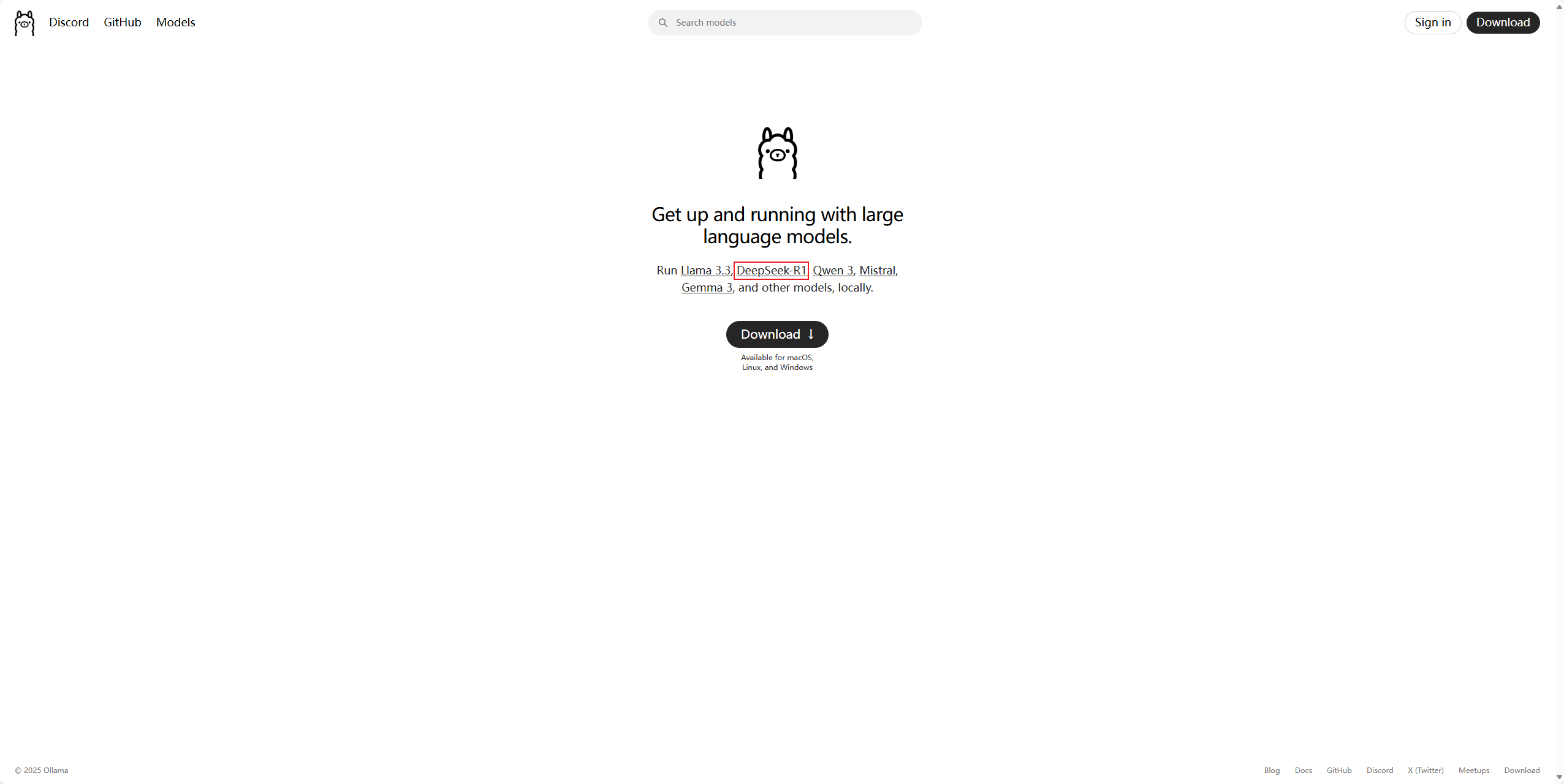

- 訪問 Ollama 官網:www.ollama.com

可以看到,除了 DeepSeek R1,它還支持很多其他的開源模型。

至于為什么沒有大名鼎鼎的 ChatGPT,當然是因為它不開源了(研發它的公司叫做 OpenAI,以 Open 為名,卻從不開源,應該叫 “CloseAI” 才是)。

這里以部署 DeepSeek R1 為例,其他開源模型部署的步驟是大同小異的,大家可以自行嘗試。

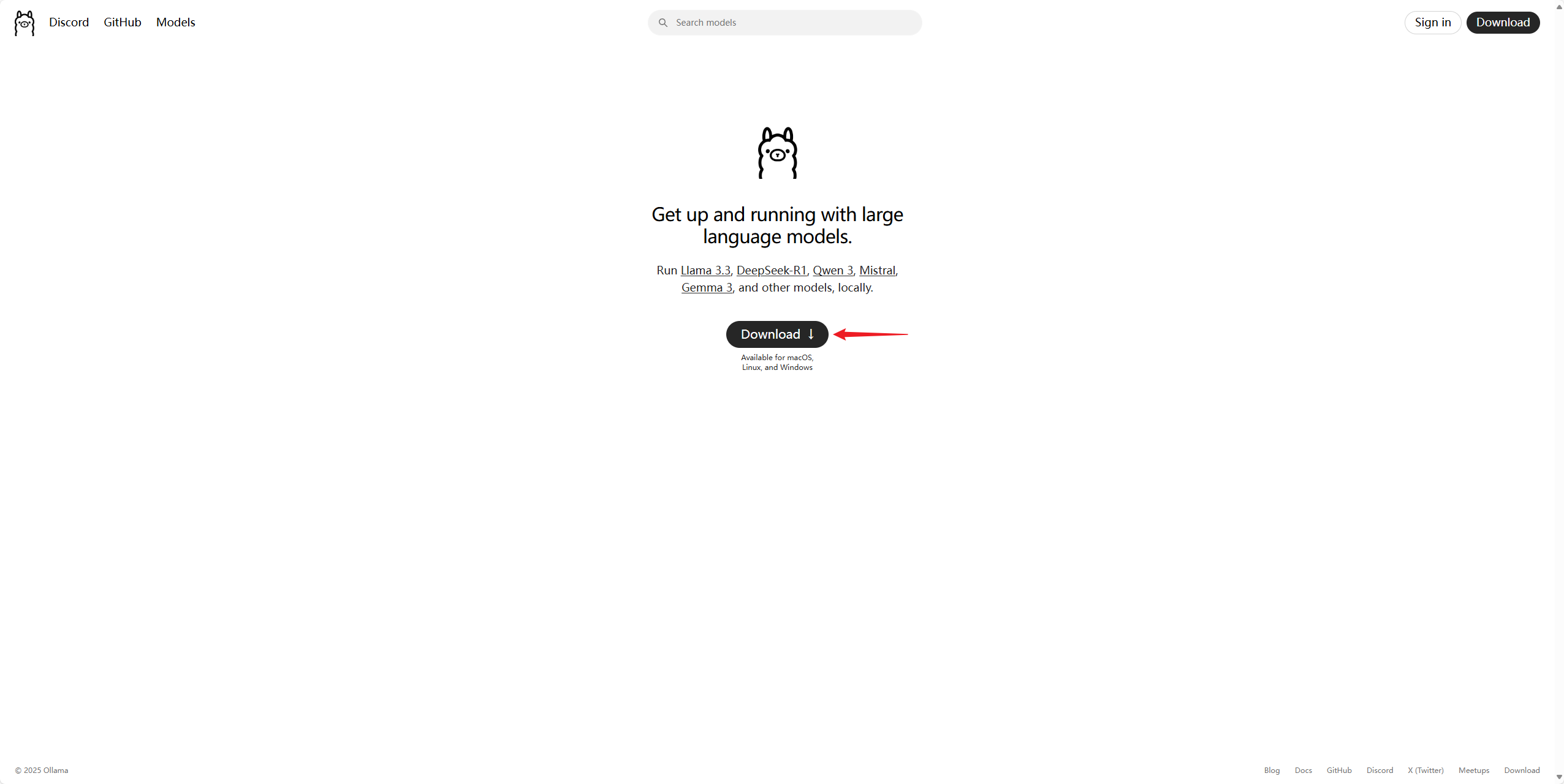

- 點擊“Download”進行下載:

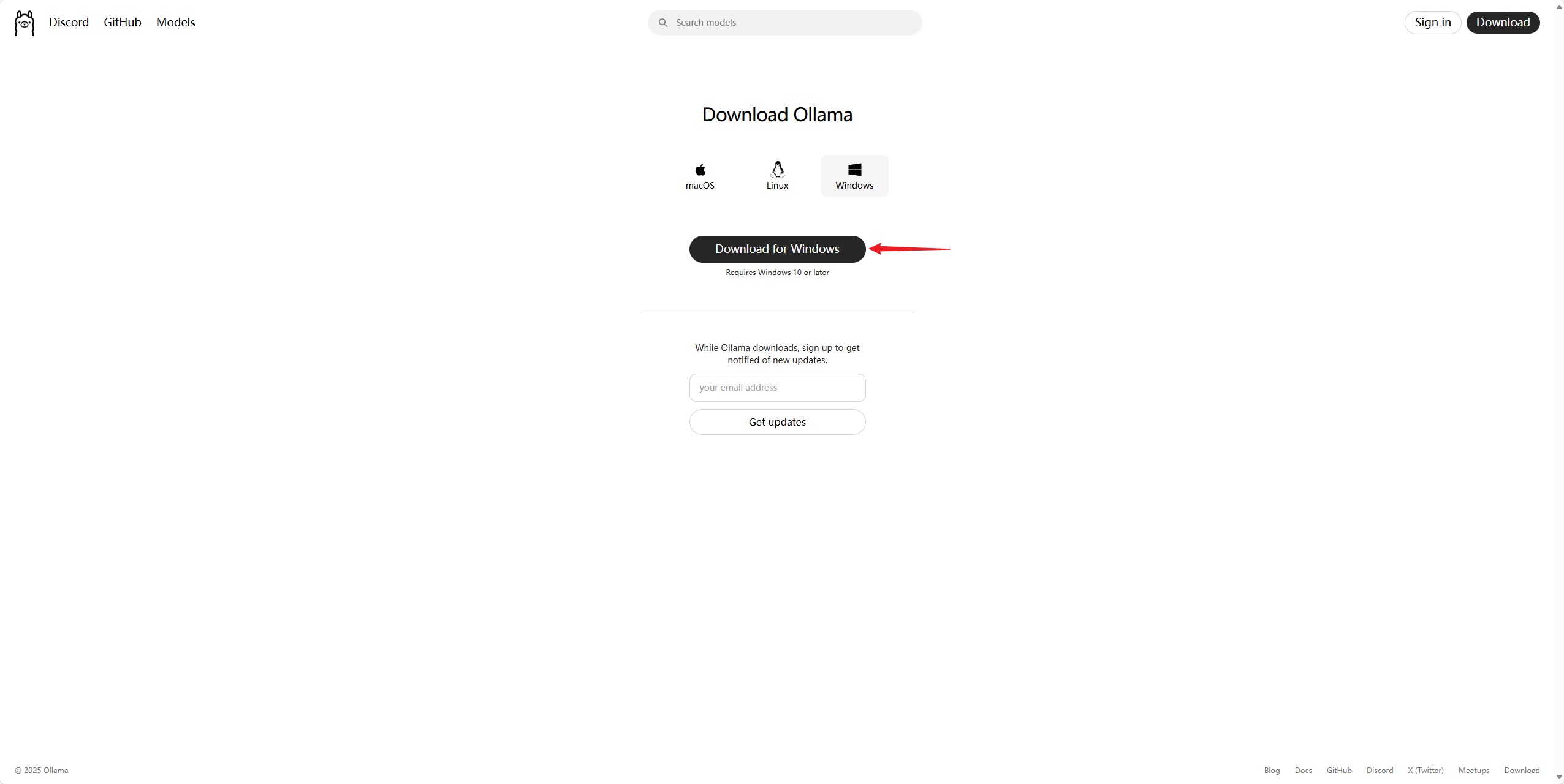

這里自動識別了電腦的操作系統,我的電腦是 Windows 系統,這里就以 Windows 為例演示了,其他系統步驟大同小異。

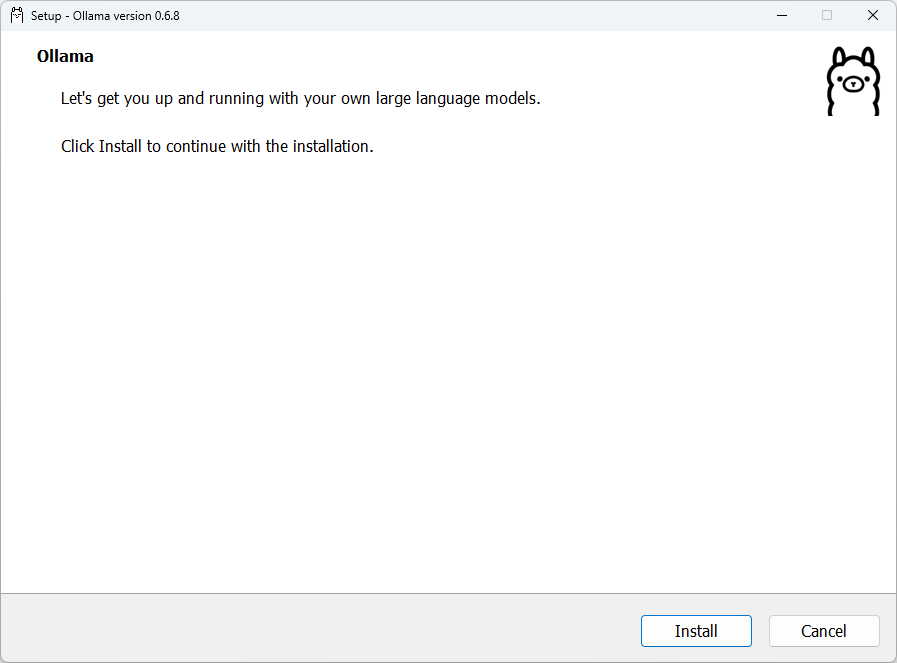

二、安裝 Ollama

Ollama 的安裝非常簡單。

- 打開安裝程序,點擊“Install”即開始安裝,沒有多余選項。

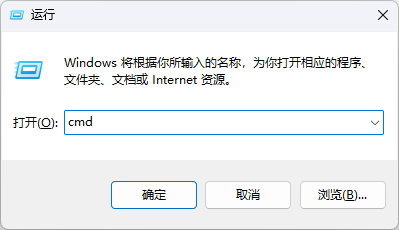

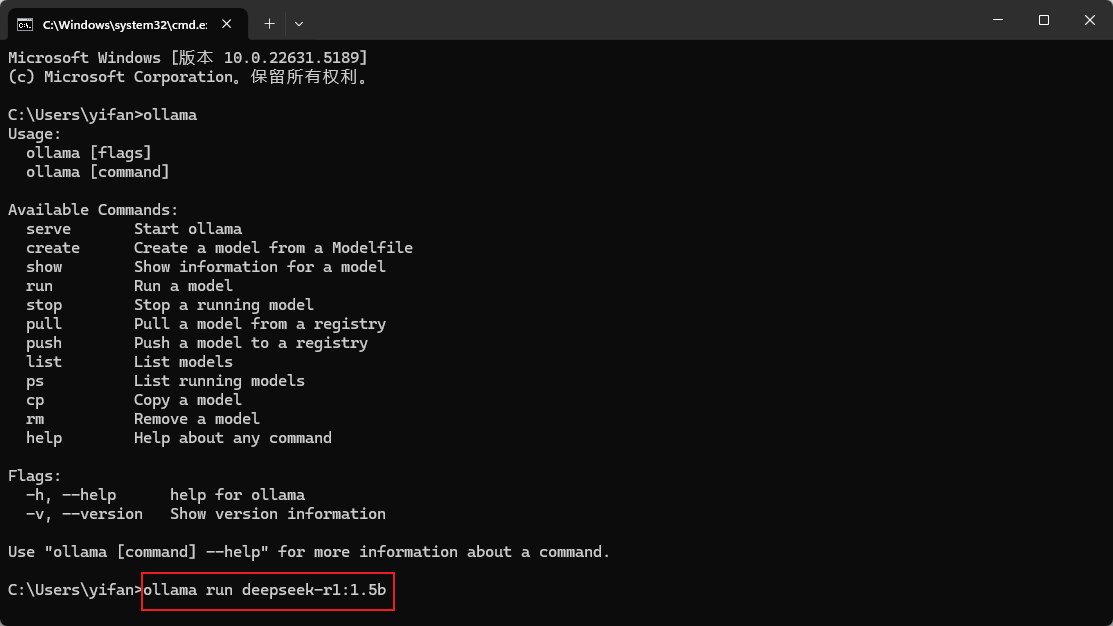

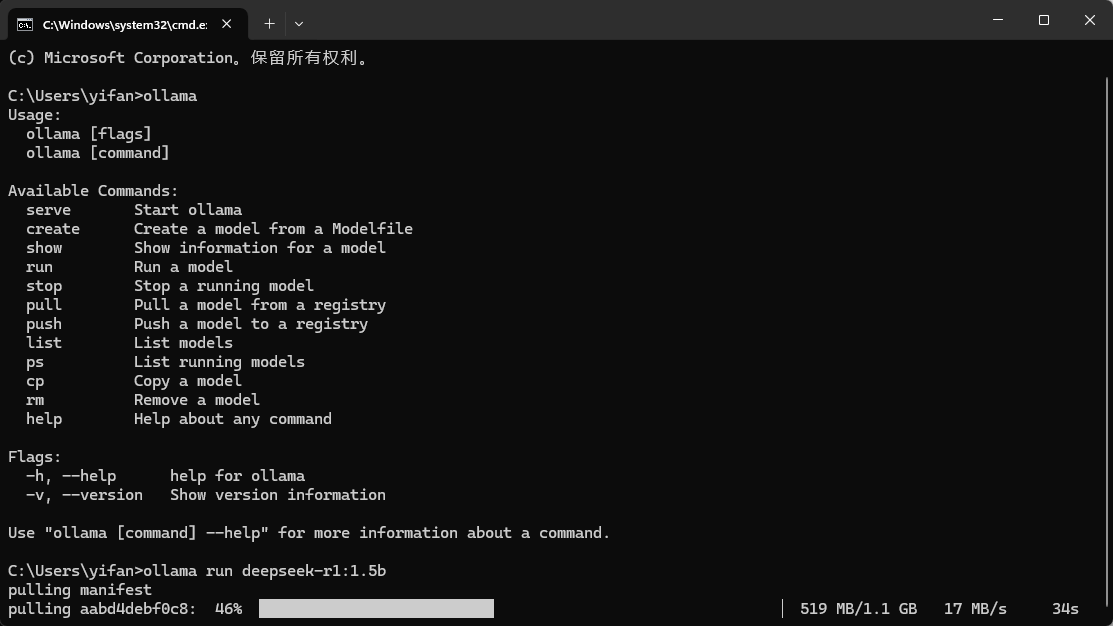

- 按鍵盤上的 Win + R 鍵,在彈窗中輸入

cmd

點擊“確定”,打開命令窗口:

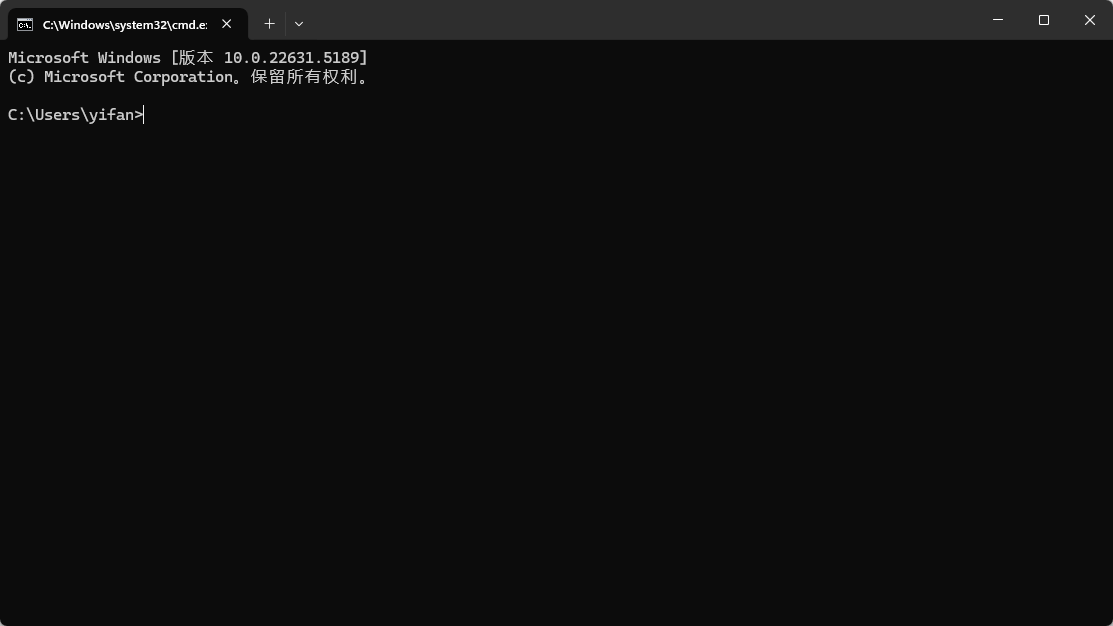

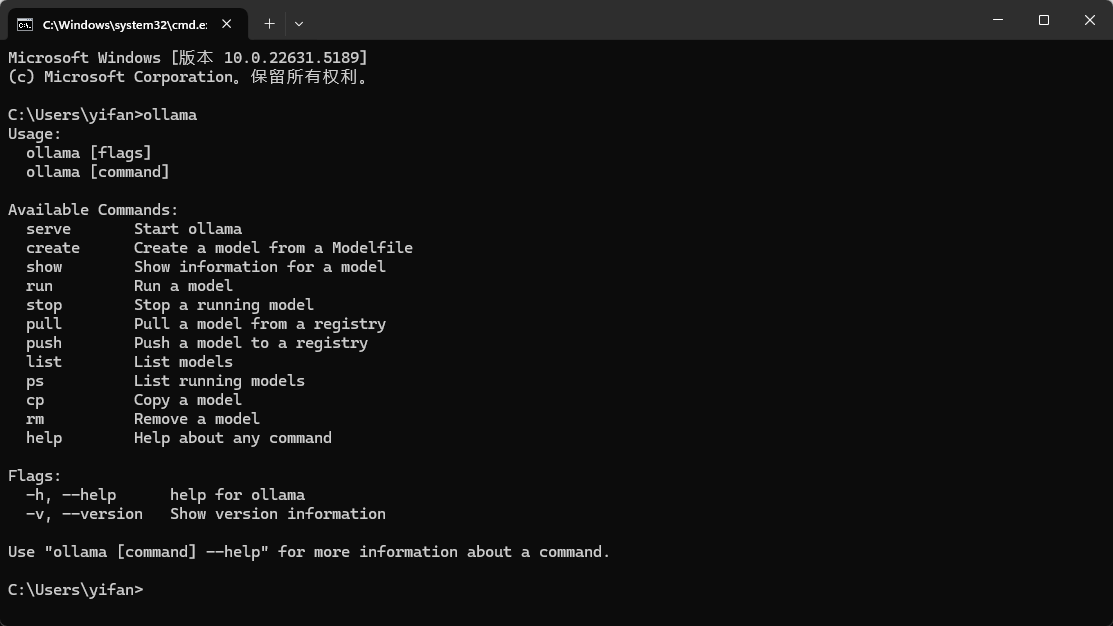

- 輸入

ollama,點擊回車,如果出現如下輸出,代表 Ollama 安裝成功。

三、下載 DeepSeek R1 模型

- 回到 Ollama 官網首頁,點擊 “DeepSeek R1”:

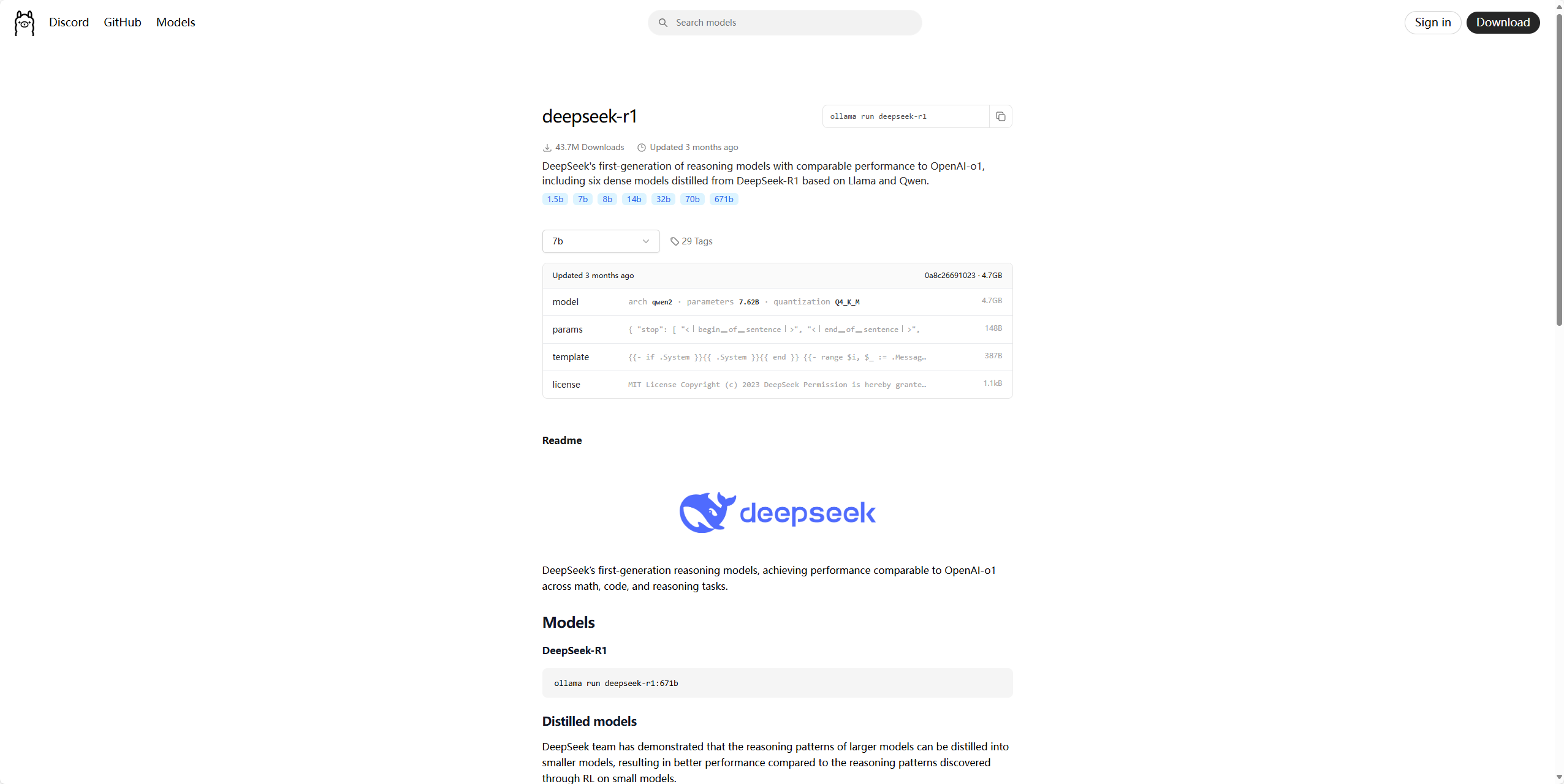

會進入到 DeepSeek R1 模型的下載主頁:

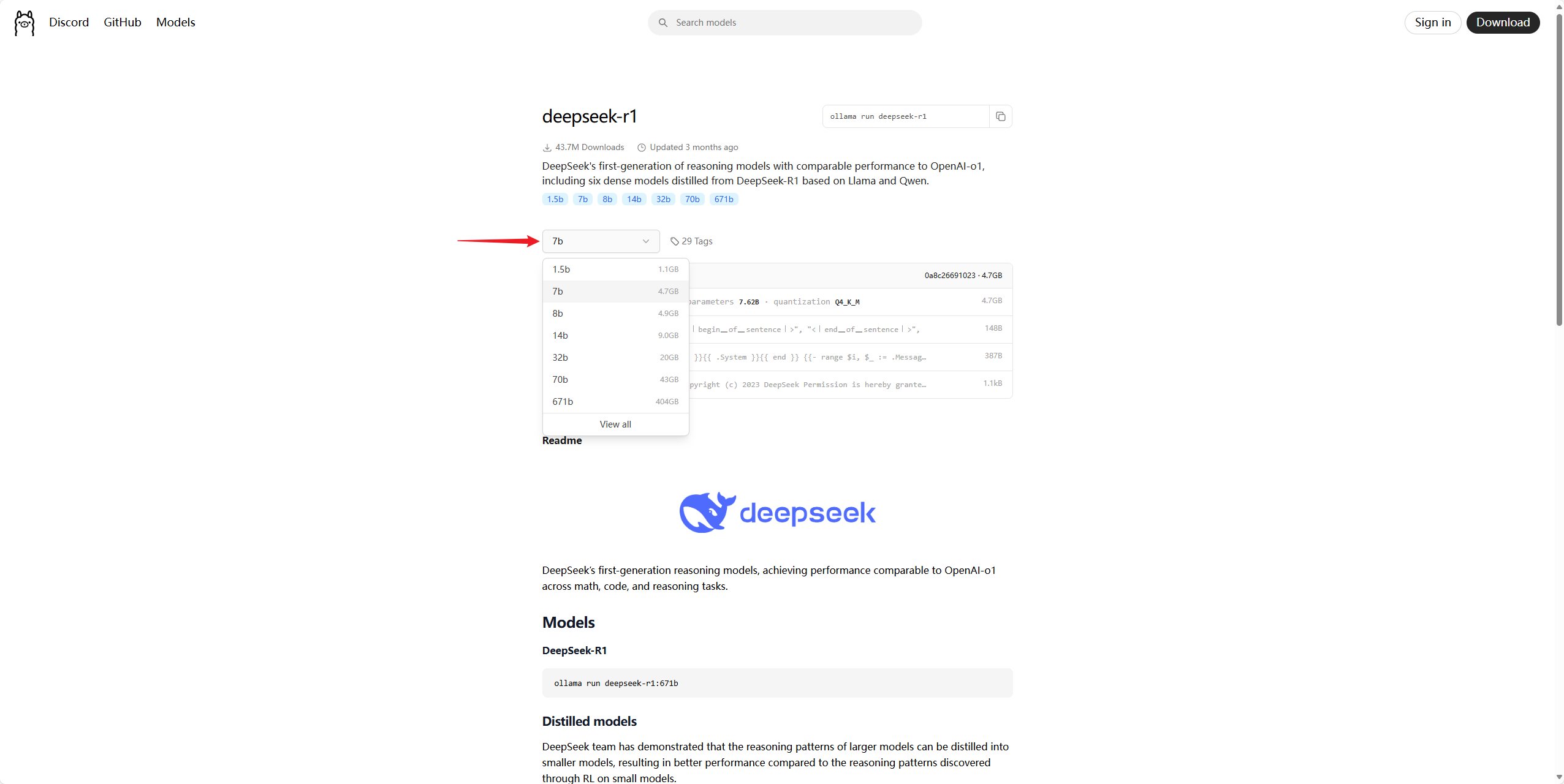

點擊這里可以看到 DeepSeek R1 不同量級模型對應的顯存要求列表:

數字后面的 b 是 billion 的縮寫,代表十億個參數,參數量越大代表得到的回答的質量也就越高,但相對的對配置的要求也越高。

- 如果電腦只有集顯,就選擇 1.5b 的模型。

- 如果是統一架構的 CPU,一部分內存可以當顯存用,根據可以當作顯存使用的內存大小選擇模型。

- 如果電腦有獨立顯卡,根據顯存大小選擇模型。

- 至于 671b,顯存要求高達 404GB!它是大家現在使用的公版 DeepSeek 的量級,個人電腦幾乎不可能達到,一般都是大公司部署使用。

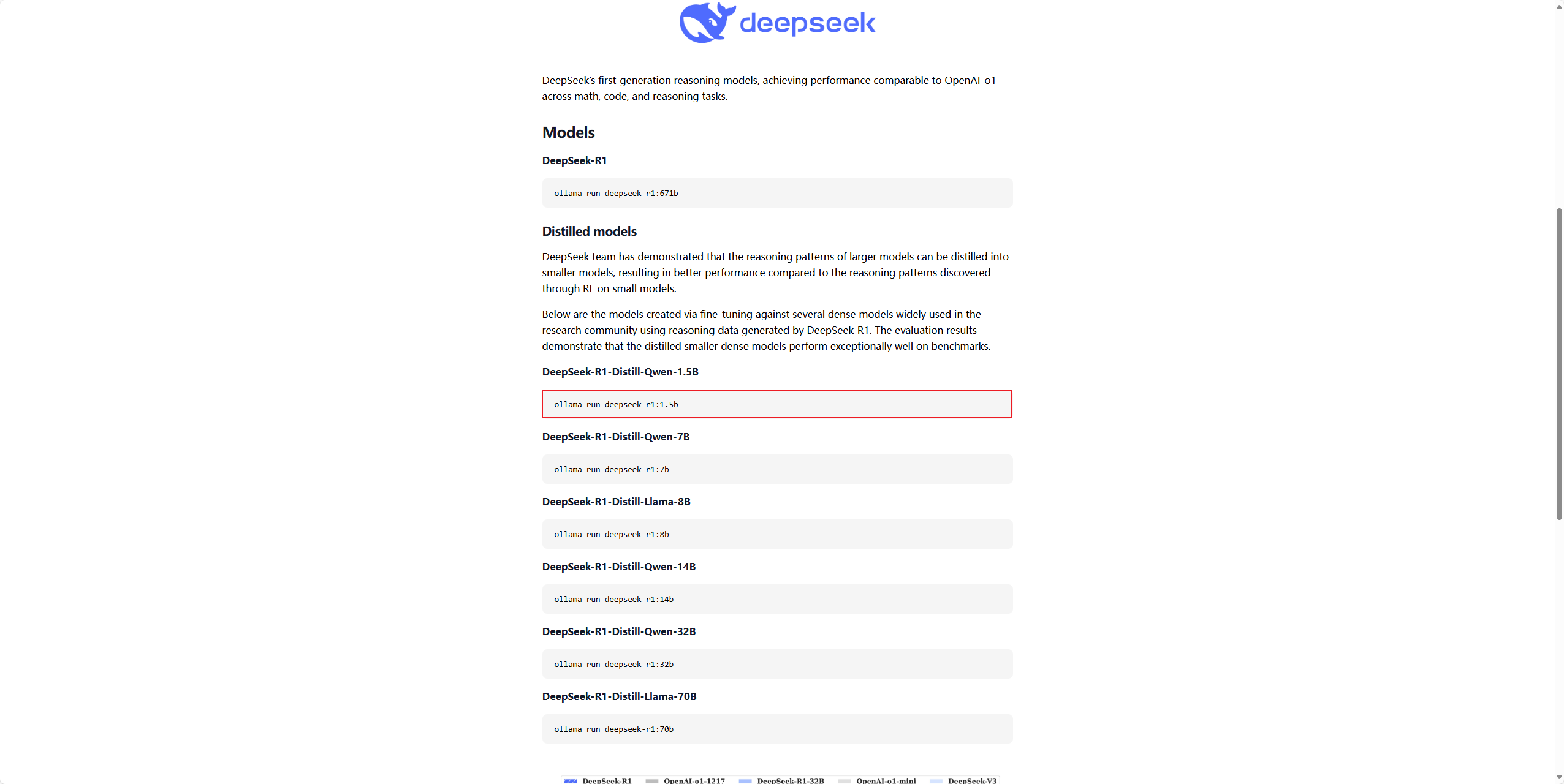

這里我們以配置要求最低的 1.5b 模型進行演示。

- 下滑找到 1.5b 模型對應的安裝命令,“復制”命令:

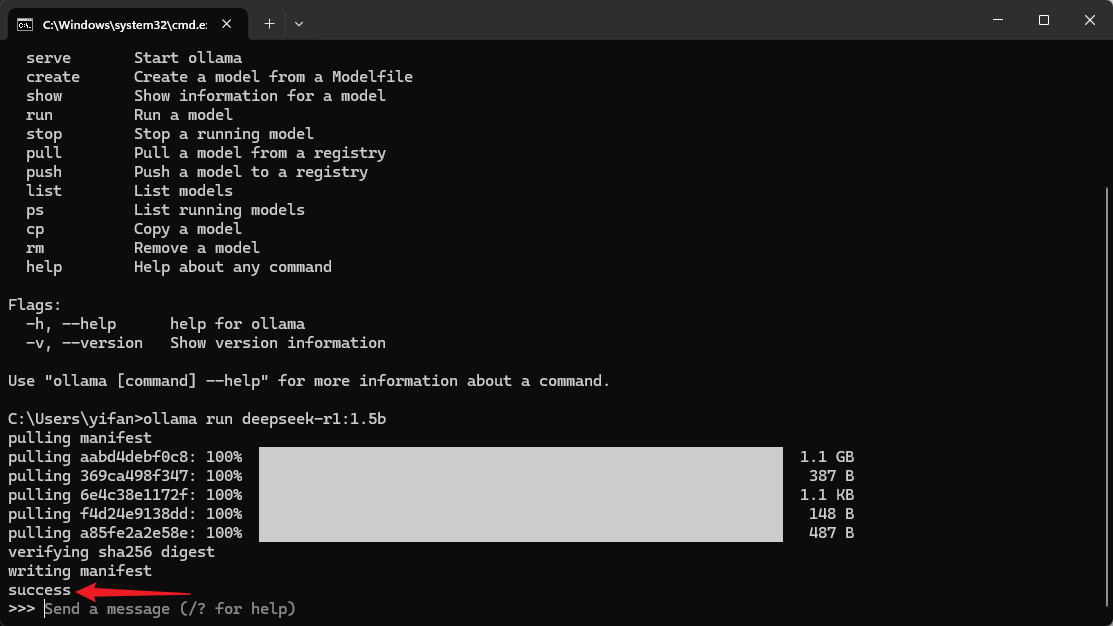

- 回到剛才打開的命令窗口,“粘貼”命令:

點擊“回車”運行:

當看到輸出“success”,即代表安裝成功。

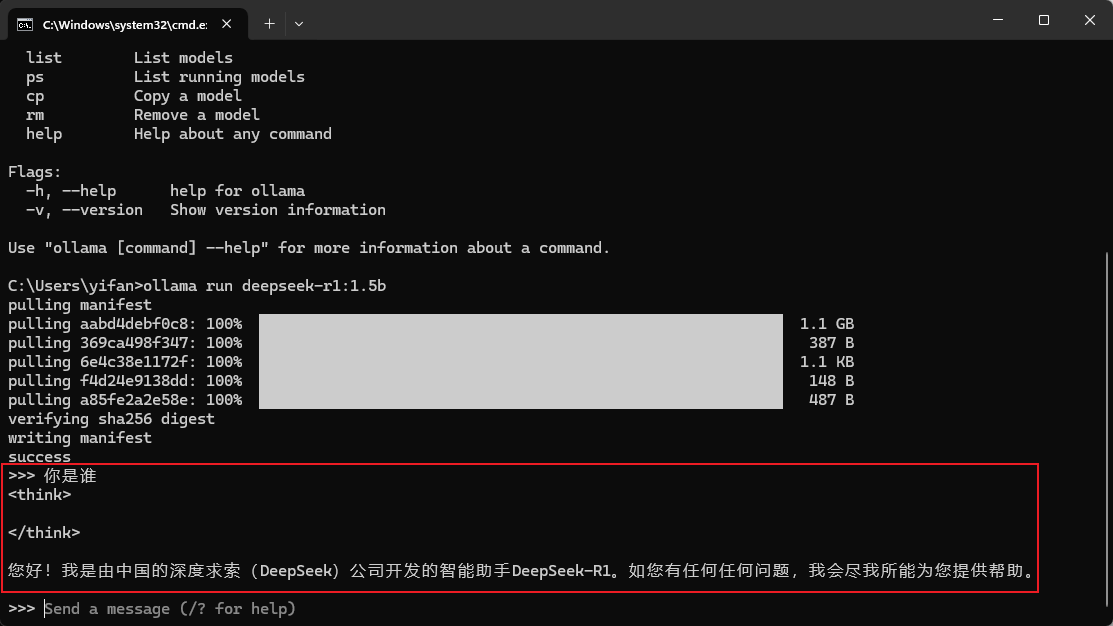

這里其實已經可以使用 DeepSeek 了,比如:

但這樣的命令行方式顯然很不方便,所以還需要使用第三方工具,實現類似于官網那樣的使用體驗。

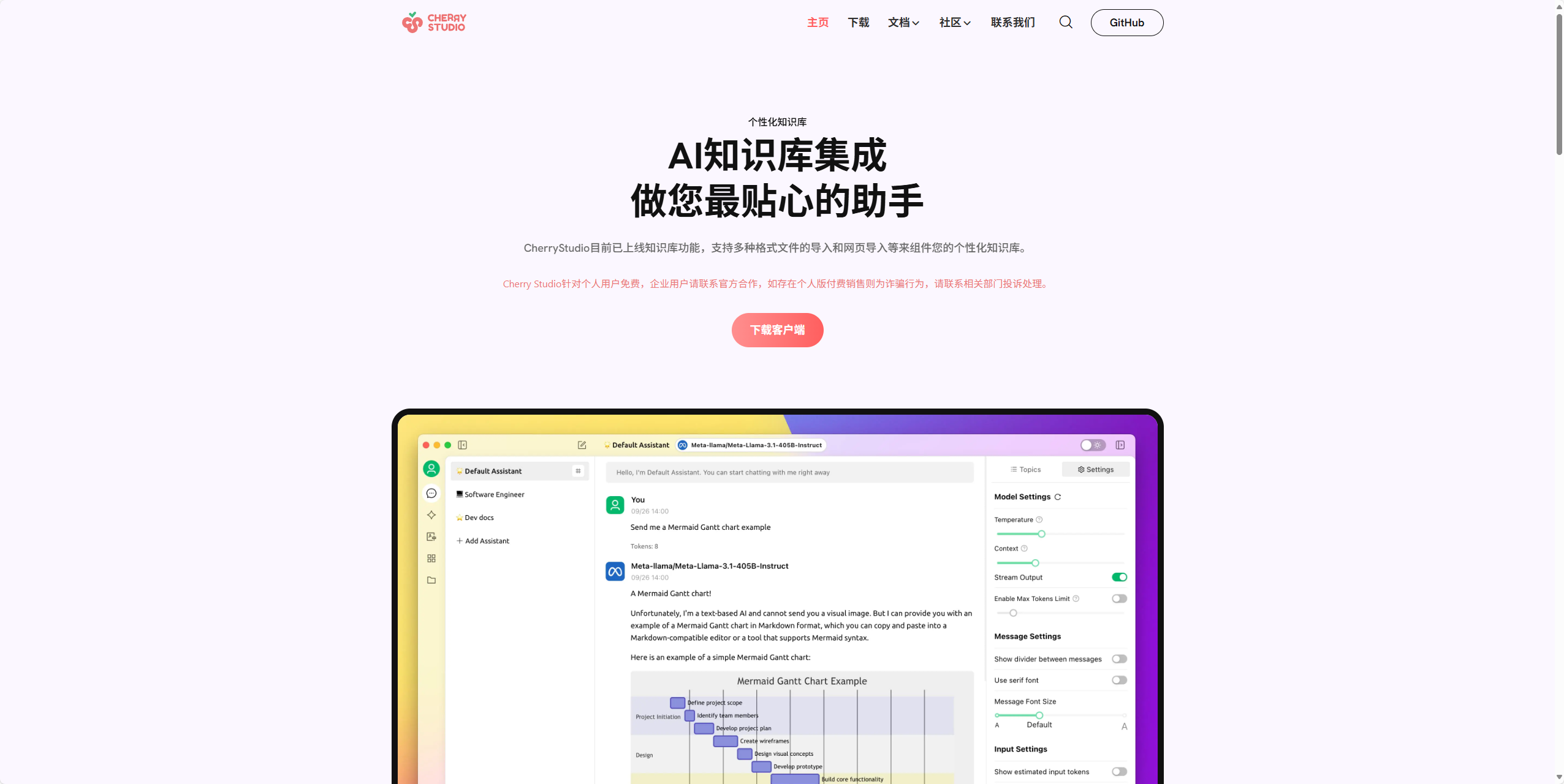

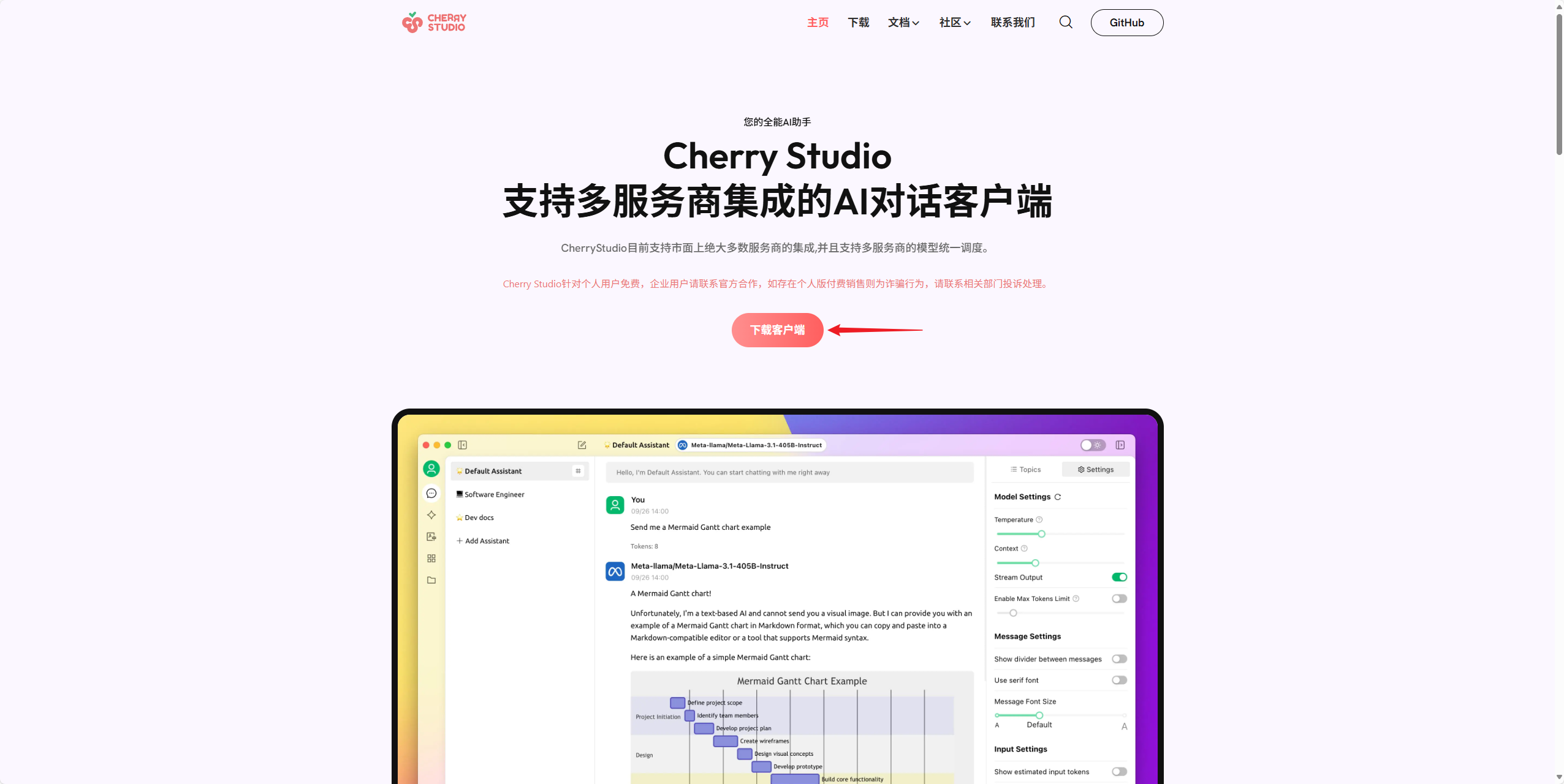

四、下載 Cherry Studio

- 訪問 Cherry Studio 官網:www.cherry-ai.com

- 點擊“下載客戶端”進行下載:

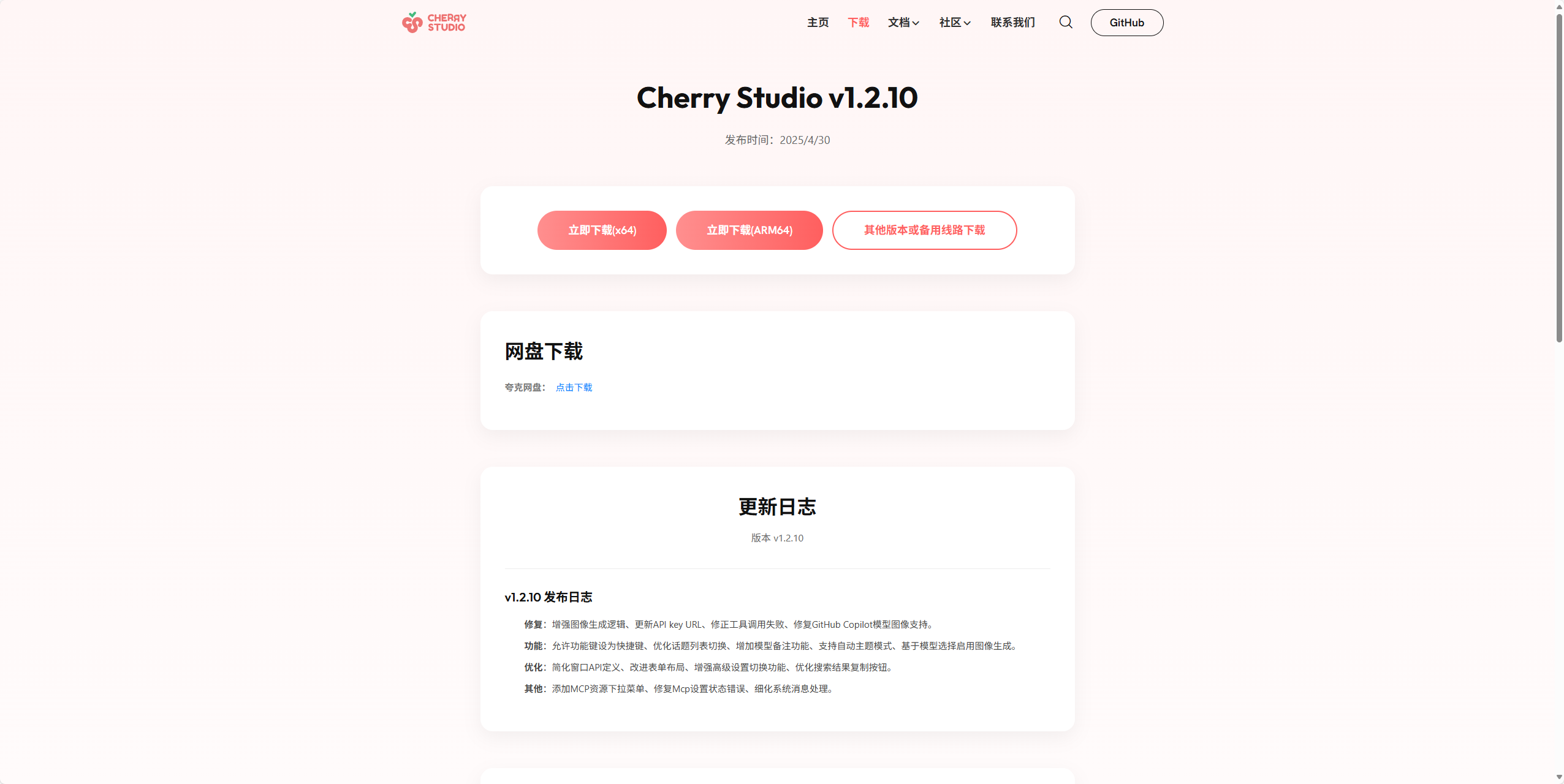

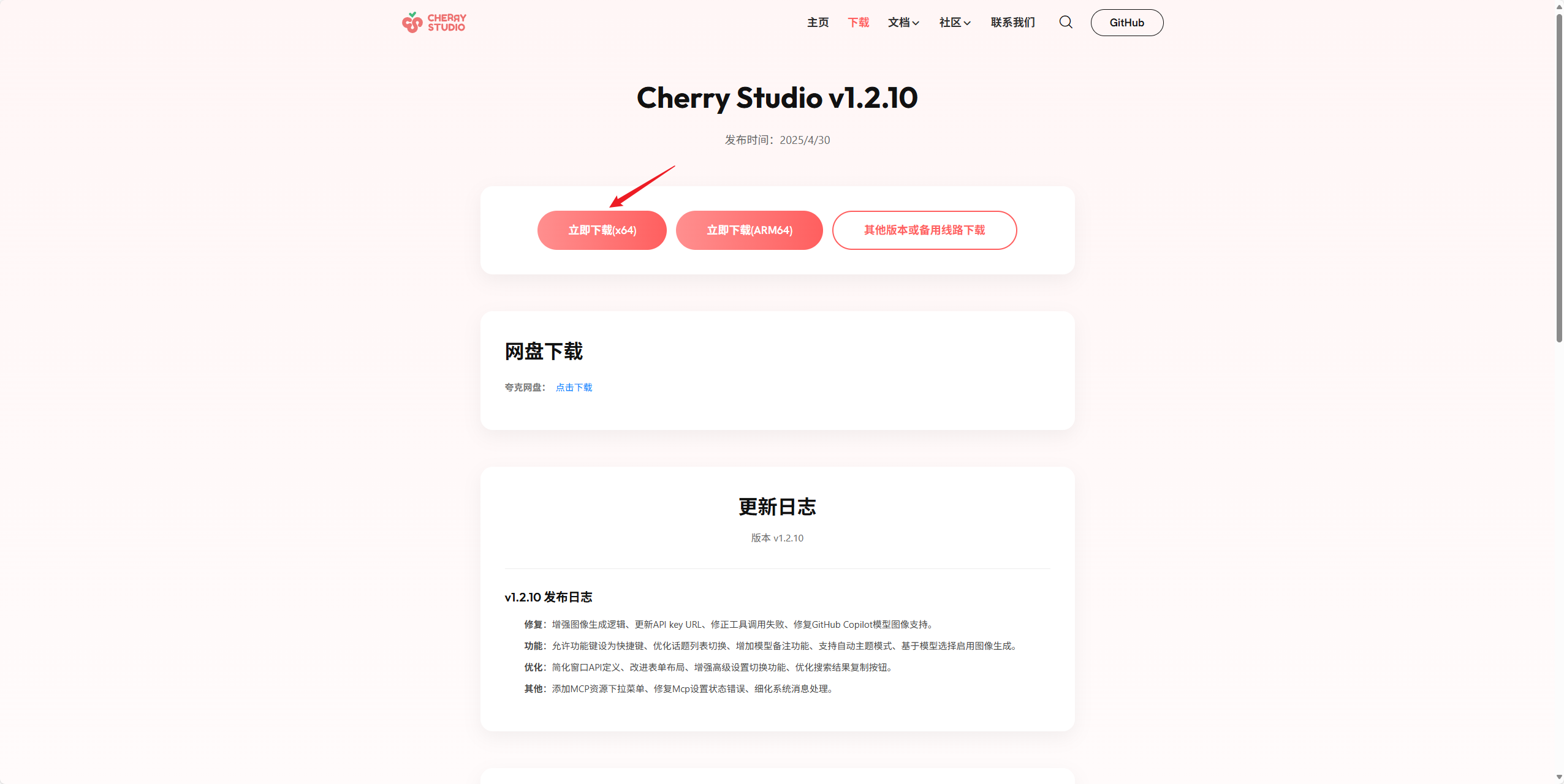

這里根據自己的系統架構進行選擇:

- 如果是 x86 64 位架構,就選擇 “x64”選項。

- 如果是 ARM 64 位架構,就選擇“ARM64”選項。

這里很好判斷,個人電腦目前除了蘋果的 M 系列芯片電腦以及本月 19 號發布的華為鴻蒙電腦,都是 x86 64 位架構的。

我的電腦是 x86 64 位的:

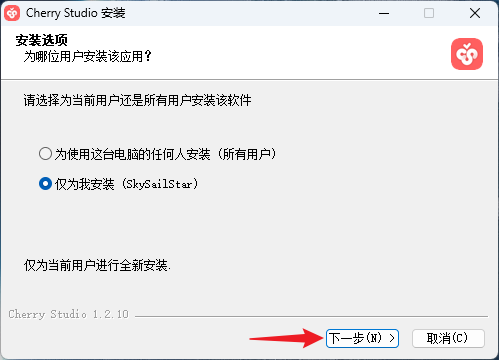

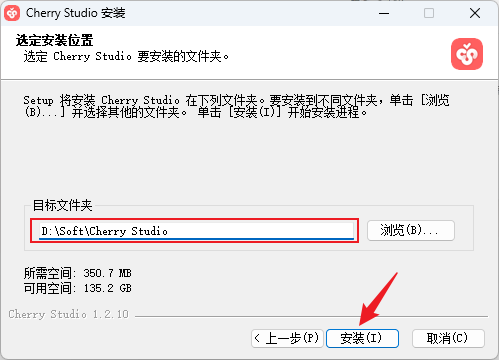

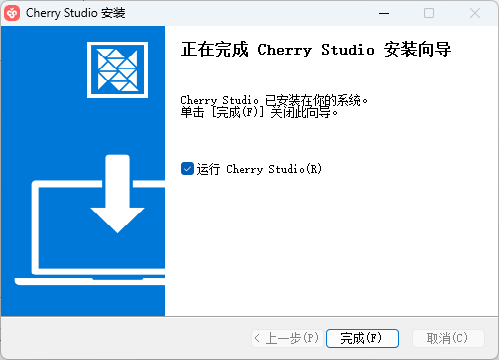

五、安裝 Cherry Studio

- 打開安裝程序:

指定想要安裝的目錄,進行安裝:

出現如下界面代表安裝完成:

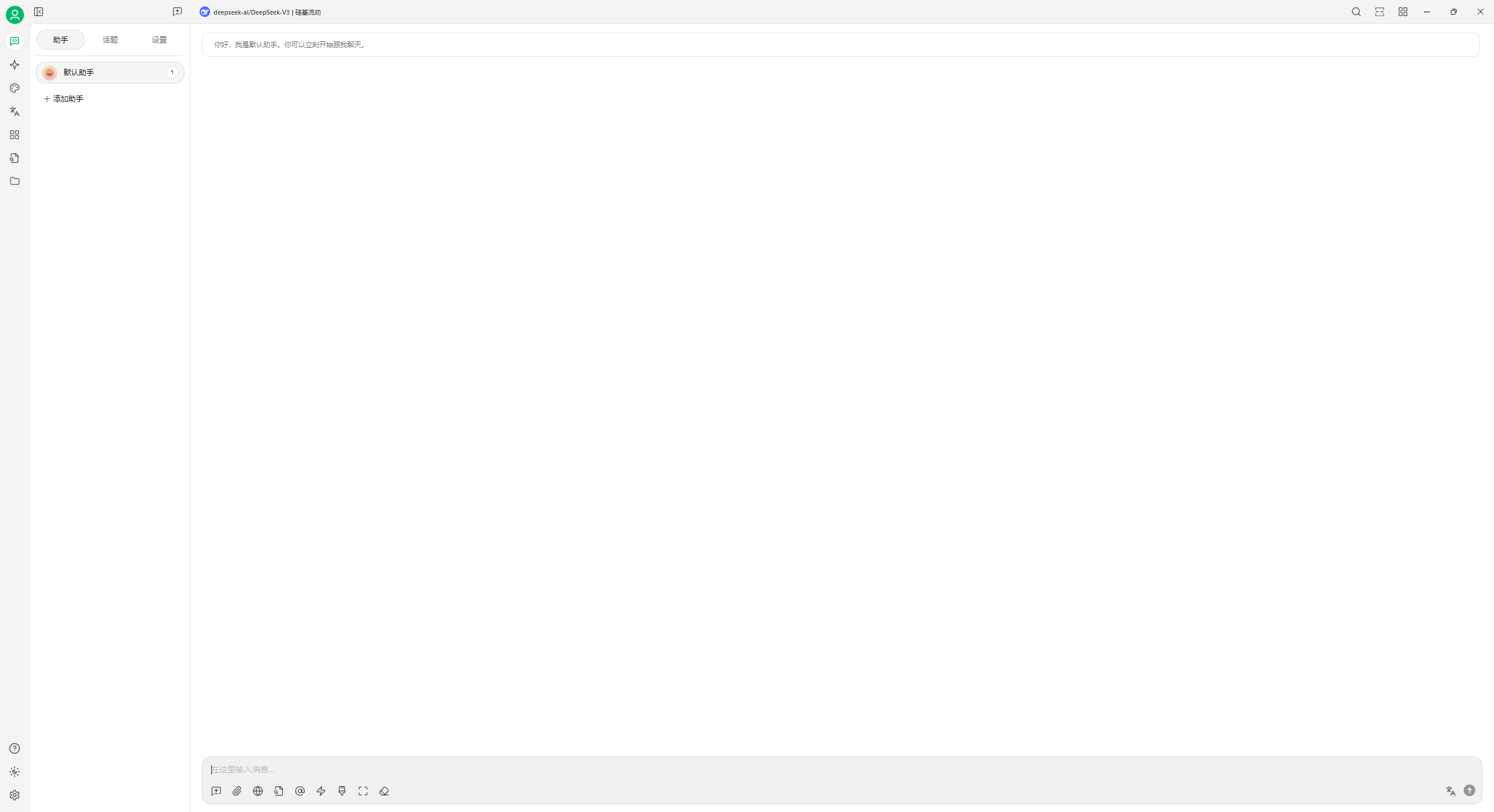

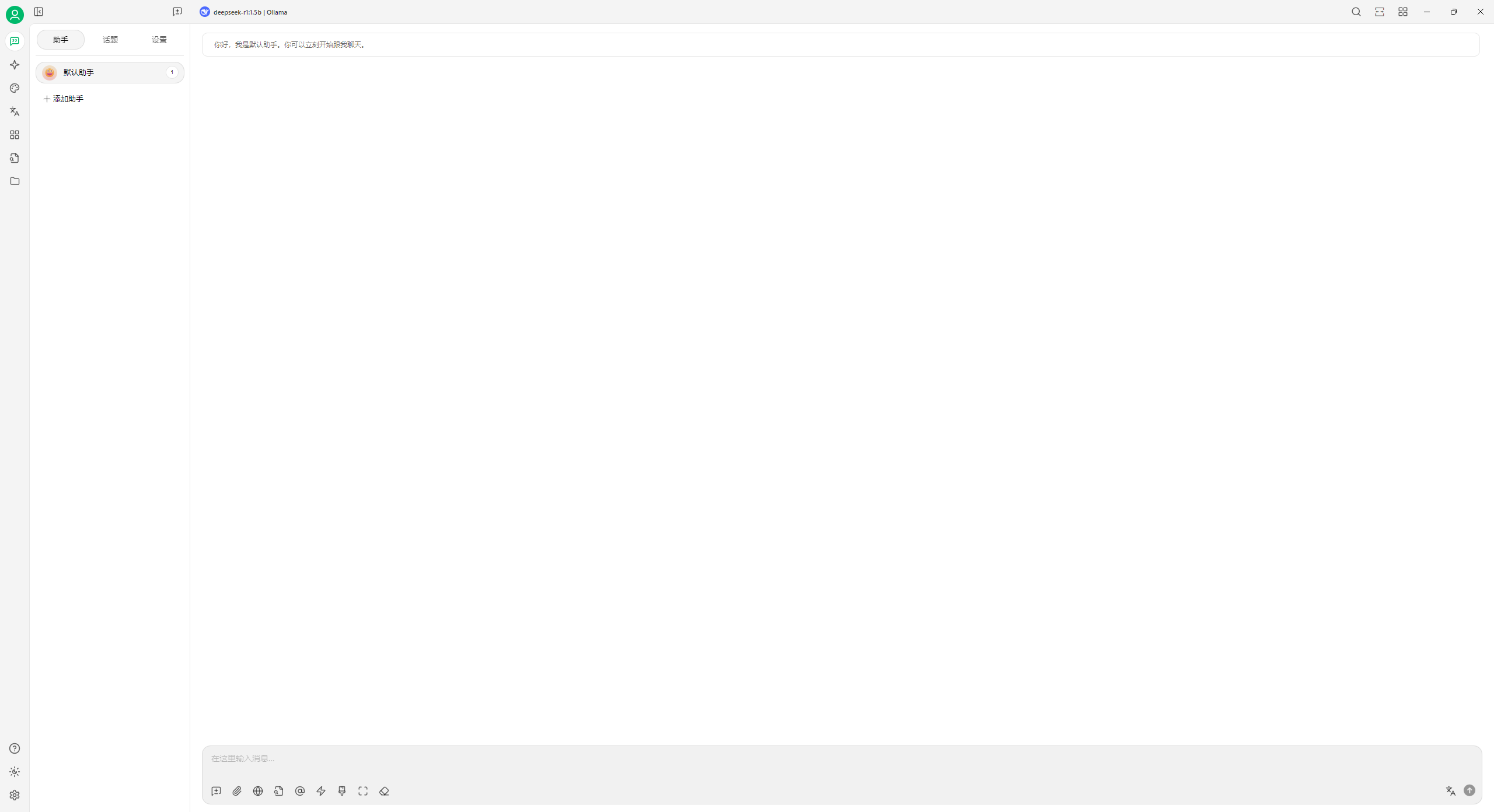

六、使用 Cherry Studio

- 打開安裝好的 Cherry Studio:

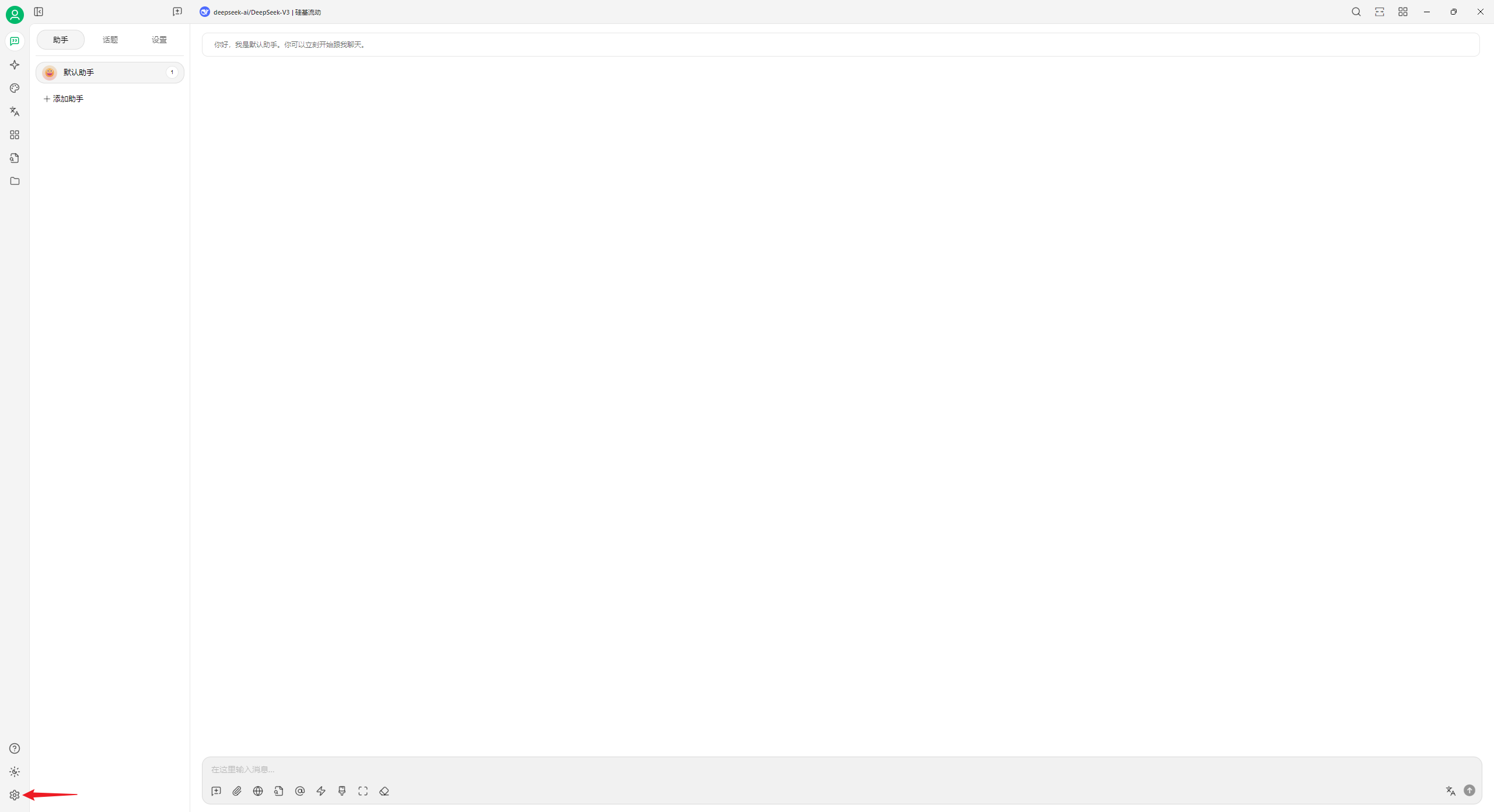

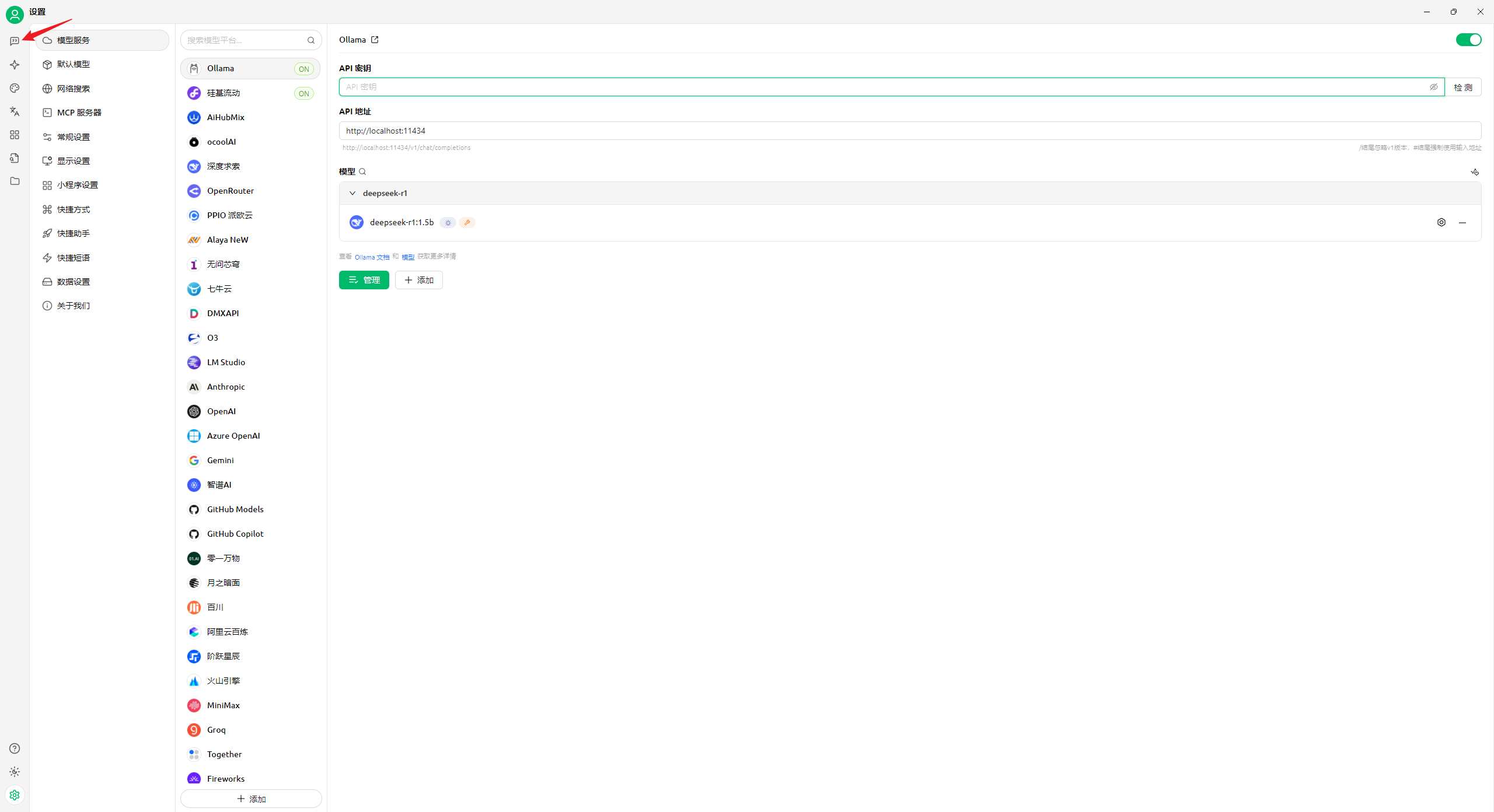

- 點擊左下角的“設置”按鈕:

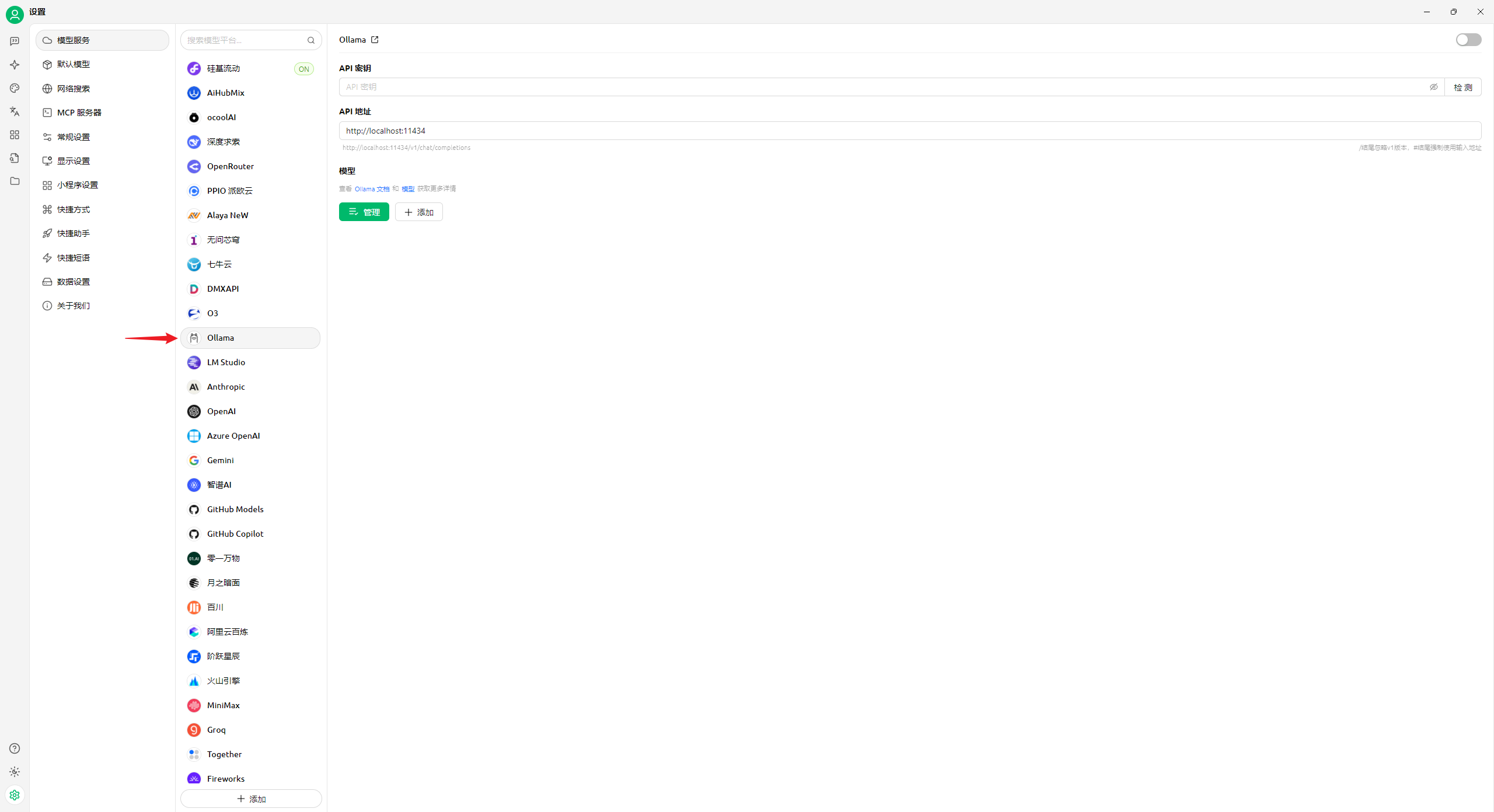

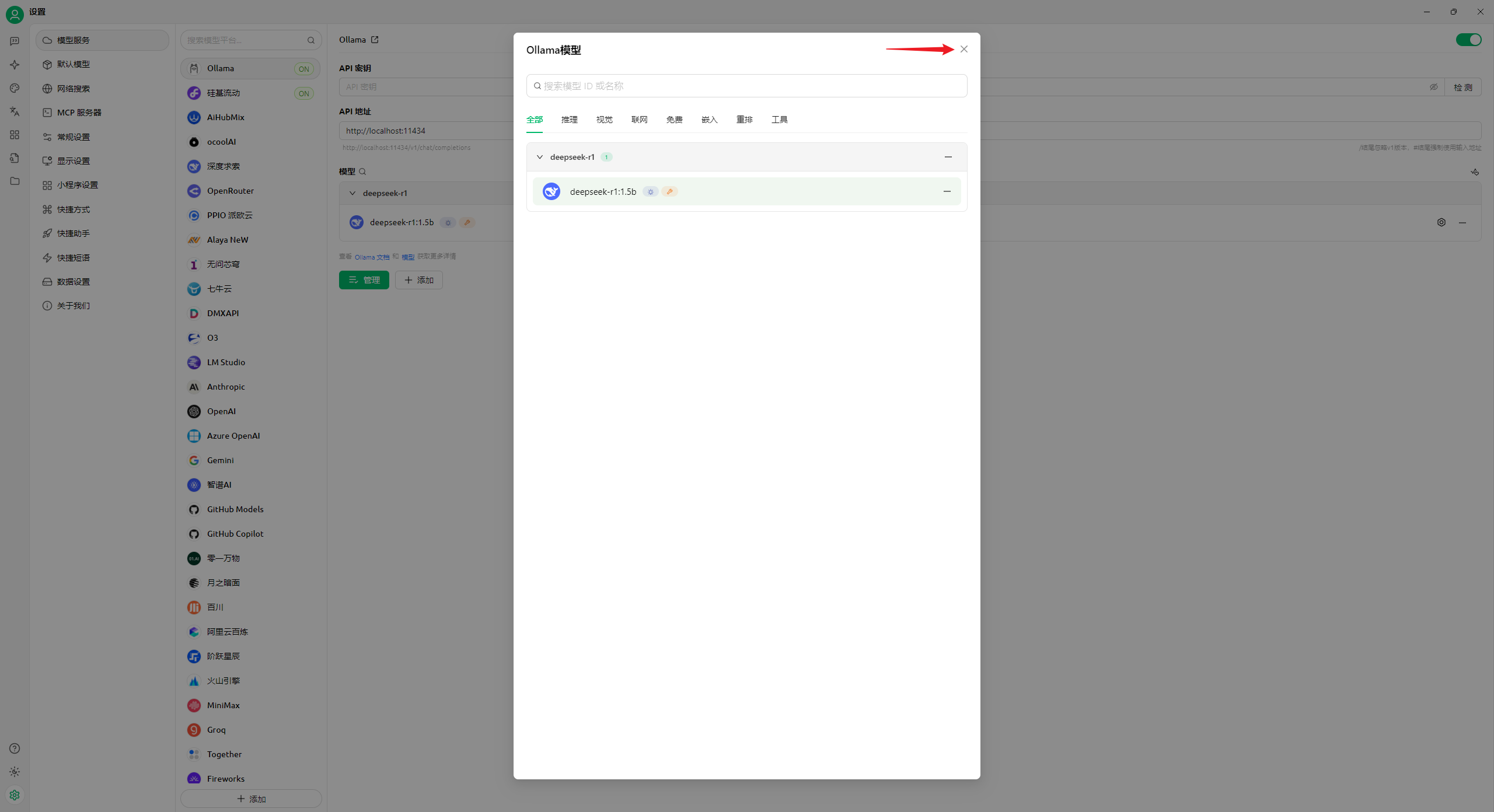

- 在模型服務中選擇“Ollama:

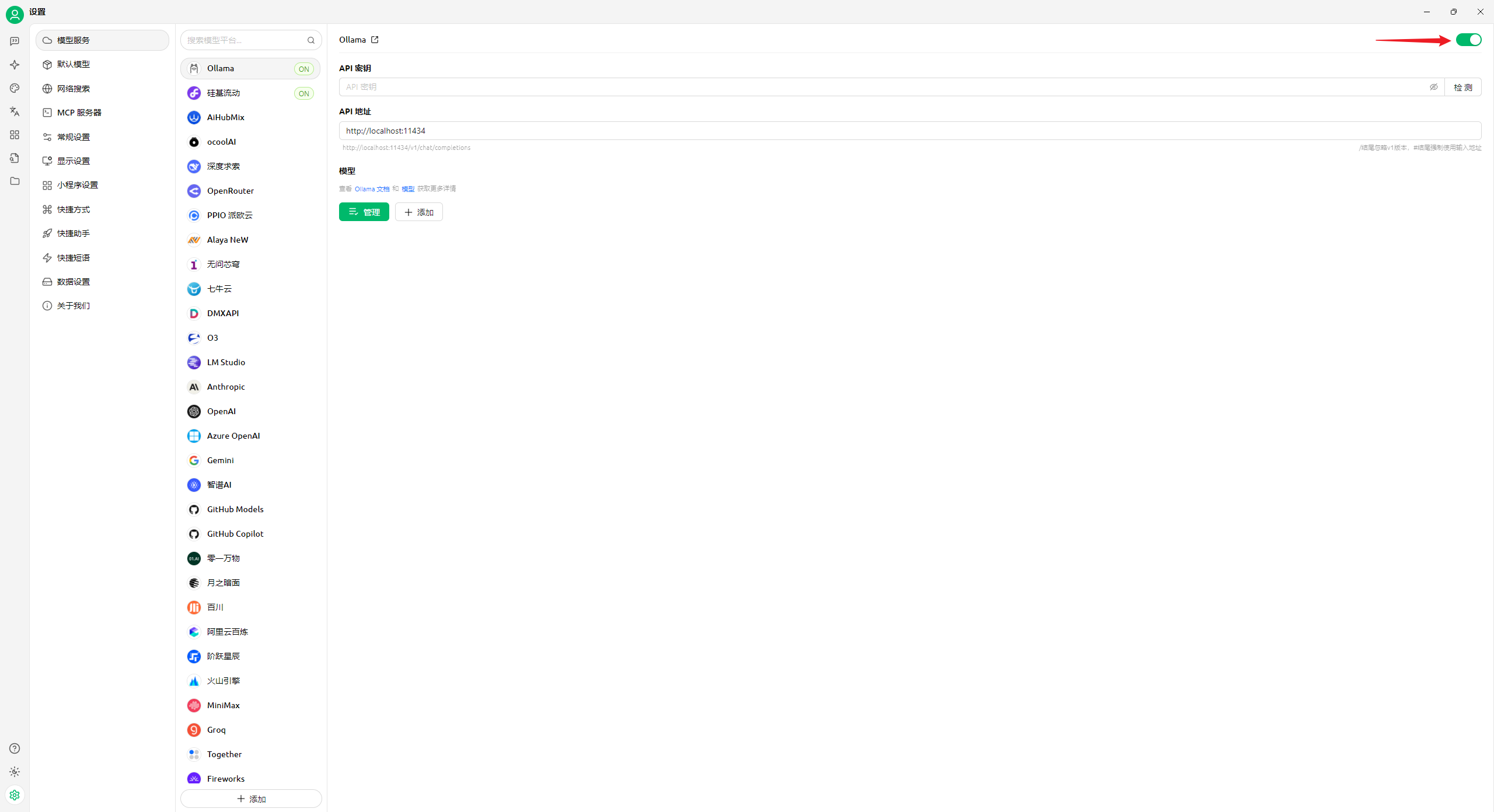

- 打開頂部的開關:

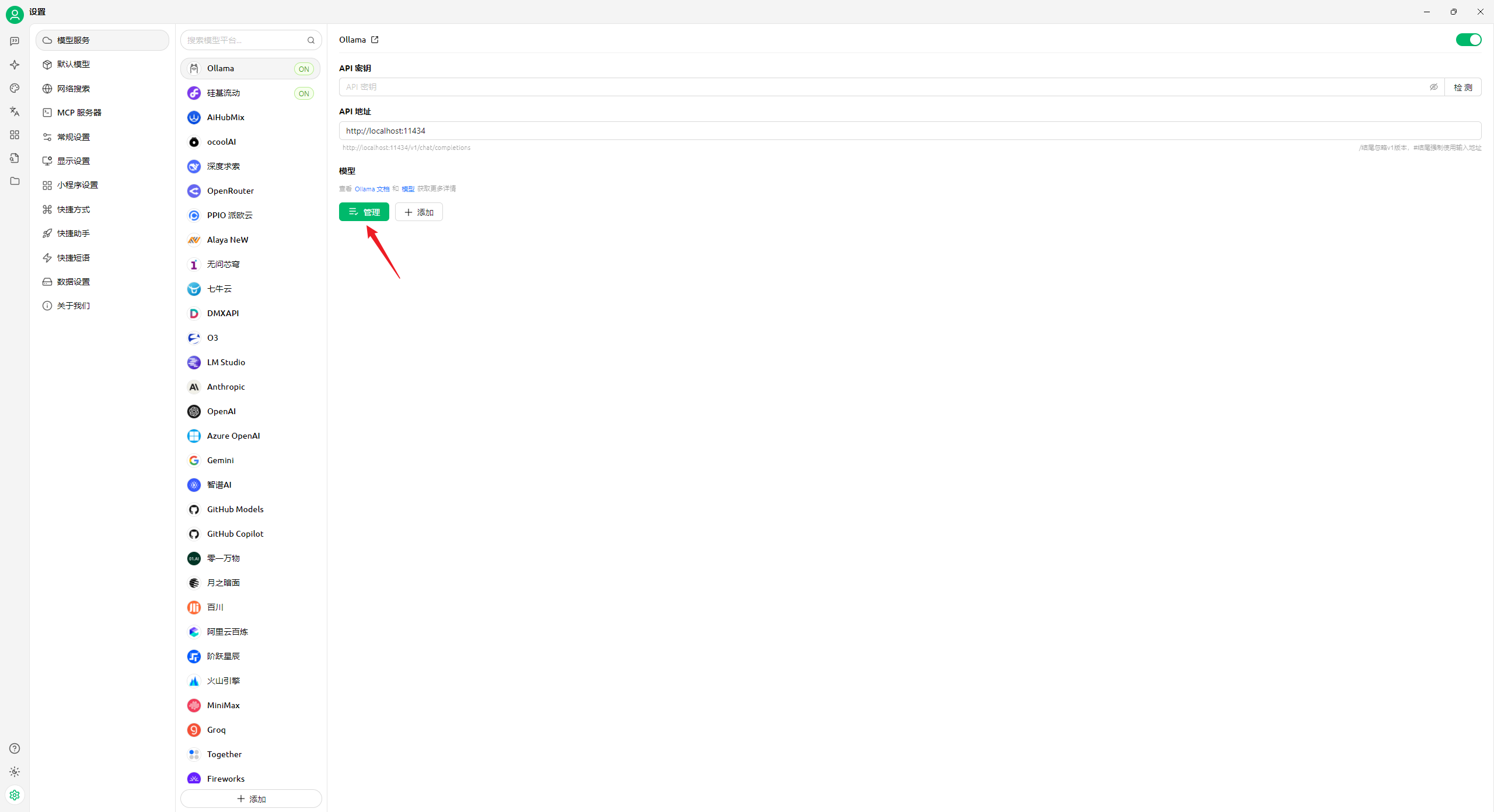

- 點擊“管理”按鈕:

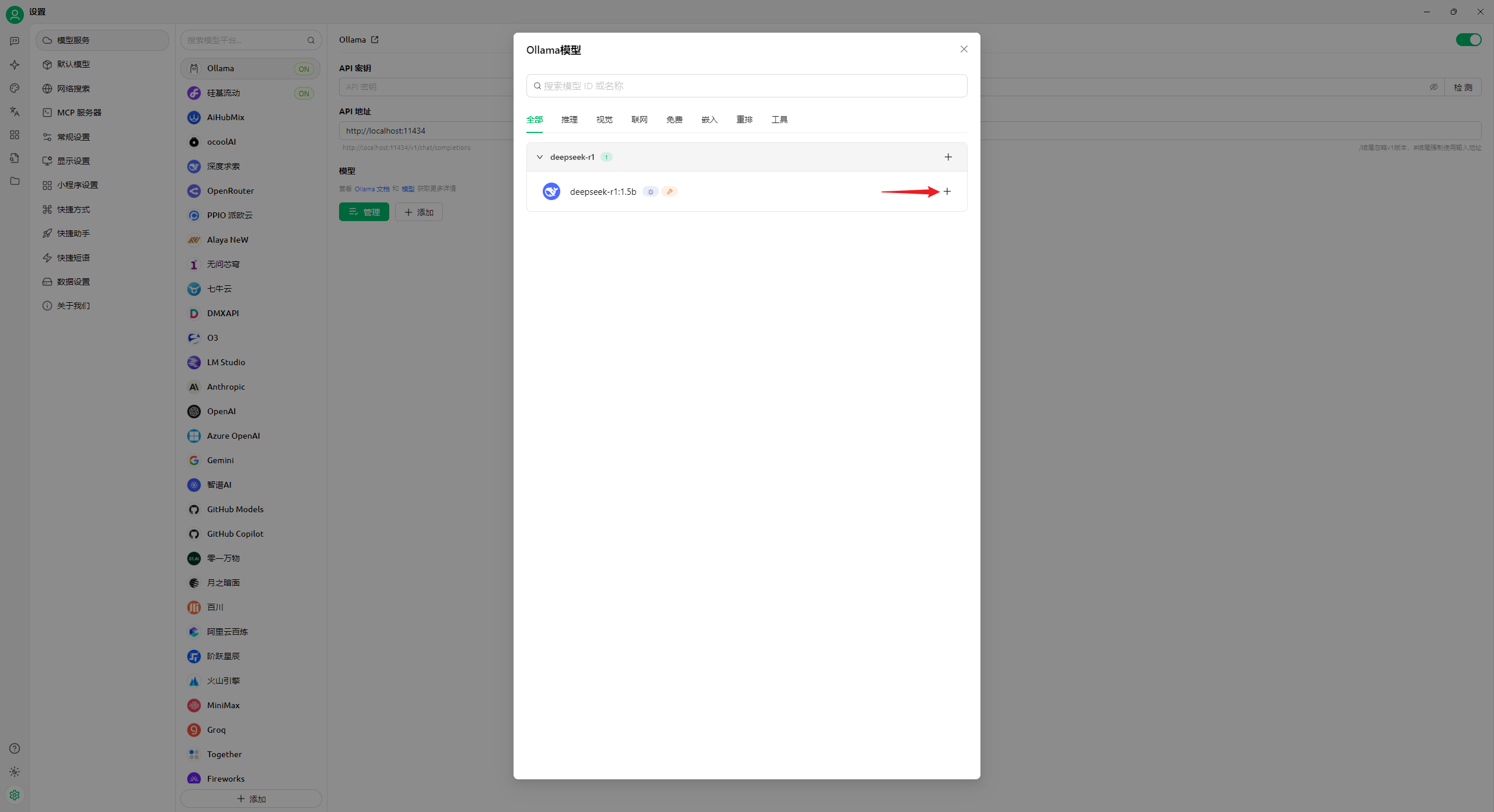

- 添加剛才下載的 DeepSeek 模型:

關閉對話框:

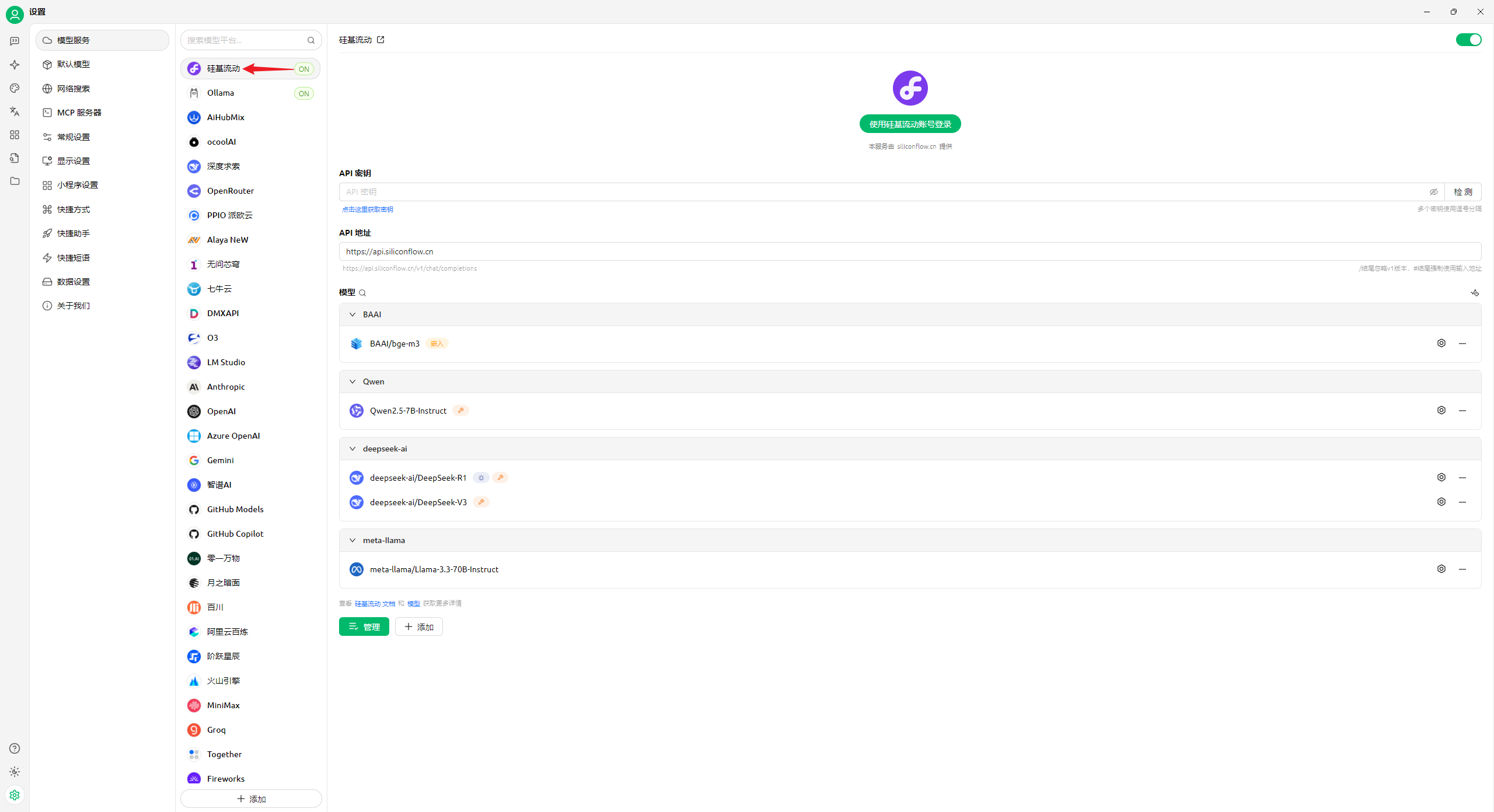

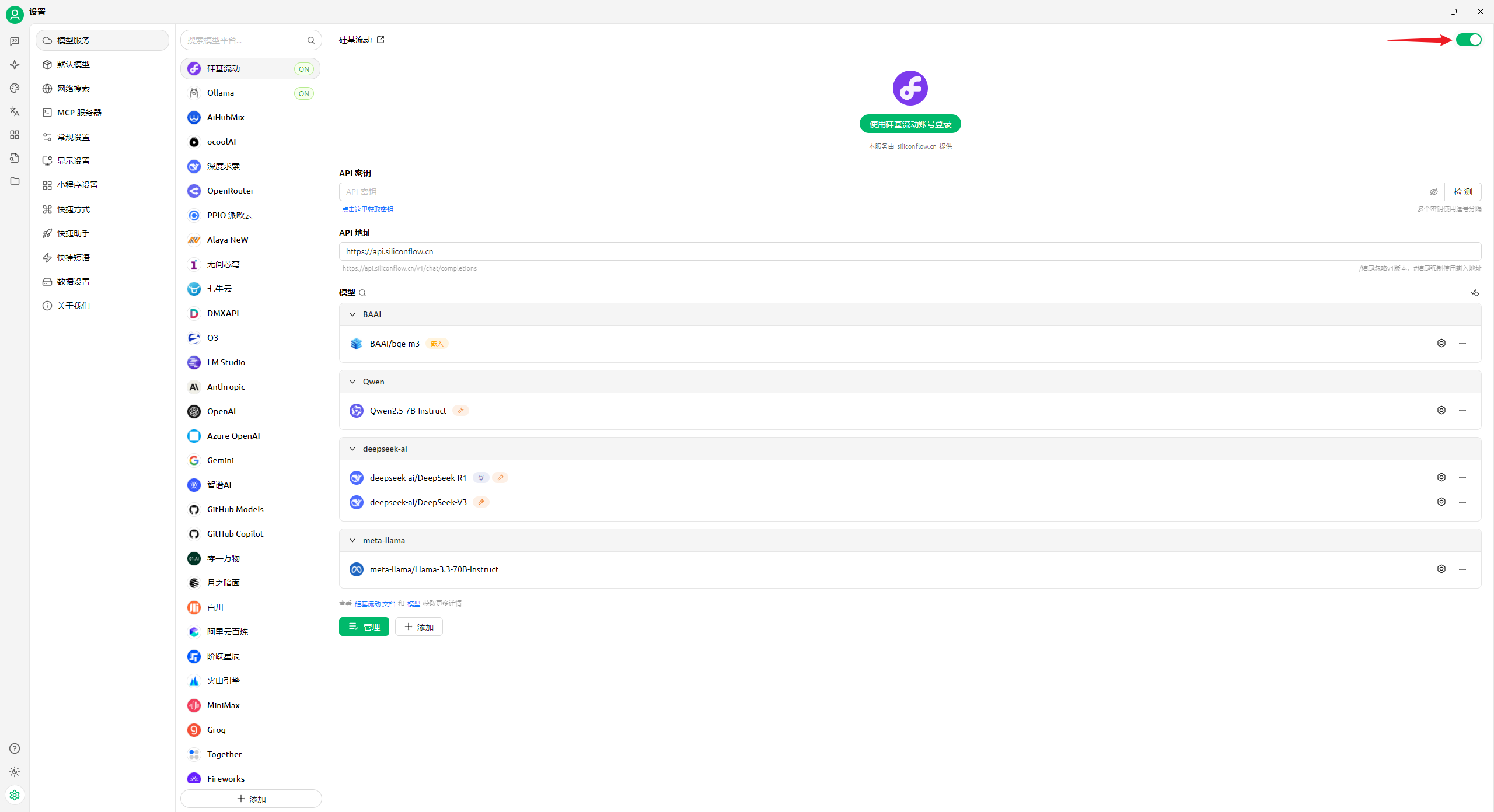

- 關閉其他模型的開關:

- 回到主頁的對話界面:

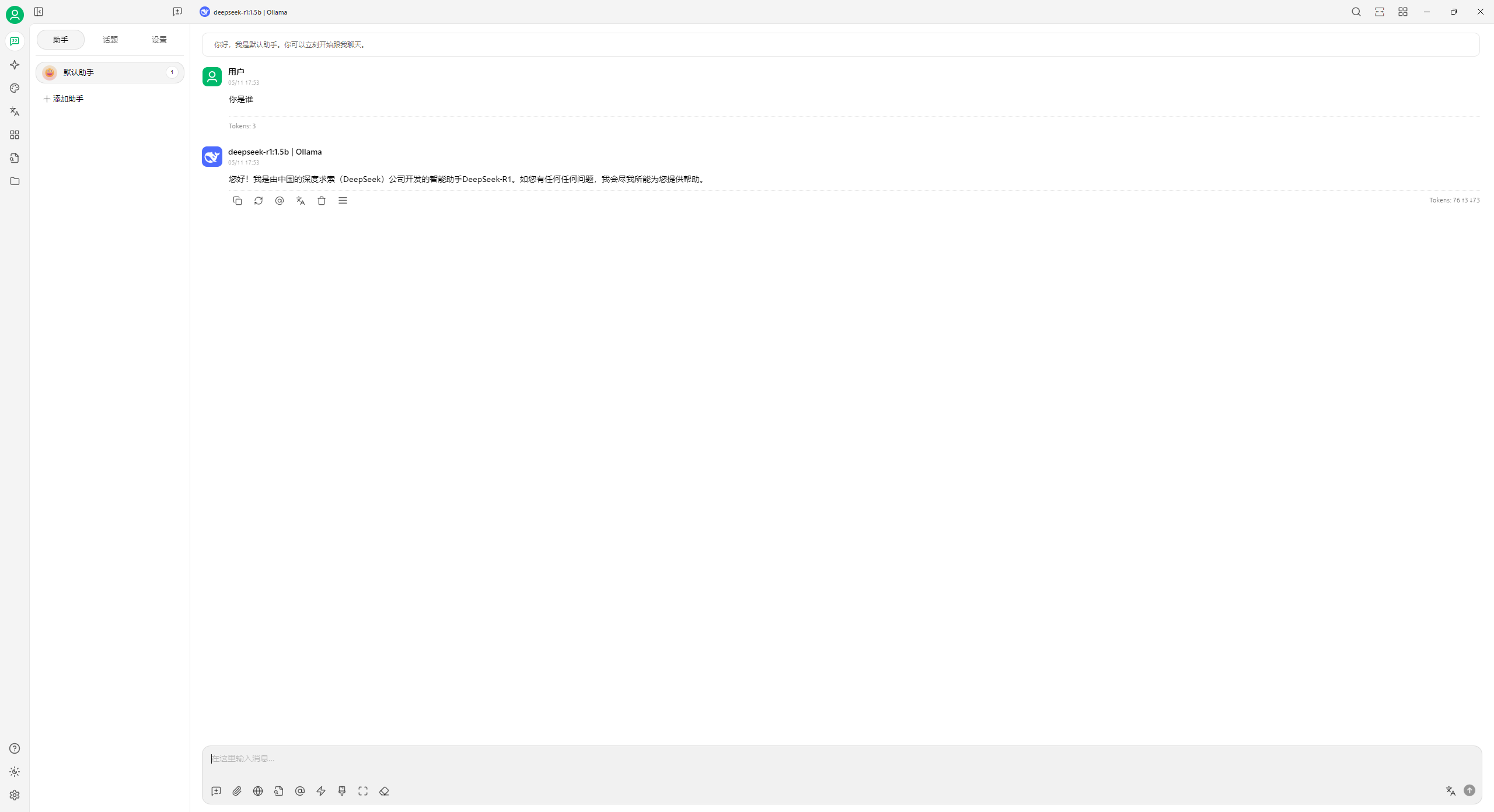

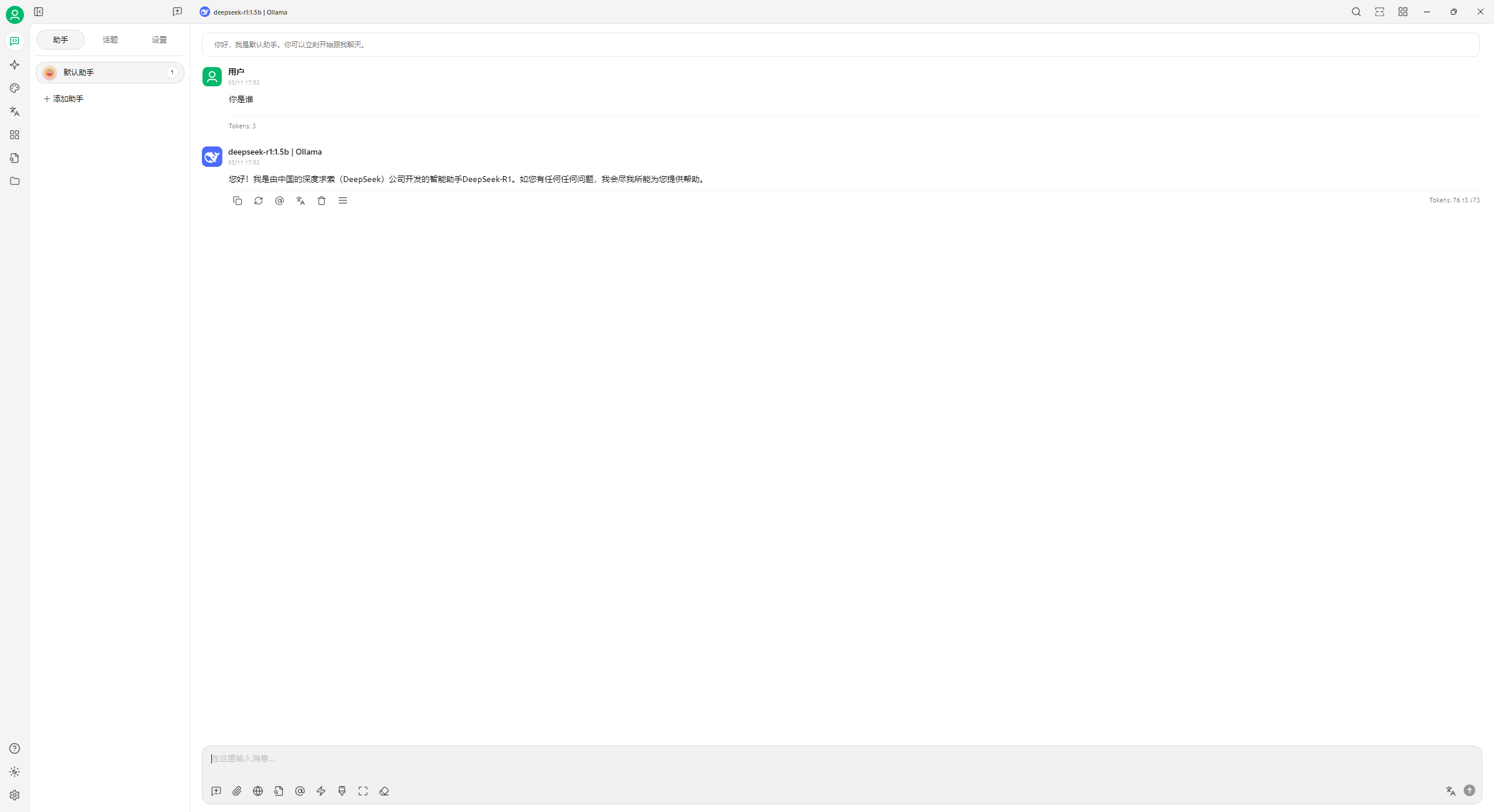

這樣就可以跟平時一樣與 DeepSeek 對話了:

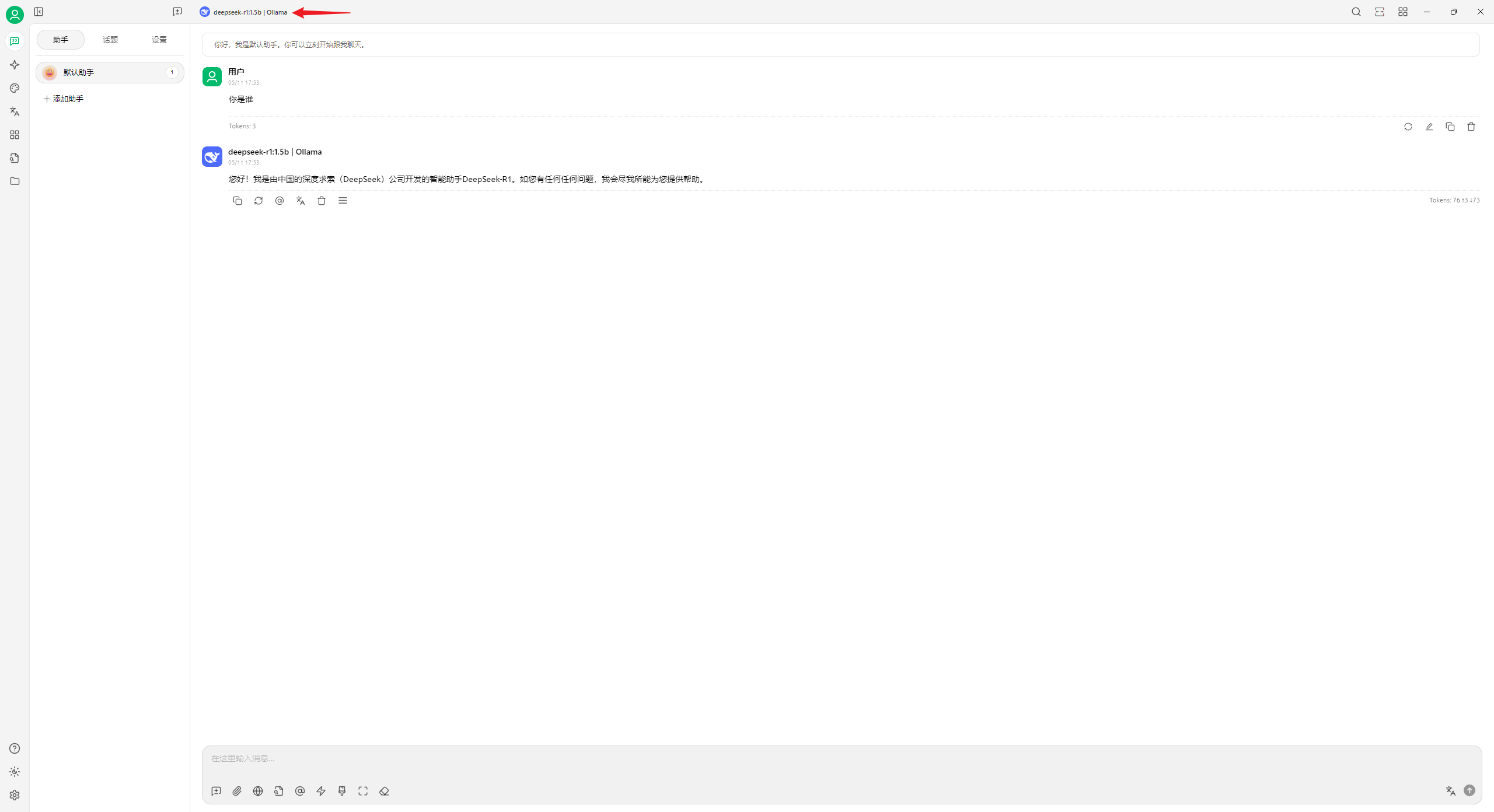

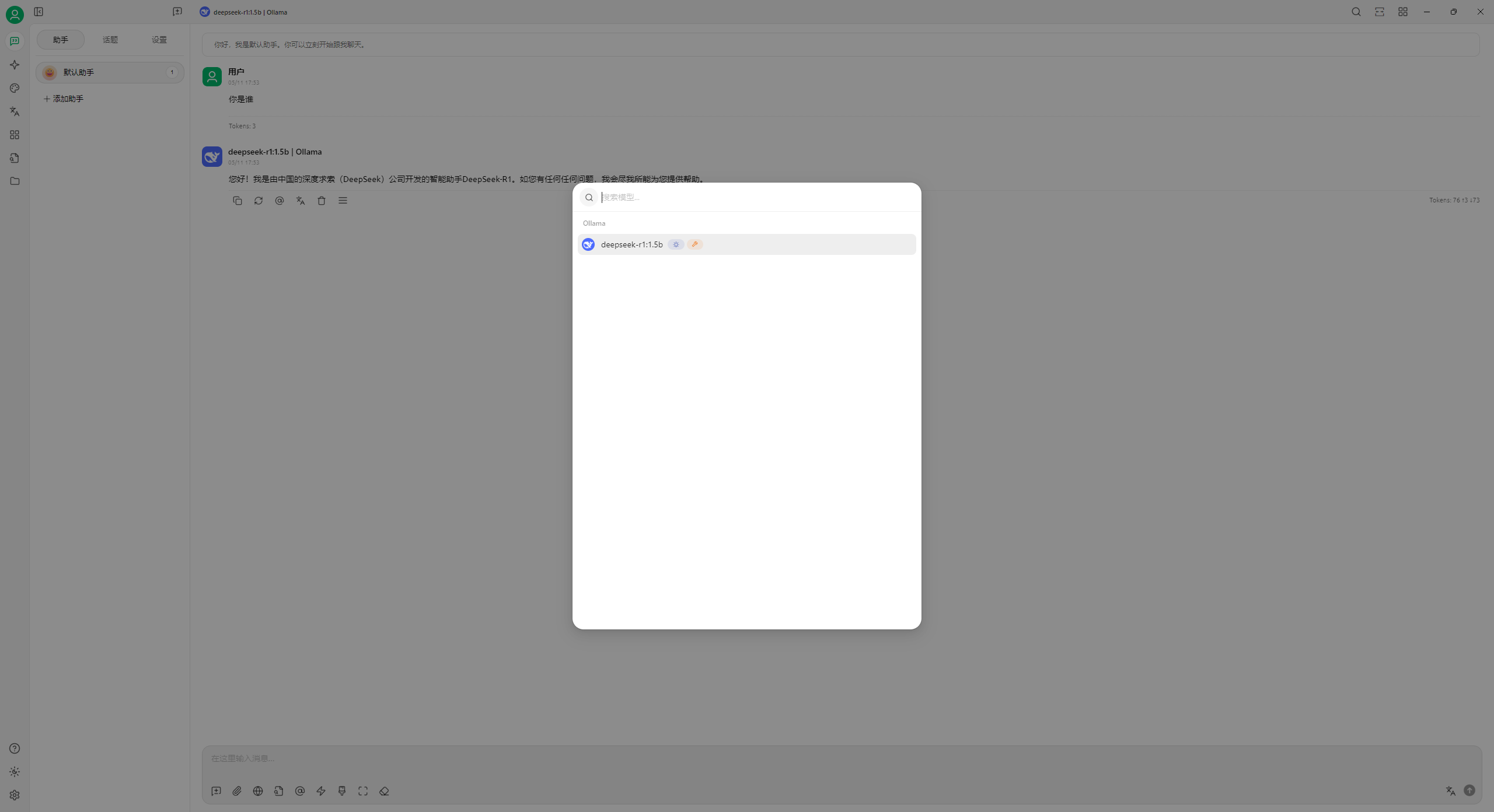

如果安裝了多個 DeepSeek 模型,還可以點擊頂部切換:

這樣就完成了自己的 DeepSeek 安裝。

電腦重啟后會在系統右下角有 Ollama 的圖標,代表 Ollama 正在運行:

如何不想運行,右鍵點擊退出即可:

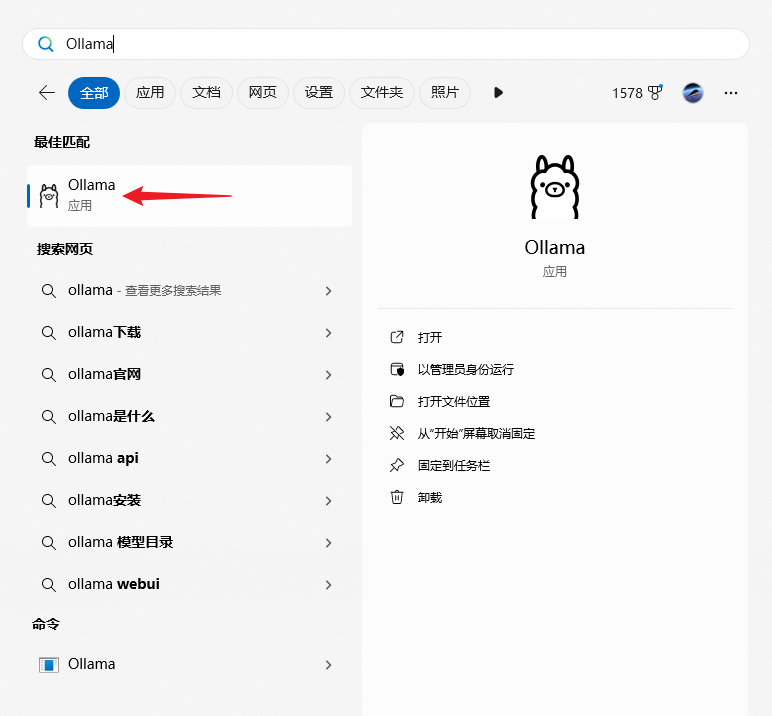

如果想要再次使用按 Win 鍵搜索“Ollama”即可打開:

然后打開 Cherry Studio 即可直接使用:

浙公網安備 33010602011771號

浙公網安備 33010602011771號