字節-大模型聯邦精調方案

概述

字節跳動安全研究團隊聯合南京大學在?語?模型聯邦精調領域發布了研究論文 A Split-and-Privatize Framework for Large Language Model Fine-Tuning 。該論文主要關注在模型即服務 (Models-as-a-Service, MaaS) 場景下,大語言模型 (Large Language Model, LLM) 精調服務中模型和數據的隱私問題。

論文提出了一種基于分割學習的“分割-隱私化” (Split-and-Privatize, SAP) 聯邦精調框架,能夠在保障模型和數據隱私的同時,有效提升模型在下游任務上的可用性,為大語言模型精調服務的實際應用落地做了更多探索努力。

研究背景

近年來,以BERT和GPT為代表的預訓練語言模型 (Pre-trained Language Model, PLM) 展現出了強大的文本學習能力,并被廣泛應用于金融、法律和醫療保健等多個領域。為了擴展預訓練模型在更多領域應用,常見的方法是使用下游任務相關的數據集對模型進行精調。但是受計算資源和技術限制,大多數用戶并沒有能力獨立完成精調任務。

當前,主流的MaaS服務商通常擁有充足的訓練資源和技術儲備,提供了豐富的預訓練模型和強大的訓練服務。因此,越來越多的用戶開始使用MaaS服務商提供的能力,即云服務模型,利用自身的私有數據集,通過選擇合適的預訓練模型進行精調,得到符合其特定需求的大語言模型。

然而,這一模式在為用戶提供便利的同時,也帶來了隱私泄露的風險。一方面,某些預訓練模型出于知識產權保護目的,無法向用戶直接公開;另一方面,用戶的訓練數據可能包含個人身份信息、商業機密等信息,直接披露給服務商會導致嚴重的隱私泄露風險。

核心問題:用戶在使用云服務廠商提供的在線模型微調服務時,需要將訓練數據上傳,會引發隱私泄露風險。

本方案目的:解決是在微調過程中保護模型信息和用戶數據隱私

針對上述問題,字節跳動安全研究團隊在深入調研隱私攻擊手段和數據擾動算法的基礎上,提出了一種基于分割學習的SAP聯邦精調框架,為模型信息和用戶數據隱私提供了良好的保護效果,并對模型可用性和隱私性之間的權衡進行了探討。

技術方案

總體框架

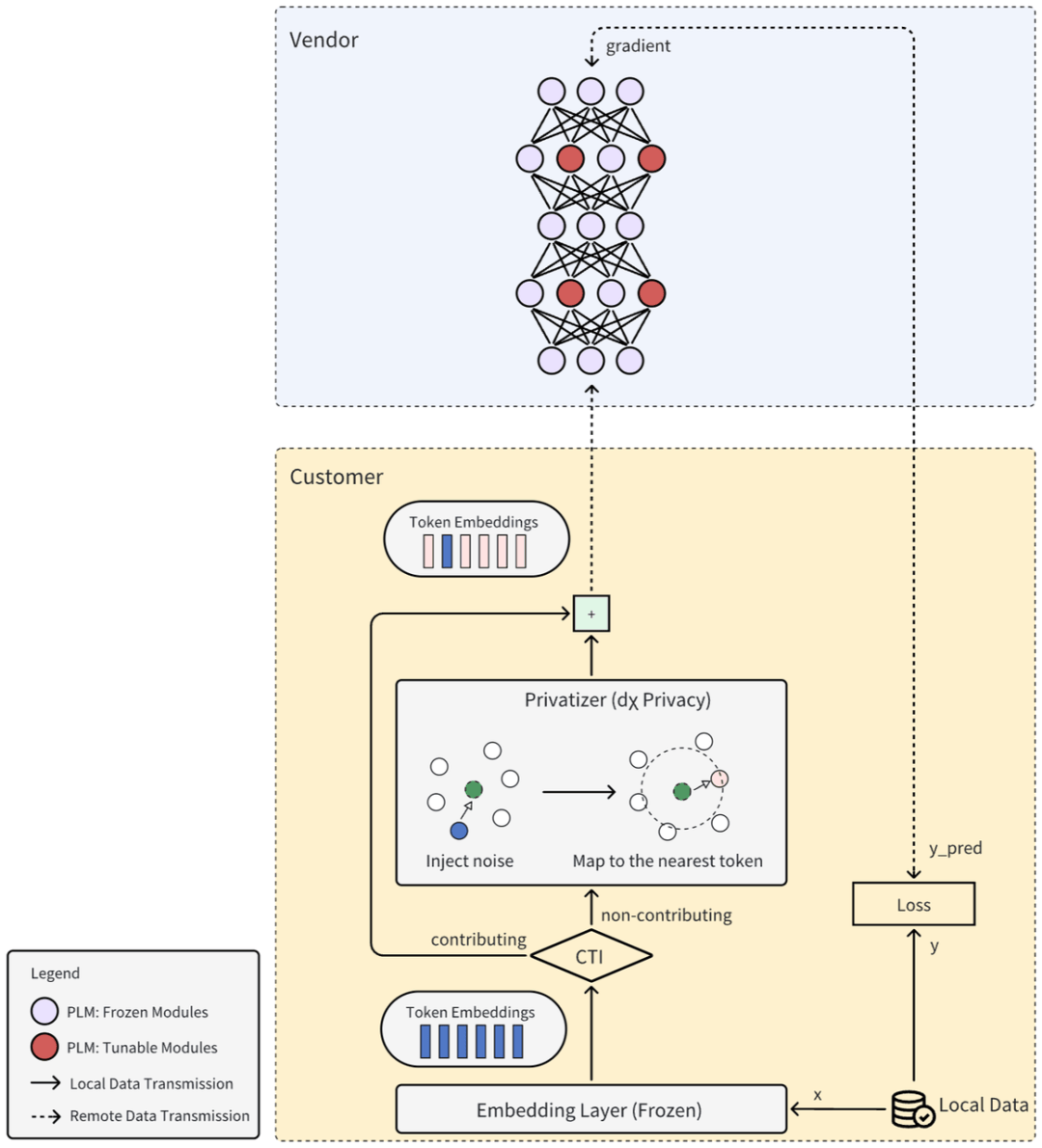

為了在實現LLM定制的同時保護服務商的模型隱私和用戶的數據隱私,論文提出了一種基于分割學習的SAP框架,下圖給出了該框架的一種實現。

從整體架構上來看,預訓練模型被分為服務商側的頂層模型和用戶側的底層模型。在精調時,用戶先用底層模型將本地私有數據轉換為向量化文本表示,然后自適應地應用隱私保護機制對文本表示進行隱私化擾動,最后再將它們發送給服務商。服務商將接收到的向量化文本表示繼續在頂層模型中前向傳播,計算模型最終的輸出。出于隱私考慮,樣本標簽也不能離開用戶本地,因此服務商需將模型輸出發送給用戶,接收返回的輸出層梯度,并將其用于反向傳播更新模型中的可訓練參數。SAP框架能夠與多種參數高效的精調方法結合以提升精調效率,例如LoRA、BitFit以及Adapter Tuning等。

SAP核心部分包括模型分割、文本隱私化和貢獻度衡量,以下分別介紹。

模型分割

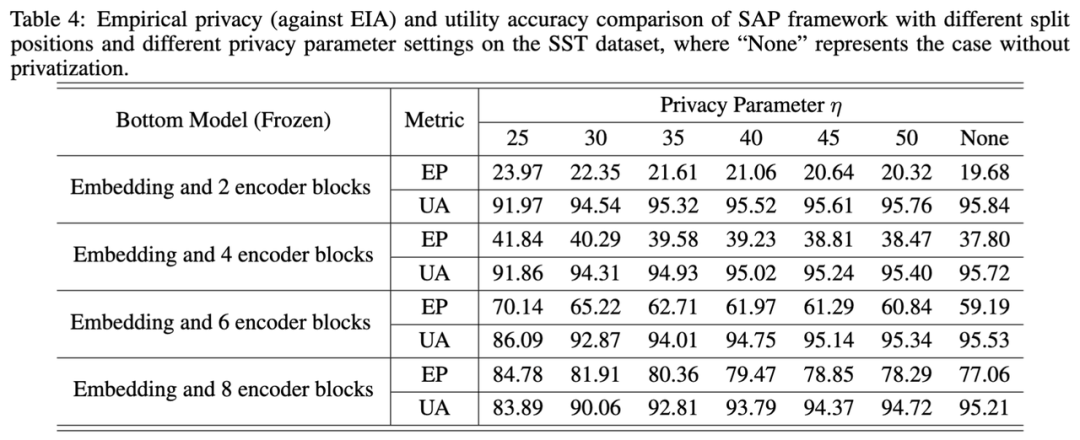

在初始化階段,服務商將預訓練模型分割為底層模型和頂層模型,并將底層模型發送給用戶。在這一步驟中,進行模型分割的層次是一個重要的選項。如果底層模型只包含嵌入 (embedding) 層,用戶的計算負擔相對較小,但服務商可以通過最近鄰搜索輕易地從傳輸的表示中恢復輸入文本。如果底層模型包含更多編碼器 (encoder) 模塊,那么從中恢復原始文本就變得更加困難,因為更深層的表示更為抽象和通用。例如在預訓練模型RoBERTa-Large(24層)中,底部模型可配置為 嵌入層 + 1~8個編碼塊(占比<25%總參數量)

此外,由于模型的權重也是服務商的重要資產,可能要求盡可能少地披露權重。因此,預訓練模型的分割位置需要結合實際應用場景綜合考慮。

拆分策略建議:

- 算力有限時:優先選擇凍結模式(如僅嵌入層),但需配合文本私有化(如dχ隱私)增強保護。

- 算力充足時:采用深層拆分(如6-8層編碼塊)的凍結模式,在幾乎不損失性能(UA僅降1%)下提升隱私率至78%(表4),優于參數更新方案。

文本隱私化

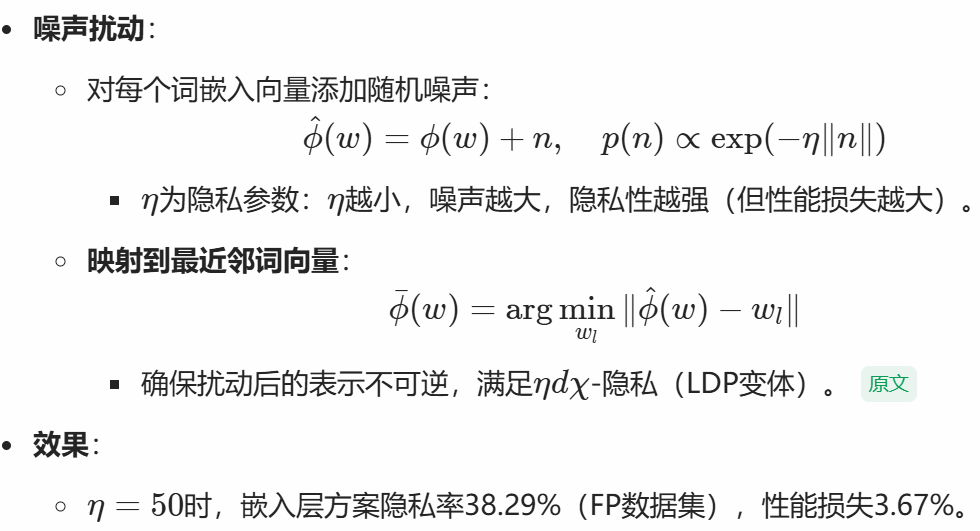

給定底層模型,用戶可以計算得到每個文本的向量化表示。然而,如果直接以明文形式發送向量化文本表示,服務商有較大可能利用反演攻擊從中恢復出原始輸入。為了加強數據隱私保護,用戶側有必要采用隱私化機制對文本表示進行擾動。SAP框架能夠簡單地與多種隱私保護機制相結合以實現更強的隱私保護,例如dχ-隱私(本地差分隱私的一種變體)和概率近似正確 (Probably Approximately Correct, PAC) 隱私。具體而言,對于每個輸入樣本,通過添加適當的隨機噪聲來生成擾動的文本表示。所使用的噪聲概率密度函數滿足指數衰減形式,即 p(n) ∝ exp(?η-nl),其中 η 是隱私參數,控制噪聲強度;n 是噪聲值;l 是噪聲維度。

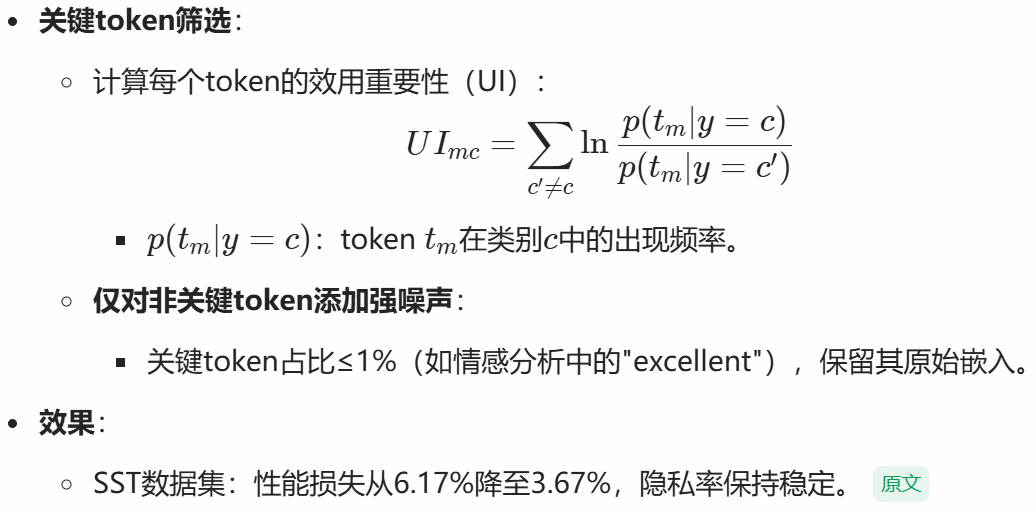

貢獻詞識別優化

引入文本隱私化機制在加強數據隱私保護的同時,也會導致一定的模型性能損失,因此存在效用與隱私之間的權衡。為了改善這種權衡,論文提出了一種貢獻詞識別優化(Contributing Token Identification,CTI)。該方法的主要原理是利用統計分析來識別每一類樣本中對效用目標貢獻度最大的token,并減小對這些極少數token的擾動,旨在提高可用性的同時保持相近的隱私保護水平。

方案評估

隱私度量

論文采用典型隱私竊取攻擊的方法來評估SAP框架的數據隱私保護能力。為最大化攻擊者的能力,文中考慮白盒設定,假設攻擊者與服務商具有相同的視角,即能夠訪問用戶傳輸的向量化文本表示以及底層模型的初始參數。所采用的攻擊方法如下:

- 嵌入反演攻擊 (Embedding Inversion Attack, EIA)。EIA是一種詞元 (token) 級別的攻擊,其目標是從擾動的向量化文本表示中恢復原始輸入文本。具體而言,對于底層模型僅有嵌入層的情況,攻擊者會在嵌入空間中搜索每個擾動向量的最近鄰作為對原始詞元的推測。對于底層模型包含更多層的情況,攻擊者會采用一種更為復雜的基于優化的攻擊方法。對于每個輸入樣本,該方法通過最小化推測文本的表示和觀察到的表示之間的距離來迭代優化詞元選擇向量。

- 屬性推理攻擊 (Attribute Inference Attack, AIA)。由于文本表示仍然包含豐富的語義信息,攻擊者可以通過AI從中推斷用戶的敏感屬性。假設攻擊者可以獲得部分樣本的隱私屬性標簽,那么隱私屬性推理可以被視為一個下游任務,攻擊者可以使用這些樣本的向量化文本表示和相應的隱私標簽來訓練一個分類器進而推斷其他樣本的隱私屬性。

論文中使用經驗隱私作為評估SAP框架隱私保護能力的指標:令X 表示攻擊成功率,經驗隱私的定義為 1 ? X。

對比實驗

- SAP框架中隱私參數η的影響:作者研究了當底部模型為凍結嵌入層時,SAP框架中隱私參數η對隱私保護能力和性能的影響。結果表明,隨著η的減小,SAP框架的隱私保護能力增強,但同時性能也會下降。例如,在FP數據集上,當η設為50時,SAP可以將隱私保護能力提高到38.85%,但性能損失為6.17%。

- SAP框架中CTI方法的效果:作者使用CTI方法來改善SAP框架中模型分割對性能的影響,并比較了不同參數下SAP框架的隱私保護能力和性能表現。結果顯示,通過減少小于1%的貢獻詞的擾動,CTI方法可以在保持近似不變的隱私保護能力的同時顯著提高性能。例如,在FP數據集上,當η設為50時,SAP-CTI算法可以達到38.29%的隱私保護能力,而僅損失3.67%的性能。

- 底部模型是否被凍結的影響:作者還研究了在SAP框架中聯合訓練底部模型和頂部模型對隱私保護能力和性能的影響。結果表明,當底部模型只包含一個嵌入層時,聯合訓練對性能影響較小,但會導致隱私保護能力顯著降低。原因是,底部模型的參數變化很小,攻擊者仍然可以使用初始參數進行最近鄰搜索,從而增加攻擊成功率。

- 模型分割位置的選擇:最后,作者探討了SAP框架中模型分割位置對隱私保護能力和性能的影響。結果顯示,隨著分割位置從底部模型中移除更多的編碼器塊,攻擊者從客戶發送的表示中推斷輸入文本的能力變得越來越困難。即使沒有文本隱私化,當有8個編碼器塊時,SAP框架的隱私保護能力可以達到約80%。

主要結果

實驗表明,SAP框架能夠在保護模型隱私和數據隱私之間取得良好的平衡,同時最大限度地保證了模型的可用性。此外,SAP框架具有較高的靈活性,能夠適應大語言模型精調服務中的多種需求場景。

- 對于用戶計算資源相對有限的情況,可以采用底層模型僅有嵌入層的解決方案。在Roberta-Large模型和Stanford Sentiment Treebank (SST) 情感分析數據集上的實驗結果表明,SAP框架以6%的模型性能損失換取了36%的經驗隱私提升;

- 對于用戶計算資源相對豐富的情況,可以采用底層模型包含多個encoder模塊的解決方案。SST數據集上的實驗結果表明,在底層模型有6個encoder模塊的情況下(占整個模型的四分之一),SAP框架以1%的模型性能損失換取了62%的經驗隱私提升。

總結

文章使用的是哪個模型?

- 模型名稱:RoBERTa-Large(基于BERT架構的改進模型)

- 參數規模:總參數量為 3.55億

- RoBERTa-Large包含24層Transformer編碼塊,實驗中通過調整底部模型的編碼塊數量(如1-8層)驗證不同拆分策略對隱私保護的影響。

如何保護用戶數據隱私?

- 文本私有化:客戶在本地對底部模型輸出的文本表示(如詞嵌入向量)添加噪聲擾動,再傳輸給服務商。

- 分層隔離增強隱私:底部模型包含更多編碼塊(如6-8層)時,中間表示更抽象,攻擊難度顯著增加。

- 動態訓練:非凍結模式下,底部模型參數在訓練中更新,使中間表示動態變化,增加攻擊者反推難度。

- 貢獻詞識別優化(CIT):減少對關鍵token的擾動,緩解私有化導致的性能損失。

如何保護模型信息隱私?

-

服務商將預訓練語言模型(PLM)拆分為底部模型(部署在客戶端)和頂部模型(保留在服務商服務器),僅底部模型(如嵌入層或少量編碼塊)被傳輸給客戶,95%以上的核心模型參數始終保留在服務商端,避免模型架構和權重泄露。

-

動態訓練方式:

- 底部模型參數不變:客戶僅使用底部模型計算隱私向量表示后一次性發送,服務商獨立微調頂部模型。隱私風險低,可能被攻擊者利用多次觀察反推輸入。

- 底部模型參數更新:服務商返回頂部模型輸出的梯度以更新底部模型。隱私風險高,動態變化的中間表示增加攻擊難度,使其反推原始輸入更困難。

框架能保護推理安全么?

-

客戶在推理時需將輸入文本通過本地底部模型計算中間表示,并施加與訓練階段相同的噪聲擾動,再將擾動后的表示發送給服務商,服務商無法從擾動表示反推原始輸入。

-

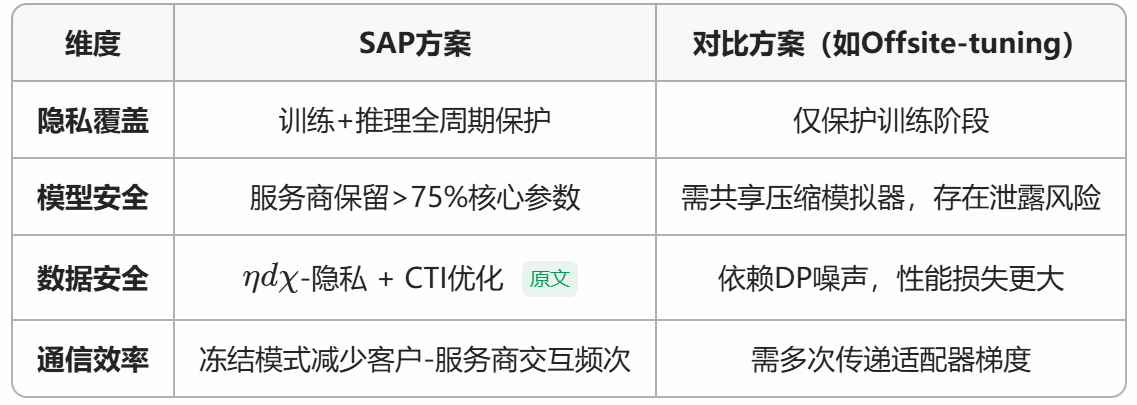

本方案優于離線調優(Offsite-tuning),覆蓋了訓練與推理全周期保護,而Offsite-tuning僅保護訓練階段。

浙公網安備 33010602011771號

浙公網安備 33010602011771號