Pytorch實戰學習(五):多分類問題

《PyTorch深度學習實踐》完結合集_嗶哩嗶哩_bilibili

Softmax Classifer

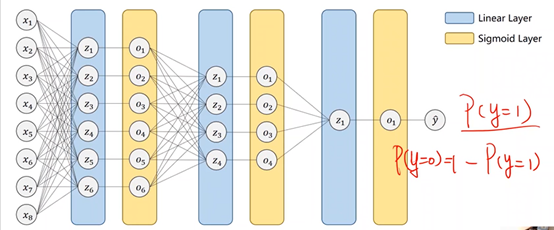

1、二分類問題:糖尿病預測

2、多分類問題

MNIST Dataset:10個標簽,圖像數字(0-9)識別

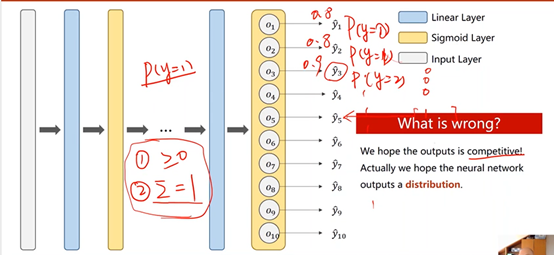

①用sigmoid:輸出每個類別的概率

但這種情況下,類別之間所存在的互相抑制的關系沒有辦法體現,當一個類別出現的概率較高時,其他類別出現的概率仍然有可能很高。

換言之,當計算輸出為1的概率之后,再計算輸出為2的概率時,并不是在輸出為非1的條件下進行的,也就是說,所有輸出的概率之和實際上是大于1的。

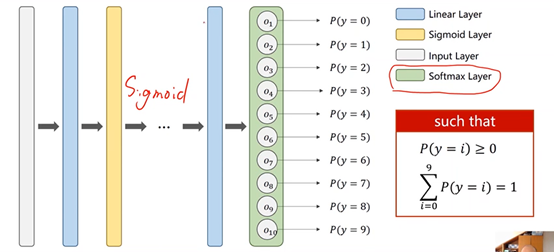

②用softmax:輸出每個類別的概率的分布

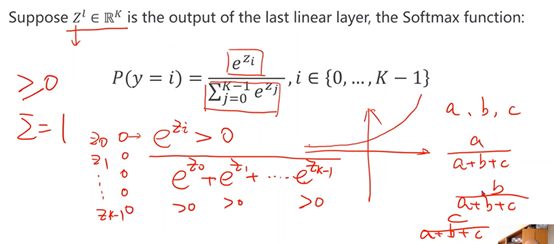

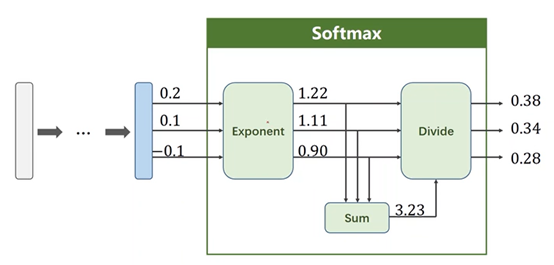

3、softmax原理

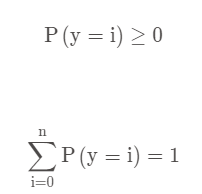

保證兩點:

※每個類別概率都>0------指數函數

※所有類別概率相加為1------求和,占比

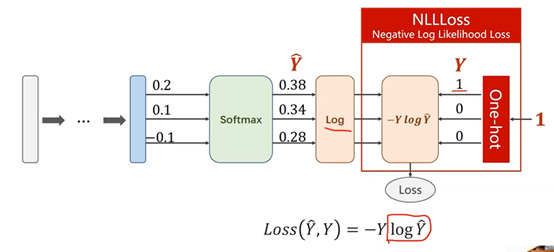

4、Softmax Loss Function

①NLLLoss

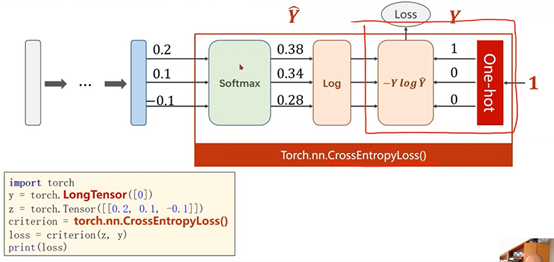

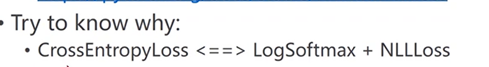

②Torch.nn.CrossEntropyLoss()中包含了最后一層的softmax激活

③交叉熵損失(CrossEntropyLoss)和NLL損失之間的差別

5、實例:MNIST Dataset

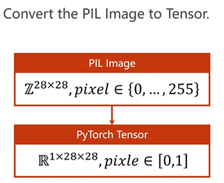

①數據準備

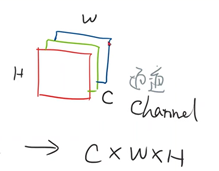

transform將圖像轉換成圖像張量(CxWxH)(通道x寬x高),取值在[0,1]

再進行標準化

## 將圖像數據轉換成圖像張量 transform = transforms.Compose([ transforms.ToTensor(), # 標準化,均值和標準差 transforms.Normalize((0.1307,), (0.3081,)) ])

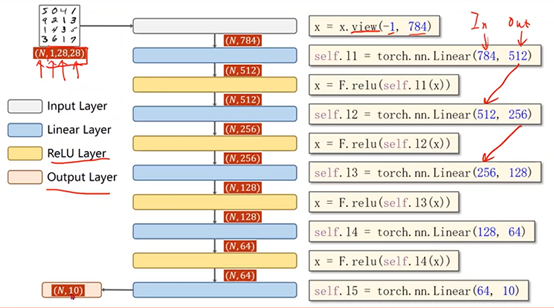

②模型構建

完整代碼

# -*- coding: utf-8 -*- """ Created on Wed Aug 4 09:08:32 2021 @author: motoh """ import torch ## 對圖像數據進行處理的包 from torchvision import transforms from torchvision import datasets from torch.utils.data import DataLoader import torch.nn.functional as F import torch.optim as optim # prepare dataset batch_size = 64 ## 將圖像數據轉換成圖像張量 # 標準化,均值和標準差 transform = transforms.Compose([transforms.ToTensor(), transforms.Normalize((0.1307,), (0.3081,))]) train_dataset = datasets.MNIST(root='../dataset/mnist/', train=True, download=True, transform=transform) train_loader = DataLoader(train_dataset, shuffle=True, batch_size=batch_size) test_dataset = datasets.MNIST(root='../dataset/mnist/', train=False, download=True, transform=transform) test_loader = DataLoader(test_dataset, shuffle=False, batch_size=batch_size) # design model using class class Net(torch.nn.Module): def __init__(self): super(Net, self).__init__() self.l1 = torch.nn.Linear(784, 512) self.l2 = torch.nn.Linear(512, 256) self.l3 = torch.nn.Linear(256, 128) self.l4 = torch.nn.Linear(128, 64) self.l5 = torch.nn.Linear(64, 10) def forward(self, x): #變成矩陣 -1其實就是自動獲取mini_batch,784是1*28*28,圖片的像素數量 x = x.view(-1, 784) x = F.relu(self.l1(x)) x = F.relu(self.l2(x)) x = F.relu(self.l3(x)) x = F.relu(self.l4(x)) # 最后一層不做激活,不進行非線性變換 return self.l5(x) model = Net() # construct loss and optimizer criterion = torch.nn.CrossEntropyLoss() optimizer = optim.SGD(model.parameters(), lr=0.01, momentum=0.5) # training cycle forward, backward, update def train(epoch): running_loss = 0.0 for batch_idx, data in enumerate(train_loader, 0): # 獲得一個批次的數據和標簽 inputs, target = data optimizer.zero_grad() # 獲得模型預測結果(64, 10) outputs = model(inputs) # 交叉熵代價函數outputs(64,10),target(64) loss = criterion(outputs, target) loss.backward() optimizer.step() running_loss += loss.item() if batch_idx % 300 == 299: print('[%d, %5d] loss: %.3f' % (epoch+1, batch_idx+1, running_loss/300)) running_loss = 0.0 def test(): correct = 0 total = 0 ## 不計算梯度 with torch.no_grad(): for data in test_loader: images, labels = data outputs = model(images) # dim = 1 列是第0個維度,行是第1個維度,## 每一行最大值的下標 _, predicted = torch.max(outputs.data, dim=1) total += labels.size(0) correct += (predicted == labels).sum().item() # 張量之間的比較運算 print('accuracy on test set: %d %% ' % (100*correct/total)) if __name__ == '__main__': for epoch in range(10): train(epoch) test()

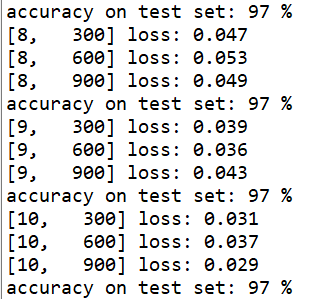

運行結果

浙公網安備 33010602011771號

浙公網安備 33010602011771號