應用引入LLM實踐

LLM最近在各行各業遍地開花,產生了很好的效果,也落地了很多好的功能應用。

無論是從實際應用角度,還是從營銷角度,我們都需要接入大模型能力。

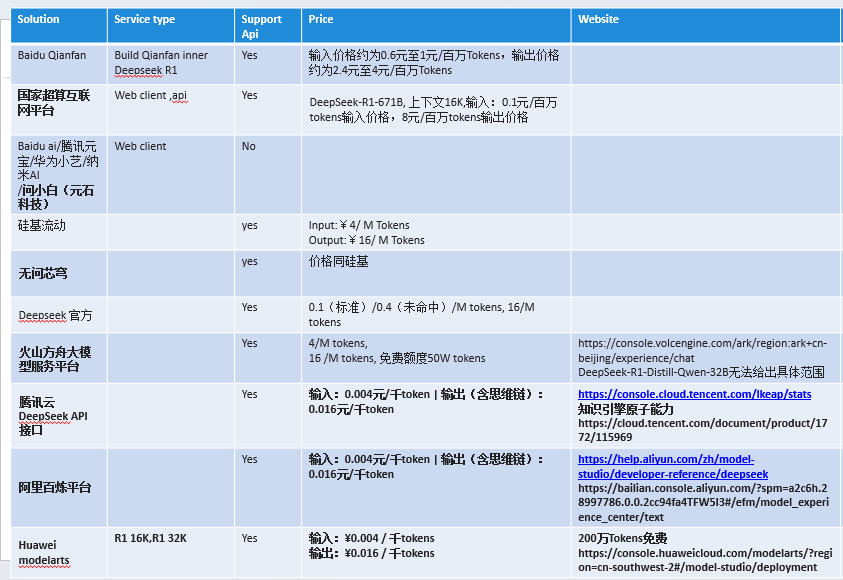

拿國內比較火的Deepseek來說,具有良好的推理能力,可以在我們的產品中幫我們做一些信息溯源的工作,考慮接入這部分功能,deepseek自己部署要耗費不少成本,我們暫時不考慮。國內云商已經大量接入deepseek能力,并且對外提供服務,我們考慮接入云商的deepseek能力。前期做了一些調研:

關于集成,目前大部分都是使用openai庫集成LLM,有一套規范的方法,集成方法實例如下:

from openai import OpenAI if __name__ == '__main__': #DeepSeek-R1-32K base_url = "https://maas-cn-southwest-2.modelarts-maas.com/v1/infers/8a062fd4-7367-4ab4-a936-5eeb8fb821c4/v1" #DeepSeek-R1-671B-32K #base_url = "https://maas-cn-southwest-2.modelarts-maas.com/v1/infers/952e4f88-ef93-4398-ae8d-af37f63f0d8e/v1" api_key = "Y****" # 把<your_apiKey>替換成已獲取的API Key。 client = OpenAI(api_key=api_key, base_url=base_url) response = client.chat.completions.create( model="DeepSeek-R1", messages=[ {"role": "system", "content": "You are an assistant"}, {"role": "user", "content": "Your task is to help me complete some simple word processing tasks"}, ], max_tokens=1024, temperature=0.6, stream=False ) # Print result. print(response.choices[0].message.content)

目前云商都提供免費token 供試用,可以薅一下羊毛,我們多集成幾個大模型

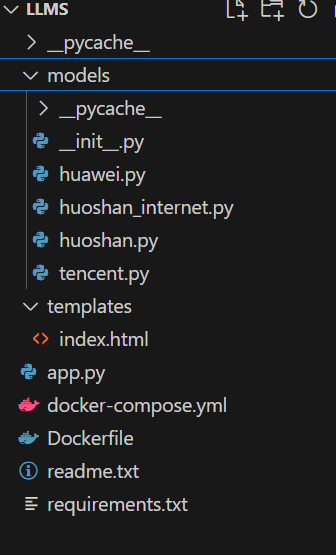

我們使用flas框架封裝一套框架,結構如下:

然后打包成docker,這樣就可以使用API的方式免費調用Deepseek大模型了!!

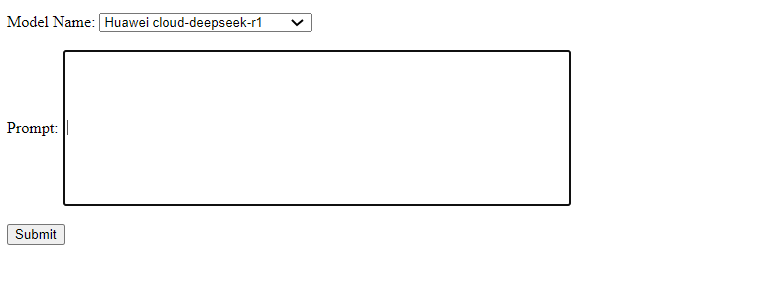

可以做一個簡單的頁面使用。

浙公網安備 33010602011771號

浙公網安備 33010602011771號