給 Ollama 穿上 GPT 的外衣

上一篇我們介紹了如何在本地部署 ollama 運行 llama3 大模型。過程是相當簡單的。但是現在給大模型交流只能在命令行窗口進行。這樣的話就只能你自己玩了。獨樂樂不如眾樂樂嘛。我們接下來說一下如何部署 open-webui 給 ollama 加一個 webui,這樣用戶就可以通過瀏覽器訪問我們的本地大模型了,體驗非常類似 chatGPT。

Open-WebUI

Open-WebUI 是一個開源的用戶界面框架,旨在提供簡便的工具和接口,幫助用戶輕松地訪問和管理各種深度學習模型,尤其是大規模預訓練語言模型。以下是對Open-WebUI的簡要介紹:

-

開源框架: Open-WebUI 是一個開源項目,提供了靈活且可定制的用戶界面,用于與各種深度學習模型進行交互。

-

模型管理: 通過 Open-WebUI,用戶可以方便地加載、配置和管理多個深度學習模型,包括 GPT-4、BERT 等大規模預訓練模型。

-

用戶友好: 它提供了直觀的界面,簡化了模型使用過程,使非技術用戶也能輕松上手進行自然語言處理任務。

-

集成支持: Open-WebUI 支持與多種后端深度學習框架(如 TensorFlow、PyTorch)集成,提供高效的推理和訓練功能。

擴展性強: 用戶可以根據需求自定義和擴展界面功能,以適應不同的應用場景和任務需求。

總之,Open-WebUI 為用戶提供了一個高效、直觀的界面,使得大規模深度學習模型的使用更加便捷和高效。

地址:https://github.com/open-webui/open-webui

使用 Docker 部署

使用 Docker 部署非常簡單。如果 ollama 跟 open-webui 部署在同一個機器上,那么只需要運行一下代碼就可以。

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

如果 ollama 部署在其他服務器就用如下命令:

docker run -d -p 3000:8080 -e OLLAMA_BASE_URL=https://example.com -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

OLLAMA_BASE_URL 是指 ollama 暴露的API地址,一般為服務器地址加 11434。如:OLLAMA_BASE_URL=http://192.168.0.111:11434

使用 Open-WebUI

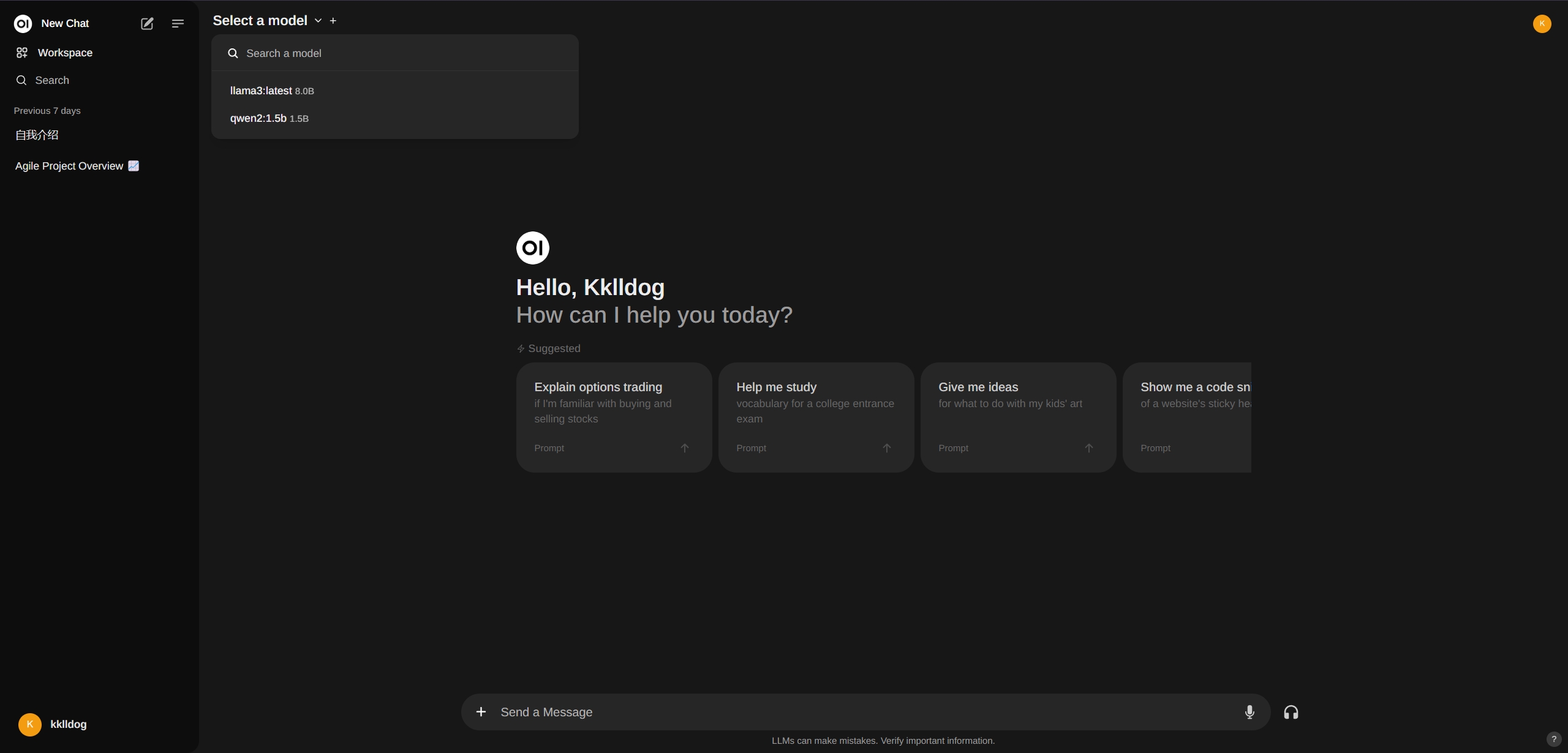

部署完之后,我們在瀏覽器里打開 http://localhost:3000,就會出現 Open-WebUI 的界面。看起來跟 chatGPT 不能說一模一樣么,也是毫無區別。隨便填寫一個郵箱后就可以注冊第一個賬戶。

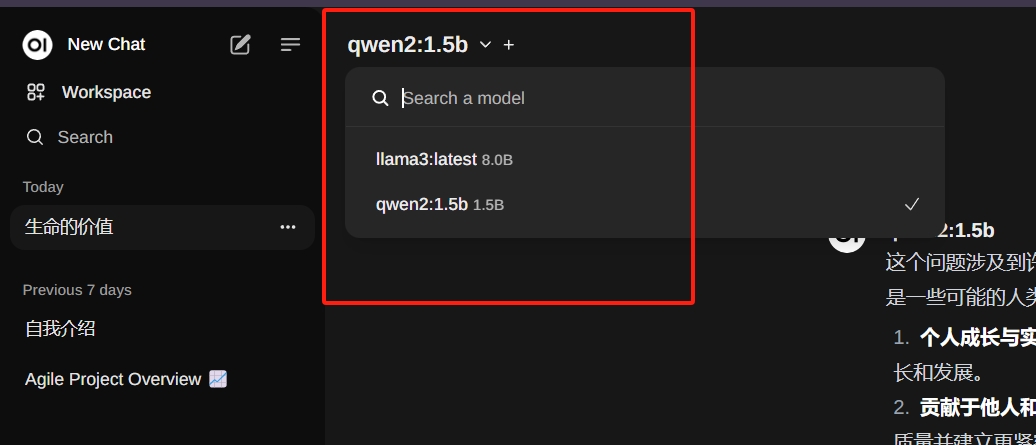

在右上角可以選擇已經存在的模型。也可以搜索其他模型,然后直接安裝,這個就非常方便了。

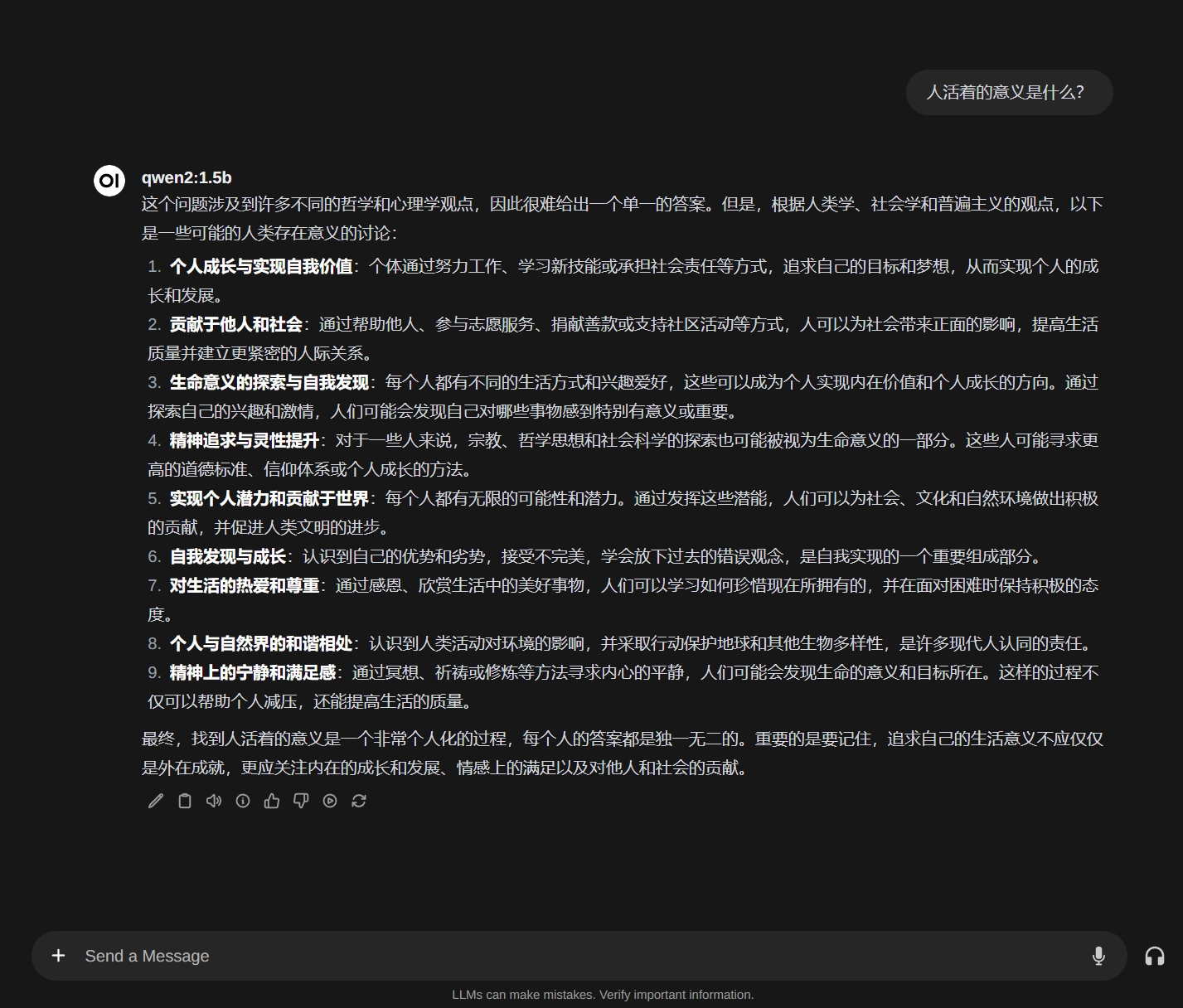

讓我們下載一個傳說中巨牛比的國產大模型 Qwen2 試試。隨便問個問題,好像還不錯。

總結

這一篇內容比較短,就是演示了一下如何使用 Open-WebUI 項目搭建一個本地的 chat 服務。這樣就可以把本地大模型共享出去。這樣你全家人都可以訪問你部署的大模型了。當然你要是部署到外網的服務器上那就是給全世界人用了。

當然本地大模型所能回答的問題都是公開領域的知識,比如你問它你們家有幾口人肯定是不知道的。下次我們會將如何讓大模型學習你的私有知識,也就是搭建一個本地的知識庫。

關注我的公眾號一起玩轉技術

QQ群:1022985150 VX:kklldog 一起探討學習.NET技術

作者:Agile.Zhou(kklldog)

出處:http://www.rzrgm.cn/kklldog/

本文版權歸作者和博客園共有,歡迎轉載,但未經作者同意必須保留此段聲明,且在文章頁面明顯位置給出原文連接,否則保留追究法律責任的權利。

浙公網安備 33010602011771號

浙公網安備 33010602011771號