深度學習之參數更新方法(全是轉載,哭笑)

https://blog.csdn.net/u012328159/article/details/80311892

https://zhuanlan.zhihu.com/p/21486826

http://www.mamicode.com/info-detail-1931210.html

推薦看這個 https://blog.csdn.net/tsyccnh/article/details/76270707

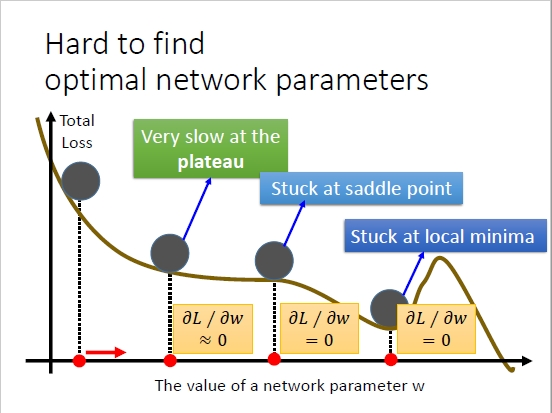

隨機梯度下降法(stochastic gradient descent 簡寫SGD)的缺點,如圖所示:

Y軸表示損失函數,X軸表示神經網絡的權重參數W。

缺點:有時候梯度下降很慢,有時候W取值處在某個鞍點,有時候W取值在某個谷點而導致損失函數取得局部最小值。

浙公網安備 33010602011771號

浙公網安備 33010602011771號