信息論之聯合熵、邊緣熵、條件熵、交叉熵

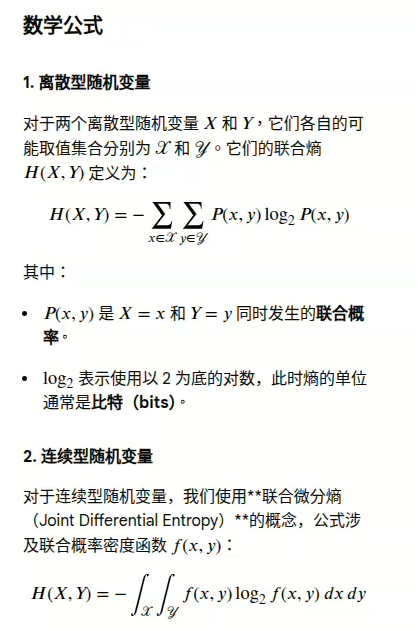

聯合熵(Joint Entropy)是信息論中的一個重要概念,它衡量的是兩個或多個隨機變量作為一個整體的平均不確定性。

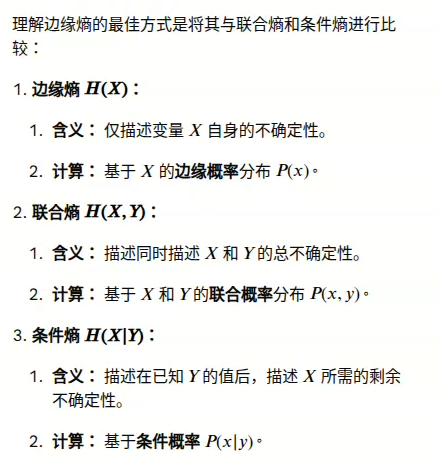

邊緣熵(Marginal Entropy)是信息論中的一個概念,它指的是在多變量概率分布中,僅考慮單個隨機變量時的熵值。

這編輯框不支持特殊數學符號,打字也困難,直接貼上書上的圖片。

核心概念

簡單來說,熵??(??)衡量單個隨機變量 ?? 的信息量或不確定性。聯合熵 ?? (??,??) 則衡量同時觀察到變量??和變量 ?? 的值所帶來的總不確定性或平均信息量。

例如,如果你要預測一個人的身高(變量 X)和體重(變量 Y):

- 預測身高有一定的不確定性 ?? ( ?? )

- 預測體重有一定的不確定性 ?? ( ?? )

- 同時預測身高和體重的組合(例如,“身高170cm且體重65kg”)的不確定性就是聯合熵?? (??,??)

總結

聯合熵是衡量多個變量集體不確定性的度量,是理解和量化復雜數據關系的基礎工具,在機器學習、自然語言處理和數據壓縮等領域都有重要應用。

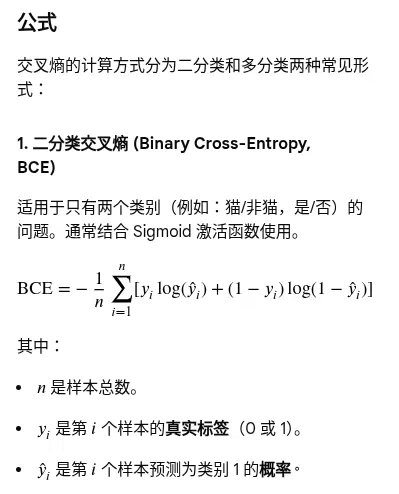

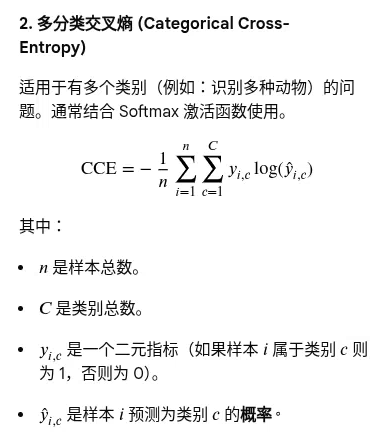

交叉熵(Cross-Entropy)是信息論中的一個重要概念,在機器學習,尤其是分類任務中被廣泛用作損失函數(Loss Function)。它主要用于衡量兩個概率分布之間的差異。

核心定義與作用

在機器學習的背景下,交叉熵衡量的是:

- 真實概率分布(Target Distribution??): 數據的真實標簽或實際情況。

- 模型預測概率分布(Predicted Distribution Q): 模型預測出的屬于各個類別的概率。

目標:訓練模型時,我們希望模型的預測分布??盡可能接近真實分布??。最小化交叉熵損失,就是使模型學會準確地預測每個樣本所屬的類別概率。

為什么使用交叉熵作為損失函數?

- 衡量準確性: 交叉熵的值越小,表示兩個概率分布越接近,模型的預測越準確。

- 梯度特性: 與均方誤差(MSE)在分類問題中可能導致的梯度消失問題不同,交叉熵損失函數具有良好的數學特性,能提供穩定的梯度,有助于神經網絡高效訓練和收斂。

- 直觀意義: 從信息論角度看,交叉熵可以理解為使用模型預測的分布對真實事件進行編碼所需的平均信息量(比特數),信息量越少說明模型越高效、越準確。

摘自:《信息論》

浙公網安備 33010602011771號

浙公網安備 33010602011771號