機器學習之決策樹

決策樹(Decision Tree)是一種常見的非參數監督學習算法,可用于分類和回歸任務。它通過構建樹狀模型,模擬人類決策過程,將數據根據不同的特征進行分割,最終在樹的葉子節點得出結論。

1. 決策樹的結構

一個完整的決策樹由以下幾個部分構成:

- 根節點(Root Node): 代表整個數據集的起點。

- 內部節點(Internal Node): 代表一個特征上的“測試”或“決定”,根據該特征的不同取值將數據分流到不同的子節點。

- 分支(Branch): 連接節點之間的路徑,代表一個決策規則或測試結果。

- 葉子節點(Leaf Node): 樹的末端,代表最終的分類結果或回歸預測值。

2. 工作原理

決策樹的構建過程基于一種分而治之的貪心策略,通過遞歸地將數據集分割成越來越純的子集。核心步驟如下:

- 特征選擇: 從所有可用特征中,選擇一個最佳特征作為分割依據。常用的選擇標準包括信息增益(Information Gain)、信息增益率(Gain Ratio)和基尼不純度(Gini Impurity)。

- 遞歸構建: 選定特征后,根據其值將數據集分割成子集。對每個子集,遞歸地重復第一步和第二步,直到滿足停止條件。

- 停止條件: 決策樹停止生長的常見條件包括:

- 節點上的所有數據都屬于同一類別。

- 所有特征都已用完。

- 節點中的數據樣本數量低于某個預設閾值。

- 剪枝(Pruning): 為了防止過擬合,通常會在樹構建完成后進行剪枝,即刪除一些不必要的葉子節點或子樹,以提高模型的泛化能力。

3. 優點和缺點

優點

- 直觀易理解: 決策樹的結構類似流程圖,可以被清晰地可視化,易于人類理解和解釋。

- 無需數據預處理: 決策樹對數據的縮放和歸一化不敏感,并且可以自然處理缺失值。

- 能處理多種數據類型: 可以同時處理分類(離散值)和回歸(連續值)問題。

- 無參數假設: 作為一種非參數方法,決策樹不依賴于特定的數據分布假設。

缺點

- 容易過擬合: 如果決策樹的深度過大,它可能會過度擬合訓練數據中的噪聲,導致泛化能力下降。

- 對數據敏感: 訓練數據中微小的變化可能導致樹的結構發生巨大改變,從而導致模型不穩定。

- 最優解難尋: 由于采用貪心算法,決策樹在每個分割點只尋找局部最優解,不能保證找到全局最優解。

4. 經典算法

- ID3: 使用信息增益作為分裂準則,傾向于選擇有更多取值的特征。

- C4.5: ID3的改進版,使用信息增益率作為分裂準則,解決了ID3偏向多值特征的問題,并能處理連續值和缺失值。

- CART(分類與回歸樹): 使用基尼不純度作為分裂準則(用于分類),或使用均方誤差(用于回歸),可以生成二叉樹。

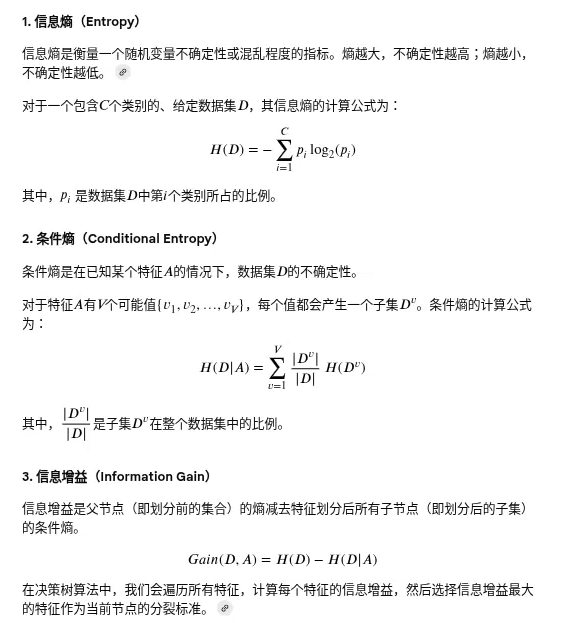

信息增益(Information Gain)是決策樹算法中用來選擇最佳特征進行節點劃分的重要標準。它的核心思想是,在得知一個特征的信息之后,能減少多少不確定性。

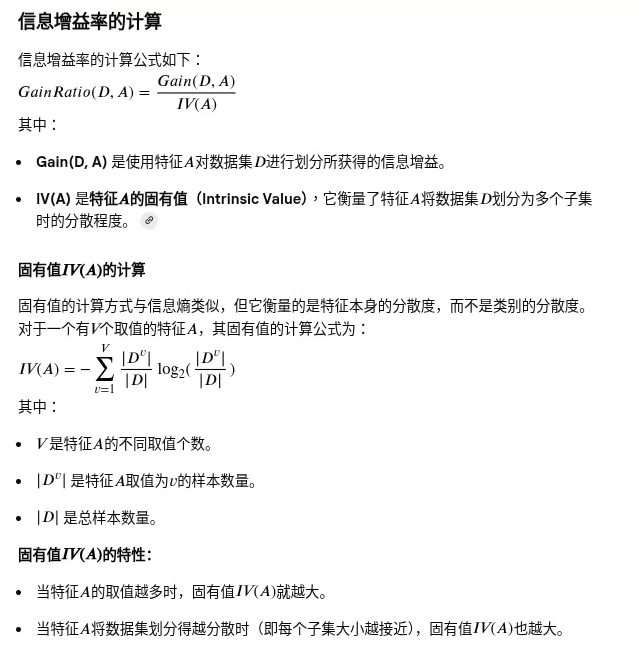

信息增益率(Information Gain Ratio):決策樹算法C4.5中用于解決信息增益偏向于選擇取值較多特征的問題而提出的。它是在信息增益的基礎上,通過引入一個懲罰因子來修正信息增益的不足。

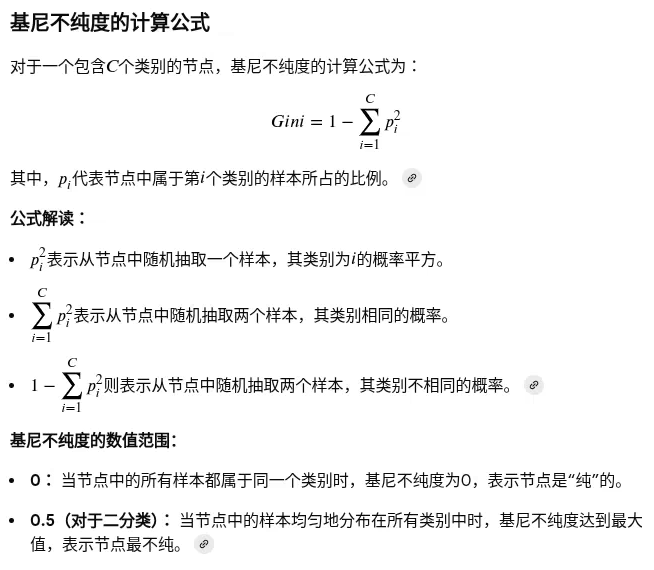

基尼不純度(Gini Impurity):一種用于決策樹算法(特別是CART算法)中的分類指標,用來衡量一個節點中樣本集合的不確定性或混亂程度。它的目標是找到一個特征和分割點,使得劃分后的子節點集合的基尼不純度最低,從而獲得“最純”的劃分。

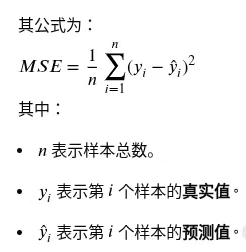

均方誤差:

均方誤差衡量模型精度: MSE值越小,代表模型預測值與真實值越接近,模型的準確性越高。

應用場景

決策樹由于其直觀性和有效性,在多個領域都有廣泛應用:

- 客戶流失預測: 通過分析客戶行為數據,預測哪些客戶可能流失。

- 疾病診斷: 基于患者癥狀和檢查結果,輔助醫生進行疾病診斷。

- 風險評估: 在金融領域,用于評估貸款申請人的信用風險。

- 欺詐檢測: 通過分析交易記錄,識別潛在的欺詐行為。

參考資料:

決策樹中的信息增益、信息增益比和基尼系數

浙公網安備 33010602011771號

浙公網安備 33010602011771號