教你如何用GPT-5來分析你的dump文件定位內存泄漏問題——避免無效加班必備神器

最近這半年,智能體很火,vibe coding也很火,相信很多園子里的小伙伴也都用上了各種AI智能體輔助編程。之前的文章《ChatGPT Codex試用心得,碼農的可靠助手or失業號角?》中我也介紹過openai推出的沙盒Codex,恰逢前段時間codex-cli推出了cli版本(實際上很早就有了,但是之前的版本只能用燒api token而不是像claude code那樣可以用plus賬號授權使用所以一直沒下載)新版本可以集成gpt-5。所以進行了嘗試,有plus賬號的小伙伴可以移步https://developers.openai.com/codex/cli下載安裝,過程很簡單,不再贅述。

今天要講的是如何通過codex結合gpt-5的能力定位一個內存泄漏問題,我相信說到dump分析問題,大部分開發還是不太熟悉,但是卻又不得不面對生產環境中遇到的各種問題,能分析dump的大佬不多,能夠傾囊相授的更少(此處點贊@一線碼農大佬)。當只有自己硬著頭皮上的時候,那codex就可以出來表演了。

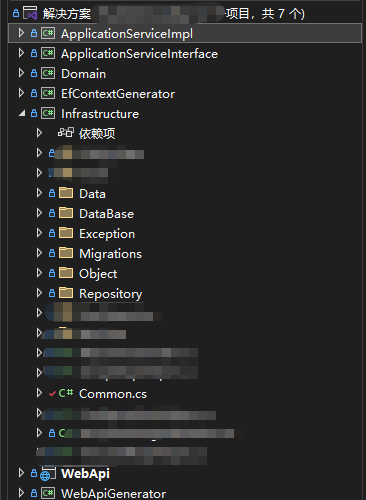

這里我采用真實項目測試,一方面是給codex上點難度(需要從真實的業務代碼中定位到問題),一方面也避免過于簡單的console演示不貼近生產環境。這一次演示的是托管內存泄漏,即運行的進程內存慢慢漲,確不見內存回收的場景。

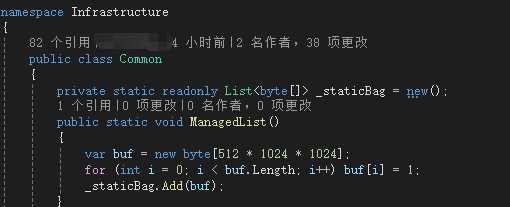

首先我們在Common中添加一個每次運行創建521mb byte[]的函數并用一個static對象“拿住”避免GC回收來模擬內存猛漲不回收的場景

接著在一個每分鐘執行1次的調度作業中插入這個函數調用,來模擬真實的業務中很可能“不注意”引入的元兇

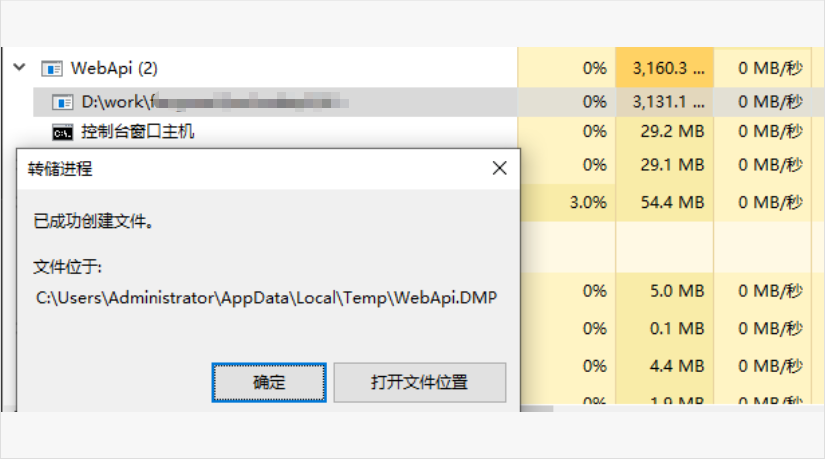

一切準備就緒后,運行代碼,內存很快漲到3G。右鍵進程創建DMP文件

接著就該codex上場了,首先把DMP文件拷貝到你的項目根目錄(方便codex一邊分析dump一邊查代碼確定問題)

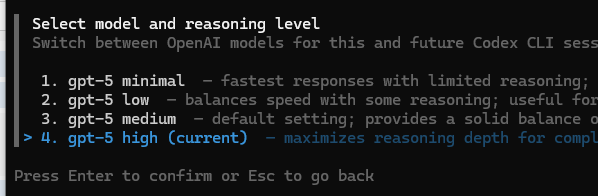

然后在根目錄啟動你的終端,輸入codex進入(安裝過程不再贅述)codex沙盒環境,接著/model選擇gpt-5 high

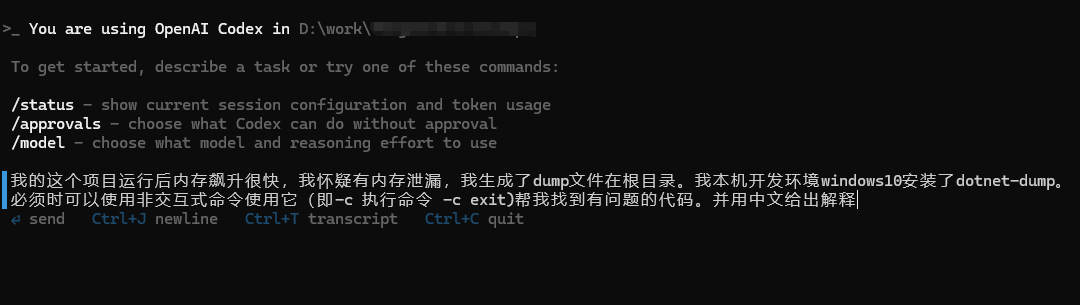

然后輸入你的問題。并告知可用工具(這里我用dotnet-dump,這里有個坑就是必須告知gpt這玩意兒要用-c exit退出,否則它傻不拉幾的進入dotnet-dump的交互式命令后就卡在那了)

然后回車后gpt-5開始列計劃,開始跑任務,用戶這時候只在需要的時候給gpt-5授權操作,過了一會兒。gpt-5就把問題定位到了:

今天的分享就到這里,有探討需求的小伙伴可以在評論區留言

浙公網安備 33010602011771號

浙公網安備 33010602011771號