# 多層感知機模型示例

# Neural Network Overview

#

# <img src="http://cs231n.github.io/assets/nn1/neural_net2.jpeg" alt="nn" style="width: 400px;"/>

#

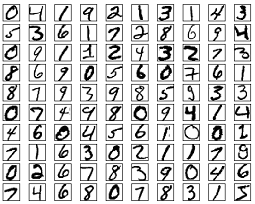

# MNIST Dataset Overview

#

# MNIST圖像數據集使用形如[28,28]的二階數組來表示每張圖像,數組中的每個元素對應一個像素點。該數據集中的圖像都是256階灰度圖,像素值0表示白色(背景),255表示黑色(前景)。由于每張圖像的尺寸都是28x28像素,為了方便連續存儲,我們可以將形如[28,28]的二階數組“攤平”成形如[784]的一階數組。數組中的784個元素共同組成了一個784維的向量。

#

#

#

# More info: http://yann.lecun.com/exdb/mnist/

from __future__ import print_function

# 導入 MNIST 數據集

from tensorflow.examples.tutorials.mnist import input_data

mnist = input_data.read_data_sets("./minist_data/", one_hot=True) #下載minit數據集到minist_data目錄下

import tensorflow as tf

# 超參數

learning_rate = 0.1

num_steps = 500 # 訓練500步

batch_size = 128 # 每步輸入128張圖訓練

display_step = 100

# 神經網絡參數

n_hidden_1 = 256 # 第一層神經元個數

n_hidden_2 = 256 # 第二層神經元個數

num_input = 784 # MNIST 輸入數據(圖像大小: 28*28)

num_classes = 10 # MNIST 手寫體數字類別 (0-9)

# 輸入到數據流圖中的訓練數據

X = tf.placeholder("float", [None, num_input]) # None表示可變長動態數組, batchsize=128 None表示1~128

Y = tf.placeholder("float", [None, num_classes])

# 權重和偏置

weights = {

'h1': tf.Variable(tf.random_normal([num_input, n_hidden_1])),

'h2': tf.Variable(tf.random_normal([n_hidden_1, n_hidden_2])),

'out': tf.Variable(tf.random_normal([n_hidden_2, num_classes]))

}

biases = {

'b1': tf.Variable(tf.random_normal([n_hidden_1])),

'b2': tf.Variable(tf.random_normal([n_hidden_2])),

'out': tf.Variable(tf.random_normal([num_classes]))

}

# 定義神經網絡

def neural_net(x):

# 第一層隱藏層(256個神經元)

layer_1 = tf.add(tf.matmul(x, weights['h1']), biases['b1']) # layer_1=wx+b

# 第二層隱藏層(256個神經元)

layer_2 = tf.add(tf.matmul(layer_1, weights['h2']), biases['b2']) #layer_2=layer_1*x+b

# 輸出層

out_layer = tf.matmul(layer_2, weights['out']) + biases['out']

return out_layer # 128乘10維的數組

# 構建模型

logits = neural_net(X) # x是128 乘784維的數組

# 定義損失函數和優化器

loss_op = tf.reduce_mean(tf.nn.softmax_cross_entropy_with_logits(

logits=logits, labels=Y)) #loss_op就是損失函數, logits是預測值, Y是真實值

optimizer = tf.train.AdamOptimizer(learning_rate=learning_rate) #優化器

train_op = optimizer.minimize(loss_op) #minimize減小loos_op,就是讓預測值和真實值差距越來越小

# 定義預測準確率

correct_pred = tf.equal(tf.argmax(logits, 1), tf.argmax(Y, 1)) #選logits概率最大的,和argmax為1的比較

accuracy = tf.reduce_mean(tf.cast(correct_pred, tf.float32))

init = tf.global_variables_initializer() #初始化所有變量(所有變量賦默認值)

# 開始訓練

with tf.Session() as sess:

# 執行初始化操作

sess.run(init)

for step in range(1, num_steps+1):

batch_x, batch_y = mnist.train.next_batch(batch_size) #逐個batch的取出數據 batch_x是128個圖片.batch_y是128個標簽

# 執行訓練操作,包括前向和后向傳播

sess.run(train_op, feed_dict={X: batch_x, Y: batch_y})

if step % display_step == 0 or step == 1: #每display_step步打印一次

# 計算損失值和準確率

loss, acc = sess.run([loss_op, accuracy], feed_dict={X: batch_x,

Y: batch_y})

print("Step " + str(step) + ", Minibatch Loss= " +"{:.4f}".format(loss) + ", 準確率Training Accuracy= " +"{:.3f}".format(acc))

print("訓練結束Optimization Finished!")

# 計算測試數據的準確率

print("Testing Accuracy測試集準確率:",sess.run(accuracy, feed_dict={X: mnist.test.images,Y: mnist.test.labels}))

浙公網安備 33010602011771號

浙公網安備 33010602011771號