從零開始學Flink:實時流處理實戰

在大數據處理領域,實時流處理正變得越來越重要。Apache Flink作為領先的流處理框架,提供了強大而靈活的API來處理無界數據流。本文將通過經典的SocketWordCount示例,深入探討Flink實時流處理的核心概念和實現方法,幫助你快速掌握Flink流處理的實戰技能。

一、實時流處理概述

1. 流處理的基本概念

流處理是一種持續處理無界數據的計算范式。與批處理不同,流處理系統需要在數據到達時立即處理,而不是等待完整數據集收集完畢。在Flink中,所有數據都被視為流,無論是有界的歷史數據還是無界的實時數據流。

2. Flink流處理的優勢

- 低延遲: 毫秒級的數據處理延遲

- 高吞吐: 能夠處理大規模的數據流量

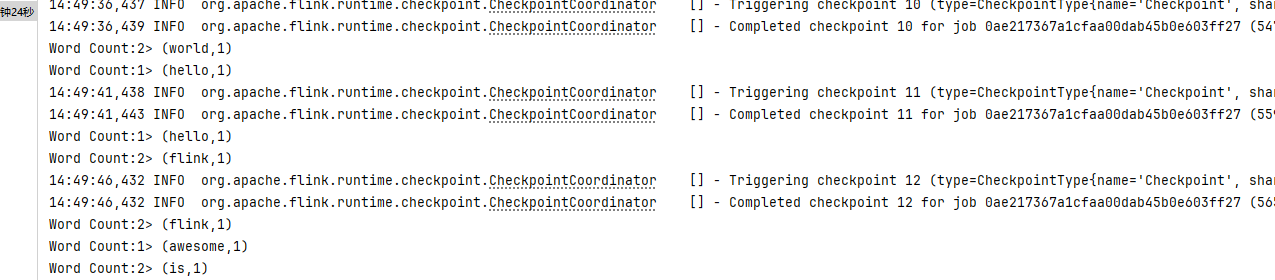

- 精確一次處理: 通過檢查點機制確保數據只被處理一次

- 靈活的時間語義: 支持處理時間、事件時間和攝取時間

- 豐富的狀態管理: 內置多種狀態后端,支持大規模狀態存儲

二、環境準備與依賴配置

1. 版本說明

- Flink:1.20.1

- JDK:17+

- Gradle:8.3+

2. 核心依賴

dependencies {

// Flink核心依賴

implementation 'org.apache.flink:flink_core:1.20.1'

implementation 'org.apache.flink:flink-streaming-java:1.20.1'

implementation 'org.apache.flink:flink-clients:1.20.1'

}

三、SocketWordCount示例詳解

1. 功能介紹

SocketWordCount是Flink中的經典示例,它通過Socket接收實時數據流,對數據流中的單詞進行計數,并將結果實時輸出。這個示例雖然簡單,但包含了Flink流處理的核心要素:數據源連接、數據轉換、并行處理和結果輸出。

2. 完整代碼實現

package com.cn.daimajiangxin.flink;

import org.apache.flink.api.common.eventtime.WatermarkStrategy;

import org.apache.flink.api.common.functions.FlatMapFunction;

import org.apache.flink.api.java.tuple.Tuple2;

import org.apache.flink.streaming.api.datastream.DataStream;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.api.windowing.assigners.TumblingProcessingTimeWindows;

import org.apache.flink.util.Collector;

import java.time.Duration;

public class SocketWordCount {

public static void main(String[] args) throws Exception {

// 1. 創建執行環境

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

// 啟用檢查點,確保容錯性

env.enableCheckpointing(5000); // 每5秒創建一次檢查點

// 設置并行度

env.setParallelism(2);

// 2. 從Socket讀取數據

String hostname = "localhost";

int port = 9999;

// 支持命令行參數傳入

if (args.length > 0) {

hostname = args[0];

}

if (args.length > 1) {

port = Integer.parseInt(args[1]);

}

DataStream<String> text = env.socketTextStream(

hostname,

port,

"\n", // 行分隔符

0); // 最大重試次數

// 3. 數據轉換

DataStream<Tuple2<String, Integer>> wordCounts = text

.flatMap(new Tokenizer())

.keyBy(value -> value.f0)

//添加基于處理時間的滾動窗口計算

.window(TumblingProcessingTimeWindows.of(Duration.ofSeconds(5)))

// 使用sum聚合算子

.sum(1);

// 4. 輸出結果

wordCounts.print("Word Count");

// 5. 啟動作業

env.execute("Socket Word Count");

}

// 可選:使用傳統的FlatMapFunction實現方式

public static final class Tokenizer implements FlatMapFunction<String, Tuple2<String, Integer>> {

private static final long serialVersionUID = 1L;

@Override

public void flatMap(String value, Collector<Tuple2<String, Integer>> out) {

String[] words = value.toLowerCase().split("\\W+");

for (String word : words) {

if (word.length() > 0) {

out.collect(Tuple2.of(word, 1));

}

}

}

}

}

3. 代碼解析

3.1 執行環境創建

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

env.setParallelism(2);

這段代碼創建了Flink的執行環境,并設置了并行度為2。執行環境是所有Flink程序的入口點,它負責管理作業的執行。

3.2 數據源連接

DataStream<String> text = env.socketTextStream(hostname, port);

這里使用socketTextStream方法從Socket連接中讀取文本數據。這是Flink提供的一種內置數據源連接器,適用于測試和演示。

3.3 數據轉換

DataStream<Tuple2<String, Integer>> wordCounts = text

.flatMap(new Tokenizer())

.keyBy(value -> value.f0) // 按單詞分組

.sum(1); // 累加計數

數據轉換包含三個關鍵步驟:

- 分詞: 使用

flatMap操作將每行文本分割成單詞,并為每個單詞生成(word, 1)的元組 - 分組: 使用

keyBy操作按單詞進行分組 - 聚合: 使用

sum操作對每個單詞的計數進行累加

3.4 結果輸出

wordCounts.print("Word Count");

使用print方法將結果輸出到控制臺,這是一種內置的輸出方式,非常適合調試和演示。

3.5 作業啟動

env.execute("Socket Word Count");

最后,調用execute方法啟動作業。注意,Flink程序是惰性執行的,只有調用execute方法才會真正觸發計算。

四、Flink并行流處理機制

1. 并行度概念

并行度是指Flink程序中每個算子可以同時執行的任務數量。在SocketWordCount示例中,我們設置了全局并行度為2,這意味著每個算子都會有2個并行實例。

2. 數據流分區策略

Flink支持多種數據流分區策略,包括:

- Forward Partitioning: 保持數據分區,一個輸入分區對應一個輸出分區

- Shuffle Partitioning: 隨機將數據分發到下游算子的分區

- Rebalance Partitioning: 輪詢將數據分發到下游算子的分區

- Rescale Partitioning: 類似于rebalance,但只在本地節點內輪詢

- Broadcast Partitioning: 將數據廣播到所有下游分區

- Key Group Partitioning: 基于鍵的哈希值確定分區

在SocketWordCount中,keyBy操作使用了Key Group Partitioning策略,確保相同單詞的數據被發送到同一個分區進行處理。

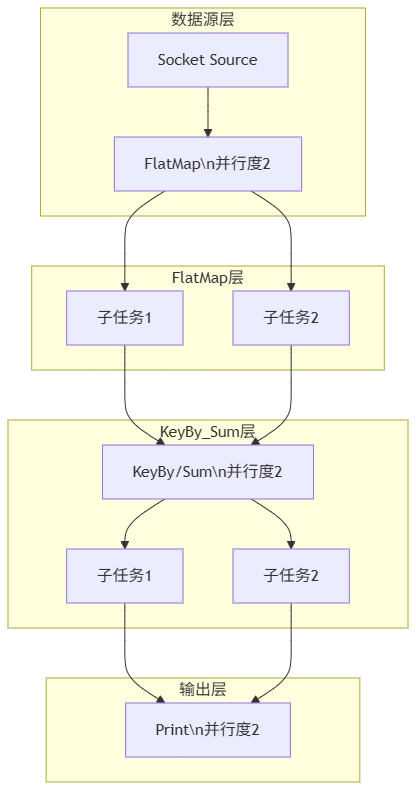

3. 并行執行圖解

這個圖清晰地展示了Flink并行執行的流程,包括:

- Socket數據源連接

- FlatMap操作(并行度為2)及其兩個子任務

- KeyBy/Sum操作(并行度為2)及其兩個子任務

- Print輸出操作(并行度為2)

五、運行SocketWordCount

1. 準備Socket服務器

在運行SocketWordCount程序之前,我們需要先啟動一個Socket服務器作為數據源。以下是幾種常用的Socket服務器搭建方法:

1.1 使用netcat工具

Linux/Mac系統:

nc -lk 9999

參數說明:

- -l: 表示監聽模式,等待連接

- -k: 表示保持連接,允許接受多個連接(對持續測試很有用)

- 9999: 端口號

Windows系統:

Windows有幾種獲取netcat的方式:

-

如果安裝了Git,可以使用Git Bash:

nc -l -p 9999 -

如果安裝了Windows Subsystem for Linux (WSL):

nc -lk 9999

參數說明:

- -l: 表示監聽模式,等待連接

- -k: 表示保持連接,允許接受多個連接(對持續測試很有用)

- 9999: 端口號

1.2 使用Java實現Socket服務端

如果你想使用Java代碼來創建一個更可控的Socket服務器,可以參考以下示例:

import java.io.BufferedReader;

import java.io.IOException;

import java.io.InputStreamReader;

import java.io.PrintWriter;

import java.net.ServerSocket;

import java.net.Socket;

public class SimpleSocketServer {

public static void main(String[] args) {

int port = 9999;

try (ServerSocket serverSocket = new ServerSocket(port)) {

System.out.println("Socket服務器已啟動,監聽端口: " + port);

while (true) {

try (Socket clientSocket = serverSocket.accept();

PrintWriter out = new PrintWriter(clientSocket.getOutputStream(), true);

BufferedReader in = new BufferedReader(new InputStreamReader(System.in))) {

System.out.println("客戶端已連接,輸入要發送的數據(輸入'exit'退出):");

String inputLine;

while ((inputLine = in.readLine()) != null) {

if (inputLine.equalsIgnoreCase("exit")) {

break;

}

out.println(inputLine);

}

} catch (IOException e) {

System.err.println("客戶端連接異常: " + e.getMessage());

}

}

} catch (IOException e) {

System.err.println("無法啟動服務器: " + e.getMessage());

}

}

}

這個Java實現的Socket服務器具有以下特點:

- 啟動后持續監聽9999端口

- 接受客戶端連接并允許發送數據

- 支持通過輸入'exit'退出當前客戶端連接

- 異常處理更加完善

1.3 測試Socket連接

在啟動Socket服務器后,你可以使用以下方法測試連接是否正常:

-

使用telnet客戶端測試:

telnet localhost 9999 -

使用netcat作為客戶端測試:

nc localhost 9999

1.4 常見問題與解決方法

-

端口被占用:

- 錯誤信息:

Address already in use或類似提示 - 解決方法:更換端口號,或使用

lsof -i :9999(Linux/Mac)查找占用端口的進程

- 錯誤信息:

-

防火墻阻止:

- 癥狀:服務器啟動但客戶端無法連接

- 解決方法:檢查系統防火墻設置,確保端口9999已開放

-

權限問題(Linux/Mac):

- 癥狀:普通用戶無法綁定低端口(<1024)

- 解決方法:使用sudo權限或選擇1024以上的端口

-

Windows特殊情況:

- 如果nc命令不可用,可以使用上述PowerShell腳本或安裝第三方netcat工具

- 確保Windows Defender防火墻允許連接

六、高級特性擴展

1. 添加窗口計算

添加基于處理時間的滾動窗口計算:

import org.apache.flink.api.common.typeinfo.Types;

import org.apache.flink.streaming.api.windowing.assigners.TumblingProcessingTimeWindows;

DataStream<Tuple2<String, Integer>> wordCounts = text

.flatMap(new Tokenizer())

.keyBy(value -> value.f0)

.window(TumblingProcessingTimeWindows.of(Duration.ofSeconds(5)))

.sum(1);

七、常見問題與解決方案

1. 連接被拒絕錯誤

問題:程序拋出Connection refused錯誤。

解決方案:確保Socket服務器已啟動,并且監聽在正確的端口上。

2. 結果不符合預期

問題:輸出的單詞計數結果不符合預期。

解決方案:檢查分詞邏輯是否正確,確保單詞的大小寫處理和分隔符使用得當。

3. 性能問題

問題:程序處理速度較慢。

解決方案:調整并行度,增加資源配置,或優化數據轉換邏輯。

八、最佳實踐

1. 生產環境配置

- 設置合適的并行度:根據集群資源和任務特性設置并行度

- 啟用檢查點:對于生產環境,啟用檢查點機制確保容錯性

- 配置狀態后端:根據數據量大小選擇合適的狀態后端

2. 代碼優化建議

- 避免使用全局變量:確保函數是無狀態的或正確管理狀態

- 合理設置并行度:避免過度并行化導致的資源浪費

九、總結與展望

SocketWordCount雖然是一個簡單的示例,但它涵蓋了Flink流處理的核心概念和基本流程。通過這個示例,我們學習了如何創建Flink執行環境、連接數據源、進行數據轉換、設置并行處理以及輸出結果。

在實際應用中,Flink可以處理更復雜的流處理場景,如實時數據分析、欺詐檢測、推薦系統等。后續我們還將深入學習Flink的窗口計算、狀態管理、Flink SQL等高級特性,幫助你構建更強大的實時數據處理應用。

通過本文的學習,相信你已經對Flink實時流處理有了更深入的理解。實踐是掌握技術的最好方法,不妨嘗試修改SocketWordCount示例,添加更多功能,如窗口計算、狀態管理等,進一步提升你的Flink技能!

本文以Apache Flink實時流處理為核心,通過SocketWordCount示例,系統講解實時流處理基礎概念、Flink優勢、代碼實現與并行處理機制,助力讀者掌握Flink流處理實戰技能。

本文以Apache Flink實時流處理為核心,通過SocketWordCount示例,系統講解實時流處理基礎概念、Flink優勢、代碼實現與并行處理機制,助力讀者掌握Flink流處理實戰技能。

浙公網安備 33010602011771號

浙公網安備 33010602011771號