推薦系統——預訓練論文解讀

AAAI-2022 ——《TS2Vec: Towards Universal Representation of Time Series》

paper地址:https://arxiv.org/pdf/2308.01737

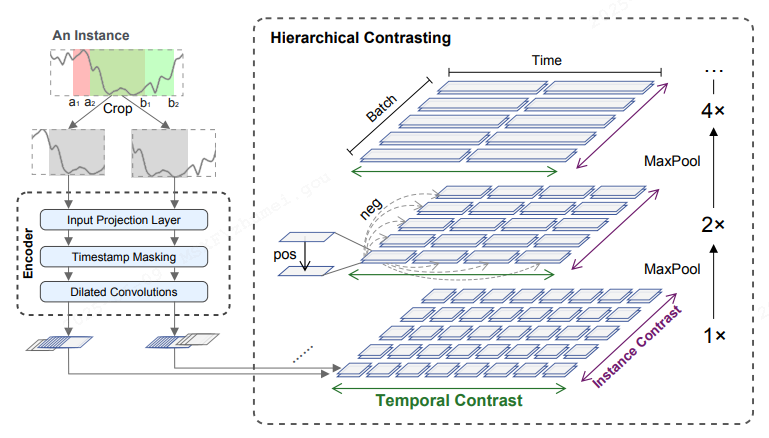

highlights:一種與模型無關的時序表征學習的預訓練框架,利用對比學習范式的encoder框架來進行自監督學習。屬于前置任務預訓練,下游接預測任務。該框架主要包含:

-

數據構造:構造兩段長度相等的隨機序列:對于每個實例 xi,隨機抽取兩個重疊的時間片段 [a1, b1]、[a2, b2],使得 0 < a1 ≤ a2 ≤ b1 ≤ b2 ≤ T。

-

encoder設計:編碼器由三個組件組成,一個輸入投影層(input projection layer)、時間戳Mask模塊(timestamp masking )和一個空洞卷積層(dilated CNN)

-

對比損失:從兩個維度刻畫,一是時間層面的對比,二是實例維度的對比

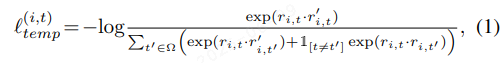

Temporal Contrastive Loss (時間對比損失)

用于計算同一實例在不同時間點的對比損失,強化時間上的表征差異。令 i 為輸入時間序列樣本的索引, t 為時間戳。 計算相同時間戳 t 下,正樣本對為樣本 xi 的兩個增強的context表示。時間對比損失旨在挖掘動態隨時間變化的趨勢:

Instance-wise Contrastive Loss (實例對比損失)

計算同一時間點不同實例間的對比損失,確保相似的表示被拉近,不同的表示被推遠。可以學習到用戶特定的特征:

KDD'23——MAP: A Model-agnostic Pretraining Framework for Click-through Rate

paper地址:https://arxiv.org/pdf/2308.01737

highlights:一種與模型無關的預訓練MAP框架,利用特征損壞和恢復來進行自監督學習。屬于前置任務預訓練ctr模型,然后用預測目標微調。該框架主要包含兩種算法:

-

掩碼特征預測(MFP):通過mask和預測一小部分的輸入特征來研究每個實例中特征的交互,并引入噪聲對比估計(NCE)來處理大型特征空間

-

替換特征檢測(RFD):通過替換和檢測輸入特征的變化,進一步將MFP轉變為二分類任務。

MFP

-

對于F個特征的樣本,用隨機替換部分特征,得到損壞的樣本。要mask的特征比例是由超參數γ控制。

-

傳入emb層,所有field用的的emb是一樣的。

-

經過特征交互層之后,得到表征。對于第f個field的每個mask特征,構造一個獨立的MLP,然后用softmax函數來計算候選特征上的預測概率。

-

每個masked field的預測空間(即候選特征)都被擴展到全局特征空間,以增加前置預訓練任務的難度,模型必須從整個特征空間中選擇原始特征,然后將MFP預訓練視為一個多類分類問題,并利用多類交叉熵損失進行優化

-

采用噪聲對比估計(NCE)來降低softmax開銷

RFD

-

檢測所有field中哪些字段是被更改了

-

隨機破環部分字段形成mask特征

-

類似MFP中的emb和交互層,預測是否被替換過

AAAI 2024 ——TimesURL: Self-supervised Contrastive Learning for Universal Time Series Representation Learning

paper地址:https://arxiv.org/pdf/2312.15709

code:https://github.com/Alrash/TimesURL

highlights:和TS2Vec類似,針對用于時間序列表示的對比學習提出了TimesURL,用于捕捉時段級和實例級信息,通過額外的時間重構模塊實現通用表示。(在TS2Vec的基礎上做了以下三點升級)

-

樣本增強:引入了一種基于頻域-時間的混合增強方法。

-

在對比學習中注入了新的雙重 Universums(一種通過 混合正負樣本特征 生成的 難負樣本),以解決正負對構建問題,增強對比學習效果。

-

通過隨機mask引入了一種時間重構模塊(和MAP類似)。

FTAug 方法

優勢在于保持了上下文一致性策略,該策略將兩個增強上下文中同一時間戳的表征視為正對

-

混頻:通過快速傅立葉變換計算出xi 中的頻率成分的一定比率替換為同一批次中另一個隨機訓練實例 xk 的相同頻率成分,從而生成新的上下文視圖。然后使用反向 FFT 轉換,得到一個新的時域時間序列。在樣本之間交換頻率成分不會引入意外噪聲或人為周期性,可以提供更可靠的增強功能,以保留數據的語義特征。

-

隨機裁剪:對于每個實例 xi,隨機抽取兩個重疊的時間片段 [a1, b1]、[a2, b2],使得 0 < a1 ≤ a2 ≤ b1 ≤ b2 ≤ T。

雙重Universums學習

硬負樣本(硬負樣本是模型難以正確分類的負樣本,通常與正樣本在特征空間中非常接近,訓練過程中特別關注這些樣本,可以使模型更好地泛化到新數據)在對比學習中發揮著重要作用,由于時間序列的局部平滑性和馬爾可夫特性,大多數負樣本都是易負樣本(易負樣本是模型可以輕易正確分類的負樣本,與正樣本在特征空間中有著明顯的區別),不足以捕捉時間信息,因為它們從根本上缺乏驅動對比學習所需的學習信號。這些易負樣本片段往往與錨點(錨點是用作參考點,與正負樣本一起使用,來訓練模型學習區分不同類別或實體,比如一個場景:模型的目標是將錨點與正樣本之間的距離最小化,同時將錨點與負樣本之間的距離最大化,從而學會區分不同的對象或類別)表現出語義上的不相似性,而且只貢獻了很小的梯度。

提出的雙重Universums在實例和時間上都是混合誘導Universums,它是嵌入空間中特定于錨的混合,將特定的正向特征(錨)與未標注數據集的負向特征混合在一起:

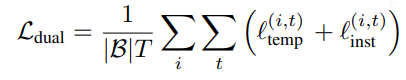

對比損失

最后采用了多尺度信息學習,方法是對公式(3)和(4)中沿時間軸學習到的表征進行最大池化處理。作者指出重要的時間變化信息,如趨勢和季節性信息,會在多次最大池化操作后丟失,因此高層對比實際上無法為下游任務捕捉到足夠的實例級信息。

實例級信息的時間重構

根據部分觀察結果重建原始信號的思想。設計了一種重構模塊,以保留重要的時變信息。使用隨機掩碼策略,計算每個時間戳上重建值與原始值之間的均方誤差(MSE)。

最終的聯合loss:

(代碼里面,這里的Ldual權重只有0.01,而mse的權重為1,難道Ldual的重要度很低?)

實驗:

浙公網安備 33010602011771號

浙公網安備 33010602011771號