函數計算支持熱門 MCP Server 一鍵部署

全球 AI 開發者們熱議“MCP”(Model Context Protocol)。盡管這一協議在2024年由Anthropic發布時并未引起廣泛關注,但2025年初,Cursor宣布集成MCP迅速將其帶入開發者的視野,3月Manus的爆發更是加速了MCP的普及。而就在3月27日,OpenAI正式宣布其Agent SDK全面支持MCP協議,這一舉措標志著MCP將會成為該領域的實施標準,必將重塑AI應用的開發與交互方式。

目前,社區的MCP Server大多采用本地STDIO模式部署,盡管這種模式能支持基本模型服務和工具的數據交互,簡單測試尚可,但在涉及具體的開發,調試,由于IO重定向帶來不同程度的開發復雜度;同時隨著AI場景的日益豐富,一方面數據訪問不再僅限于本地,另一方面業務對于架構可靠性要求,基于本地部署的 MCP Server 勢必無法滿足復雜的生產需求。因此,云上托管的MCP Server將成為未來的主流趨勢。函數計算(FC)目前已支持一鍵托管開源的MCP Server,歡迎大家前來體驗。

為什么云上托管 MCP Server 是趨勢?

- 吸引更多開發者參與MCP生態建設

MCP協議成為事實標準后,開發者無需為每個Function編寫復雜的JSON Schema參數說明,這大大降低了重復開發的工作量。通過開源或第三方的MCP Server,開發者能夠迅速共享和復用資源。例如,Blender-MCP項目允許用戶通過MCP協議將自然語言指令轉化為三維建模操作,項目開源一周便獲得了5.4k stars。

- SaaS服務商擁抱MCP Server

隨著MCP的普及,SaaS服務商可以通過集成MCP Server觸達新的市場和行業機會,而MCP協議的Stdio和SSE標準要求服務和數據供應商提供API訪問,而云上托管將是最優選擇。

- 企業級 MCP Server 要求安全合規和彈性伸縮

MCP Server 將服務/數據對接給大模型,如果不限制大模型的數據權限范圍和敏感數據過濾,將對企業產生安全合規風險,云上托管提供權限管控、操作審計、用戶隱私保護等內置安全工具,大幅減少安全風險暴露面,合規成本低。同時 MCP Server 的爆火,對服務商是巨大的機會,服務商將面臨著用戶量和模型調用量的突增,云上托管如函數計算具備免運維、自動彈性、自動容災的優勢,確保服務體驗的同時實現降本增效。

云上托管 MCP Server 核心痛點

- 傳統托管效率低

從 MCP 架構的描述中可以看到,MCP Server 作為 AI 大模型和企業服務的中間層,通過購買傳統云資源部署效率低下,其代碼通常相對輕量,開發者需要快速部署,快速測試僅僅可能是一條NPX命令。 "MCP Servers: Lightweight programs that each expose specific capabilities through the standardized Model Context Protocol"。

- 業務規模不確定

作為原有 Function Calling 的替代者,工具調用請求規模具有顯著的不確定性,傳統云資源托管需要長期持有資源,資源供給無法實現按業務流量進行靈活的動態適配。

- 定制擴展流程復雜

MCP Server 作為AI和企業服務能力的中間層,其邏輯覆蓋簡單路由到復雜計算,隨著業務場景的豐富會變得越發復雜,務必在選擇云上托管的時候,也要考慮后續業務的開發和維護效率。 務必要求開發層面需要更靈活的定制能力,實現快速變更,快速上線,靈活的版本和流量管理。

- 數據訪問網絡配置復雜

傳統MCP Server依賴于本地化部署實現數據安全,隨著云端部署的普遍化,云端 MCP Server 不僅需要能夠實時安全的訪問企業私有數據,也需要適配復雜的業務環境,在Internet和Intranet網絡之間進行互通,這就要求能夠快速的互聯網公共服務和企業云上 VPC 快速打通,提供安全靈活的執行環境。

函數計算成為云上托管 MCP Server 的最簡方式

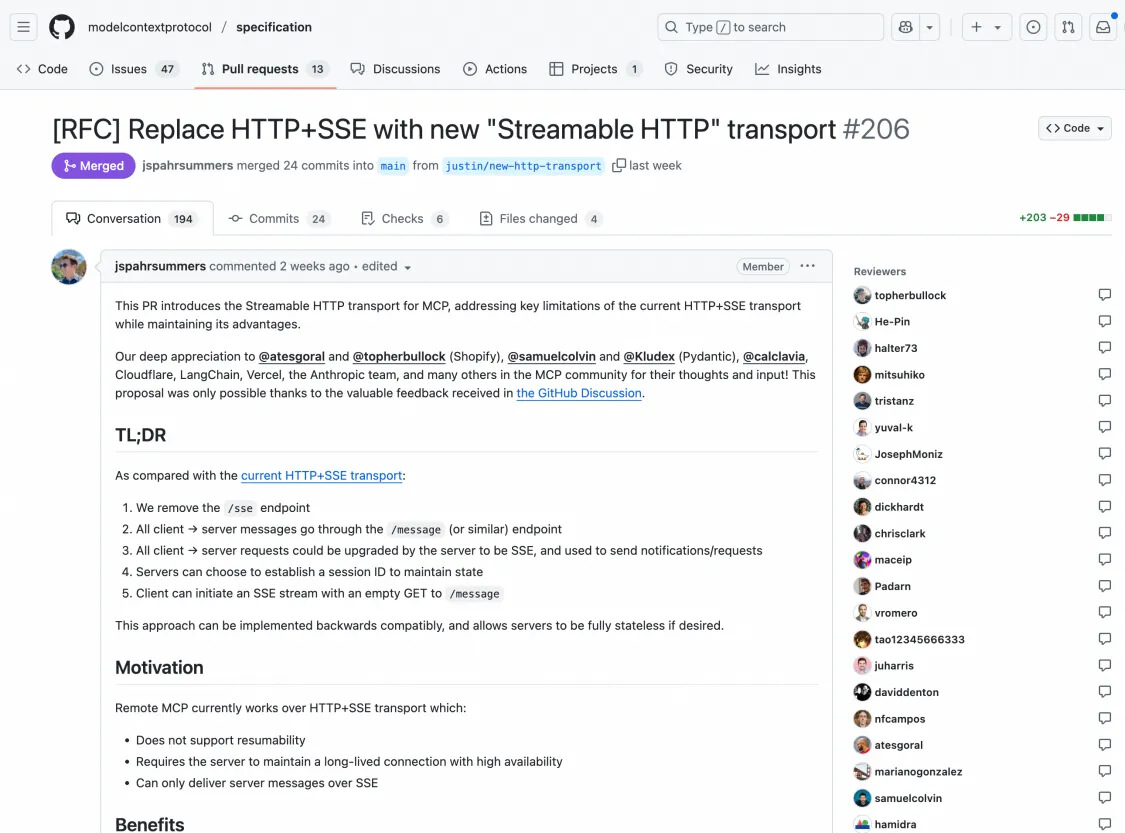

社區積極的推動 MCP 協議演進,推動 Steamable HTTP transport 技術代替原有 HTTP+SSE 的通信方式,原有的 MCP 傳輸方式就像是你和客服通話時必須一直保持在線(SSE 需要長連接),而新的方式更像是你隨時可以發消息,然后等回復(普通 HTTP 請求,但可以流式傳輸)。這種形式與 Serverless 算力無狀態模式更加契合,協議層演進將更有利于云上Serverless算力的價值放大,隨著AI模型復雜度和數據規模持續增長,Serverless與MCP Server的結合將成為趨勢。

https://github.com/modelcontextprotocol/specification/pull/206

函數計算作為云上Serverless 算力的典型代表,其憑借在開發效率,按需付費,極致彈性等產品能力直擊云上 MCP Server 托管的核心痛點,為企業MCP Server 提供高效,靈活,匹配業務規模的托管能力。

- 成本效益最大化

- 按需付費,避免資源浪費:Serverless按實際計算資源消耗計費,而非固定服務器租賃費用,尤其適合AI訓練和推理任務中常見的波動性負載。

- 消除閑置成本:AI模型訓練通常需要突發性算力,Serverless能自動分配資源,避免傳統模式下預留資源導致的服務器空置問題。

- 彈性擴展與資源優化

- 動態資源分配:將MCP Server 托管在函數計算上,基于Serverless架構,可實時響應AI任務需求,自動擴展CPU/GPU,確保算力高并發處理能力。

- 多模型協作支持:支持多個AI項目并行運行,資源按優先級動態調度,提升整體算力利用率。

- 簡化運維與加速開發

- 無服務器管理:開發者無需關注服務器配置、補丁更新或集群管理,專注算法優化和迭代MCP Server 內部邏輯和工具豐富度。

- 開箱即用的工具鏈:函數計算提供了完善的工具鏈能力,基于開源 Serverless Devs開源工具實現本地快速部署。

- 更靈活的MCP協議適配

- 當前函數計算提供單實例多并發能力,擴展對存量SSE協議的適配,基于社區提供的MCP Proxy方案能夠快速將存量本地MCP Server托管到云端,方便業務平臺的測試開發。

- 提供基于WebSocket 的MCP協議適配參考實現,支持單實例單并發和單實例多并發能力支持,提升協議適配和場景適配;同時團隊緊跟社區 Streamable HTTP 方案,敬請期待!

體驗:一鍵部署熱門 MCP Server

依賴 Serverless 應用開發平臺 CAP,我們能夠快速實現開源 MCP Server 一鍵托管,假如您搭建的 AI Agent 中需要加入導航服務,您可能會需要高德社區提供的 MCP Server ,接下來我們將以開源項目 amap-maps-mcp-server 為例演示如何一鍵部署 MCP Server 到函數計算FC上。

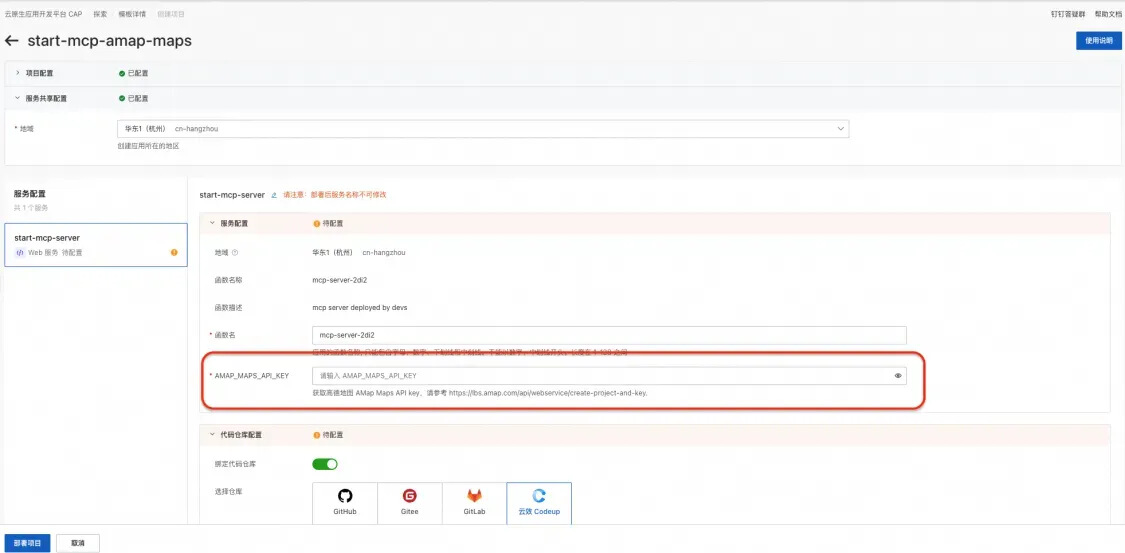

第一步: 模版部署

點擊 https://cap.console.aliyun.com/create-project?template=start-mcp-amap-maps 進入CAP控制臺。填入從高德開發者申請的 Token(立刻申請完成),可以在這里申請。

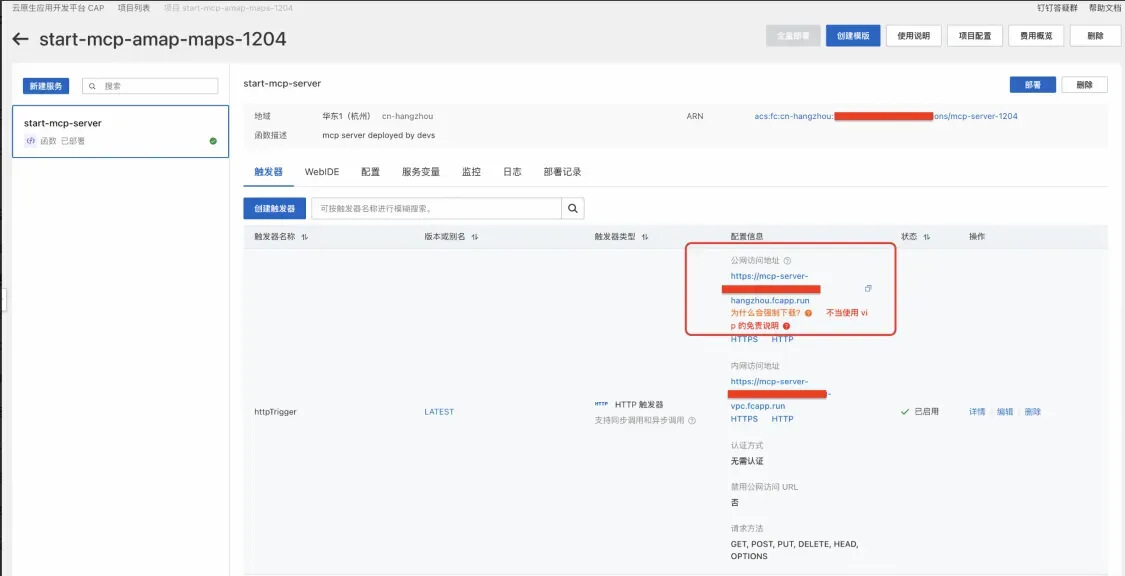

第二步: 測試 MCP Server 提供的工具能力

部署成功之后,通過觸發器頁面,拿到測試URL可對當前MCP Server進行測試。如果希望將部署的MCP Server 用于生產,建議使用自定義域名代替測試URL。

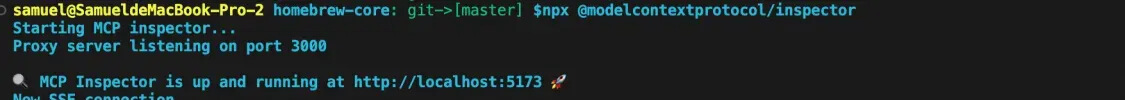

測試步驟一:本地終端運行命令: npx @modelcontextprotocol/inspector

測試步驟二:瀏覽器中打開本地提供的測試地址“http://localhost:5173/#tools ”進行測試,在URL表單中填入上面獲取的URL,添加/sse 后綴填入URL表單中,點擊Connect會看到開源 MCP Server提供的Tools列表,可以點擊置頂Tool進行交互驗證。

如果您對于產品有更多建議或者對 MCP server 云端托管有更多想法可以加入釘釘群(群號:64970014484)與我們取得聯系。

更多開源 MCP Server一鍵部署

更多內容關注 Serverless 微信公眾號(ID:serverlessdevs),匯集 Serverless 技術最全內容,定期舉辦 Serverless 活動、直播,用戶最佳實踐。

浙公網安備 33010602011771號

浙公網安備 33010602011771號