Dropout函數(shù)

什么是dropout?

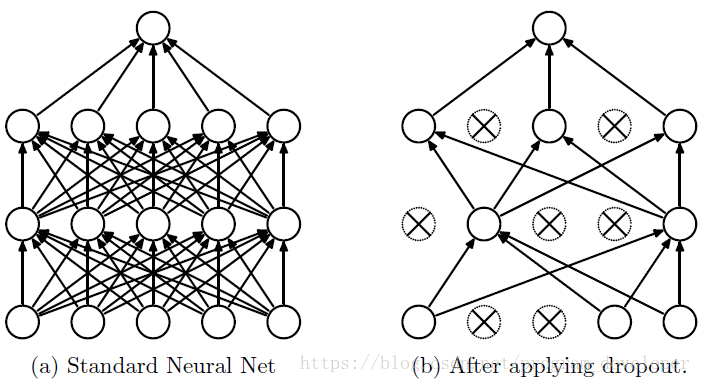

在機(jī)器學(xué)習(xí)的模型中,如果模型的參數(shù)太多,而訓(xùn)練樣本又太少,訓(xùn)練出來的模型很容易產(chǎn)生過擬合的現(xiàn)象。在訓(xùn)練神經(jīng)網(wǎng)絡(luò)的時(shí)候經(jīng)常會(huì)遇到過擬合的問題,過擬合具體表現(xiàn)在:模型在訓(xùn)練數(shù)據(jù)上損失函數(shù)較小,預(yù)測(cè)準(zhǔn)確率較高;但是在測(cè)試數(shù)據(jù)上損失函數(shù)比較大,預(yù)測(cè)準(zhǔn)確率較低。深度學(xué)習(xí)中在代碼中經(jīng)常碰到的dropout函數(shù)是指我們?cè)谟?xùn)練神經(jīng)網(wǎng)絡(luò)的過程中,隨機(jī)丟棄一部分神經(jīng)網(wǎng)絡(luò)單元,只是暫時(shí)移除訓(xùn)練過程。即在前向傳播的時(shí)候,讓某個(gè)神經(jīng)元的激活值以一定的概率p停止工作,這樣可以使模型泛化性更強(qiáng),因?yàn)樗粫?huì)太依賴某些局部的特征

相當(dāng)于以一定的概率減少訓(xùn)練過程中神經(jīng)網(wǎng)絡(luò)的數(shù)量,從而也使得訓(xùn)練的負(fù)荷減少,提高訓(xùn)練的速度

dropout的作用

有效的防止過擬合,大型的神經(jīng)網(wǎng)絡(luò)在小的數(shù)據(jù)集上訓(xùn)練時(shí)會(huì)導(dǎo)致過擬合

詳細(xì)解釋參考:http://pan.baidu.com/s/1c0Ri2Py

http://www.rzrgm.cn/liaohuiqiang/p/9194699.html

浙公網(wǎng)安備 33010602011771號(hào)

浙公網(wǎng)安備 33010602011771號(hào)