【深度學習】|01復旦大學邱錫鵬《神經網絡與深度學習》學習小筆記(三)前饋+卷積+循環

前饋網絡/全連接/多層感知機/有向無環圖;

常見激活函數;

并行;

前饋神經網絡;

計算梯度的方法;

靜態/動態計算圖;

卷積網絡;

不同卷積核提取不同特征;

經典卷積結構;

循環網絡;

RNN入門;

經典結構;

一、前饋網絡

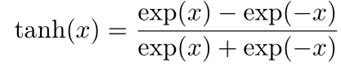

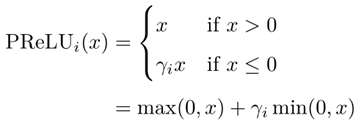

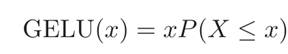

(1)常見激活函數【前面是表達式,后面是評論】

【非0中心化,并且是指數形式】

非零中心化的輸出會使得其后一層的神經元的輸入發生偏置偏移(bias shift),并進一步使得梯度下降的收斂速度變慢(作為乘積傳入的)。

中心化在0,但是有負數

計算上更加高效,單側抑制、寬興奮邊界,在一定程度上緩解梯度消失問題,有些神經元可能永遠不會被激活

![]()

其中P(X ≤ x)是高斯分布N(μ,σ 2 )的累積分布函數,其中μ,σ為超參數,一般設μ = 0,σ = 1即可

(2)并行計算的含義

從基本的并行化原理上來講,分布式深度學習分為數據并行(Data Parallelism)以及模型并行(Model Parallelism)。

數據并行:指每個設備有神經網絡模型的完整拷貝并獨立處理其輸入數據流、每次迭代后將更新歸并到參數服務器(Parameter Server)上;

模型并行:指每個設備有模型的一部分參數、多個設備共同來處理一條輸入數據流并更新各自部分的模型參數。

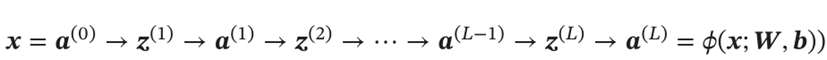

(3)前饋神經網絡

1.計算方式:

2.前饋計算:

只要其隱藏層神經元的數量足夠,它可以以任意的精度來近似任何從一個定義在實數空間中的有界閉集函數。【通用近似定理】可以逼近一個復雜的條件分布;

(4)計算梯度的方法

a.視為復合函數運用鏈式法則

b.反向傳播算法

c.自動微分

利用鏈式法則來自動計算一個復合函數的梯度,有前向模式和反向模式;反向模式和反向傳播相同;

前向傳播就是新建h1,h2,...,hn來存儲h的梯度的累積值

反向傳播可以分為以下三步

前向計算每一層的狀態和激活值,直到最后一層

反向計算每一層的參數的偏導數

更新參數

(5)靜態計算圖和動態計算圖

tensorflow這樣提前定義好圖,不定義完不能跑的——靜態計算圖

pytorch這樣跑一步看一步的——動態計算圖

靜態計算圖在構建時可以進行優化,并行能力強,但靈活性比較差低。

動態計算圖則不容易優化,當不同輸入的網絡結構不一致時,難以并行計算,但是靈活性比較高。

二、卷積神經網絡——提取局部不變特性

局部連接,權值共享,時間或空間上的次采樣

(1)不同卷積核提取不同類型特征

(a)提取的是低頻信息,因為沒有新波段的時候variance很低;

(b)提取的是高頻信息,因為對舊波段也會產生更大的variance

窄卷積:步長 ?? = 1 ,兩端不補零 ?? = 0 ,卷積后輸出長度為 ?? ? ?? + 1

寬卷積:步長 ?? = 1 ,兩端補零 ?? = ?? ? 1 ,卷積后輸出長度 ?? + ?? ? 1

等寬卷積:步長 ?? = 1 ,兩端補零 ?? =(?? ? 1)/2 ,卷積后輸出長度 ??

卷積層雖然可以顯著減少連接的個數,但是每一個特征映射的神經元個數并沒有顯著減少。

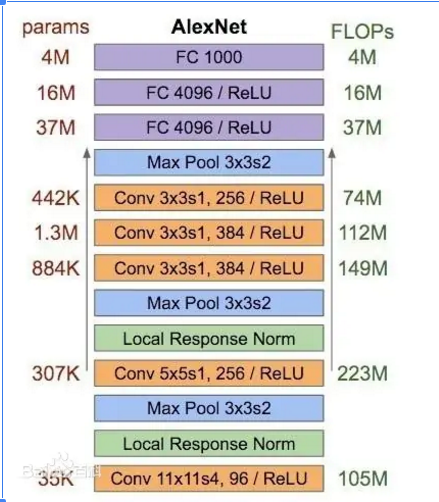

(2)經典卷積

(a)LeNet: 三套卷積+relu+池化,再來三個全連接;

(b)AlexNet:分到兩塊去計算

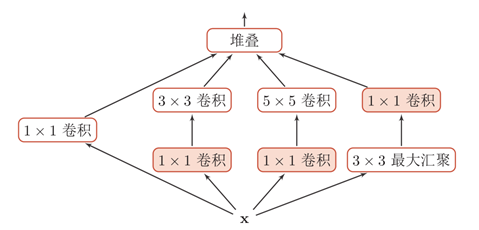

(3)Inception v1: 1 1-3 1-5 3-1

其中的1*1 卷積:

對于single channel而言就相當于對原特征的scala操作;

multi-channel可以根據自己的需要定義卷積核的個數,從而進行降(升)維。

如果將它看作cross channel的pooling 操作,還能得到在同一位置不同通道之間進行特征的aggregation。

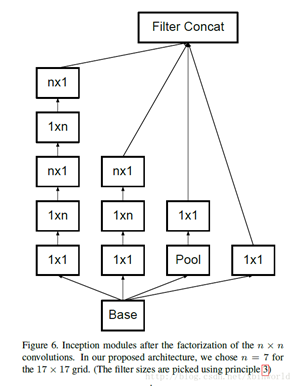

(4)Inception v3:

兩個3*3替代一個5*5,減少參數量;同理用n*1和1*n來替代n*n

2*3*3=18

5*5=25

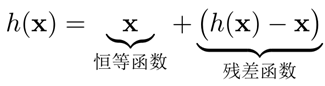

(5)殘差網絡:

殘差網絡中卷積部分擬合的是殘差h(x)-x,模型向前運算只會更好不會更壞

三、循環網絡---處理變長序列

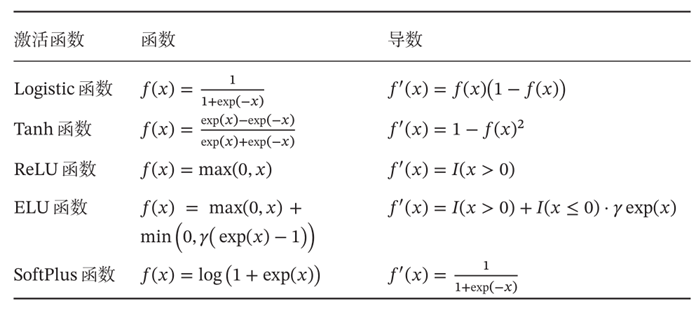

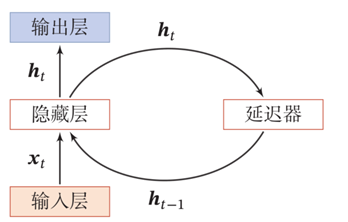

(1)RNN入門

給網絡增加記憶能力——時間序列模型

一個RNN:

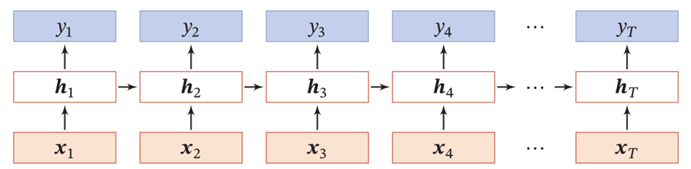

展開如下,需要看的是一個方塊被哪些箭頭指著,代表了這個方塊的輸入是什么,方塊上的值就是輸出;

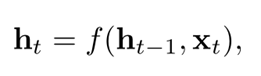

公式:

![]()

由于梯度爆炸或消失問題,實際上只能學習到短周期的依賴關系。這就是所謂的長程依賴問題。【跟梯度的表達式有關】

【梯度爆炸】權重衰減,梯度截斷

【梯度消失】改進模型

改成線性依賴:(不用像上面那樣經過f非線性)

增加非線性 ![]()

![]()

(2)經典的循環神經網絡(衍生遞歸神經網絡等)

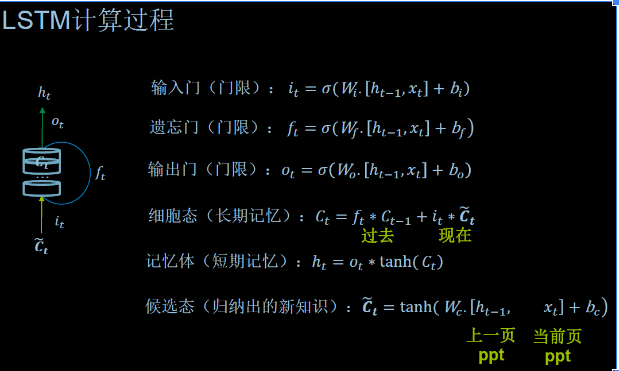

a. LSTM: 這里的f,i,o都有“w”權重的意味,所以被稱為門控。有變體讓f+i==1

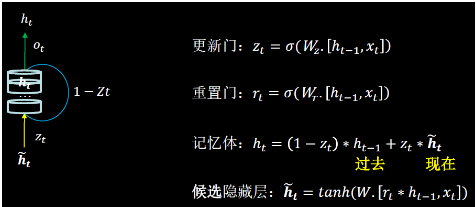

b. GRU :

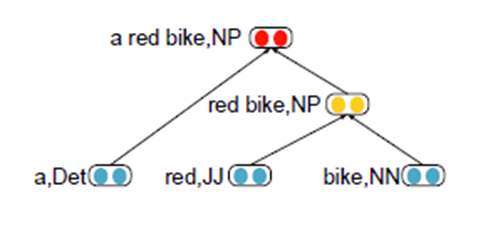

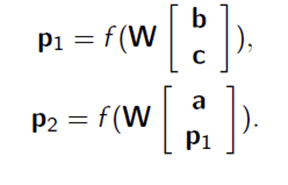

c. 遞歸神經網絡

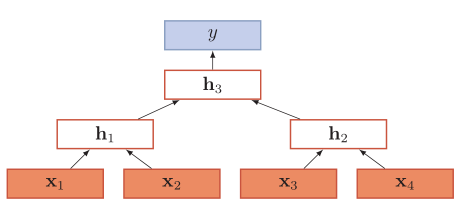

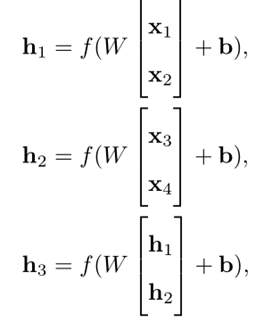

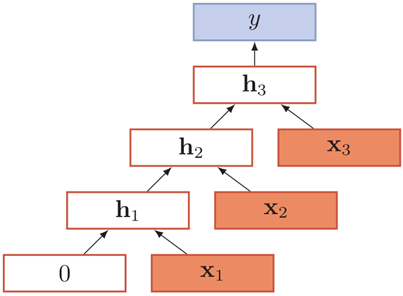

遞歸神經網絡是在一個有向圖無循環圖上共享一個組合函數

退化成循環神經網絡:

給定一個語法樹,

p2 → ap1,

p1 → bc.

浙公網安備 33010602011771號

浙公網安備 33010602011771號