Rethinking Transformer for Long Contextual Histopathology Whole Slide Image Analysis

Rethinking Transformer for Long Contextual Histopathology Whole Slide Image Analysis

LongMIL:構(gòu)建高秩且稀疏的掩碼,從而減少自注意力的計算復(fù)雜度

動機

病理圖片WSI分析可以看作一個長序列問題。

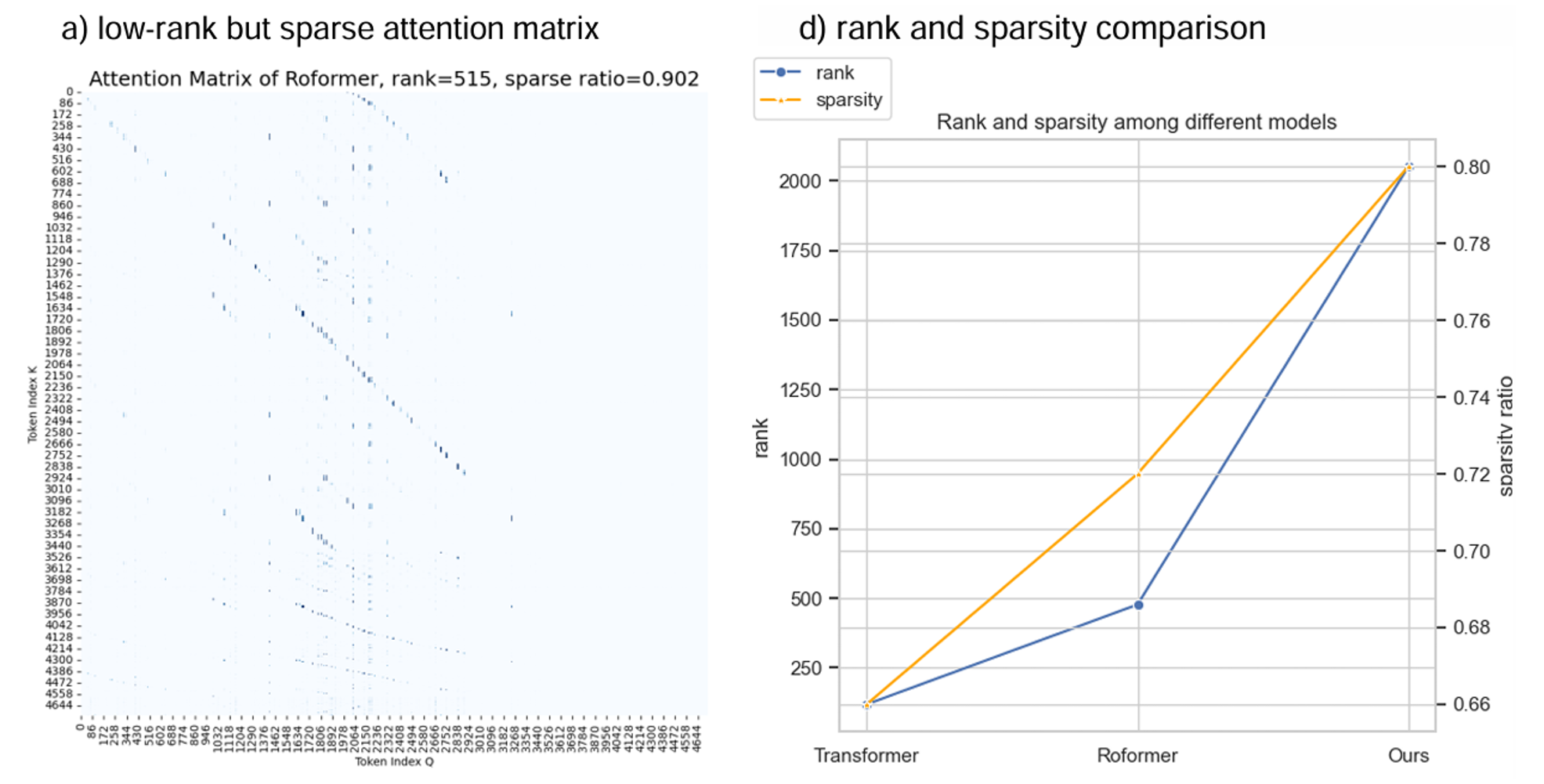

當序列長度遠大于特征長度時(\(n \gg d\)),transformer的淺層注意力更關(guān)注局部的上下文,而深層注意力更關(guān)注全局。然而,注意力矩陣的秩依然小,使得全局與局部層面的注意力交互混亂。\(2dn\)的點難以建模\(n\times n\)的關(guān)系。

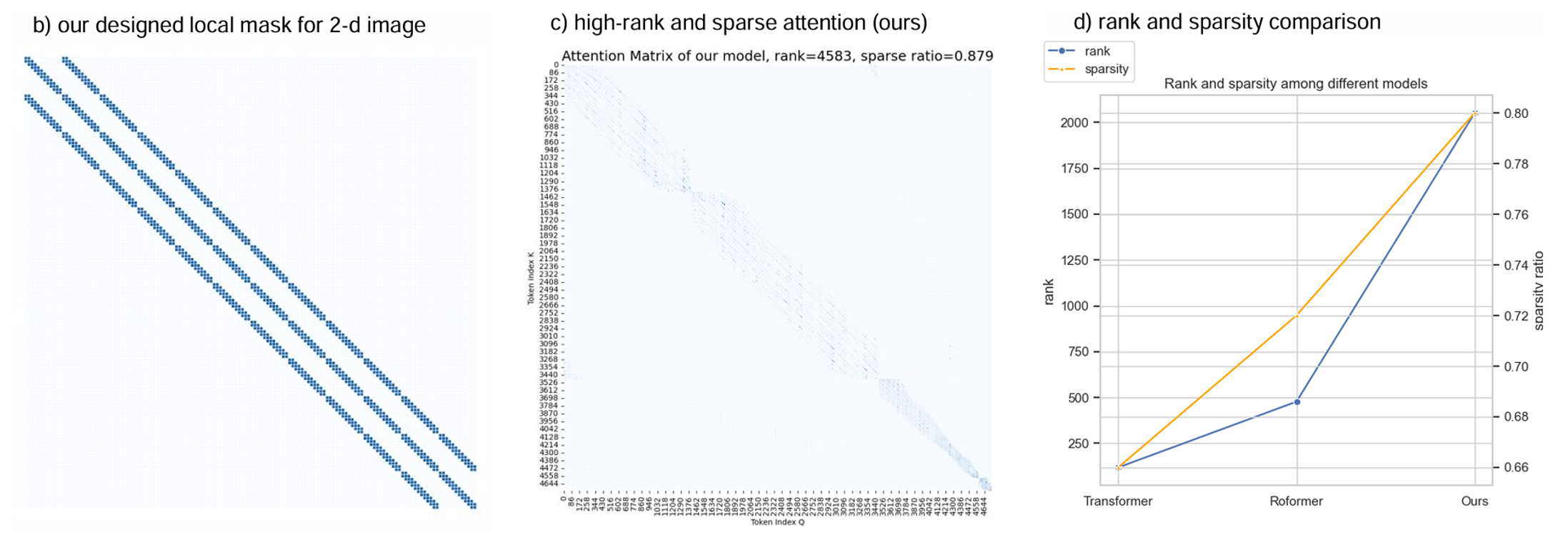

方法

每一層只關(guān)注局部的上下文關(guān)系 \(\rightarrow\) 高秩、更稀疏

最終整體的網(wǎng)絡(luò)結(jié)構(gòu)如圖:

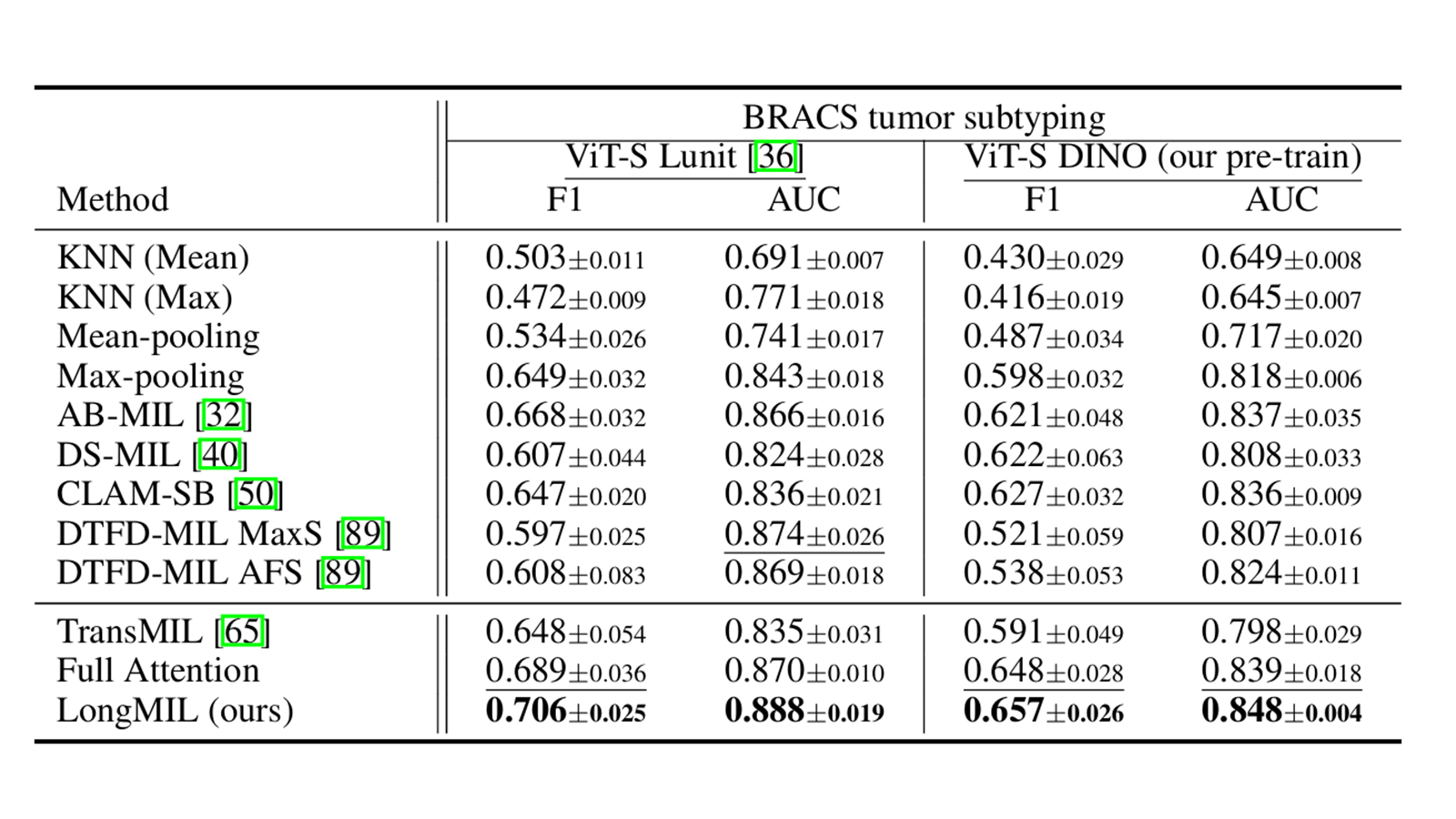

實驗

總結(jié)

本文人工設(shè)計了一種自注意力掩碼用于減少長序列場景下的Transformer計算復(fù)雜度。雖然沒有經(jīng)過嚴謹推導(dǎo),但是本文方法的計算復(fù)雜度應(yīng)該為\(\mathcal{O}(nd)\)。

浙公網(wǎng)安備 33010602011771號

浙公網(wǎng)安備 33010602011771號