基于Qlearning強化學習的1DoF機械臂運動控制系統matlab仿真

1.算法仿真效果

matlab2022a仿真結果如下(完整代碼運行后無水印):

仿真操作步驟可參考程序配套的操作視頻。

2.算法涉及理論知識概要

隨著工業自動化和機器人技術的快速發展,機械臂在生產制造、物流倉儲、醫療服務等領域得到了廣泛應用。單自由度(1DoF)機械臂作為最簡單的機械臂模型,是研究復雜機械臂控制的基礎。傳統的機械臂控制方法通常依賴于精確的動力學模型和先驗知識,在面對復雜環境和不確定性時,其控制效果往往受到限制。

強化學習作為一種無模型的學習方法,通過智能體與環境進行交互,不斷嘗試不同的動作并根據環境反饋的獎勵來學習最優策略,能夠在不確定環境中實現高效的決策和控制。Q-learning 是一種經典的強化學習算法,它通過學習一個動作價值函數(Q 函數)來確定最優策略,具有實現簡單、收斂性好等優點。因此,將 Q-learning 算法應用于1DoF機械臂運動控制中,能夠有效提高機械臂在復雜環境下的適應性和控制性能。

2.1 1DoF機械臂動力學模型

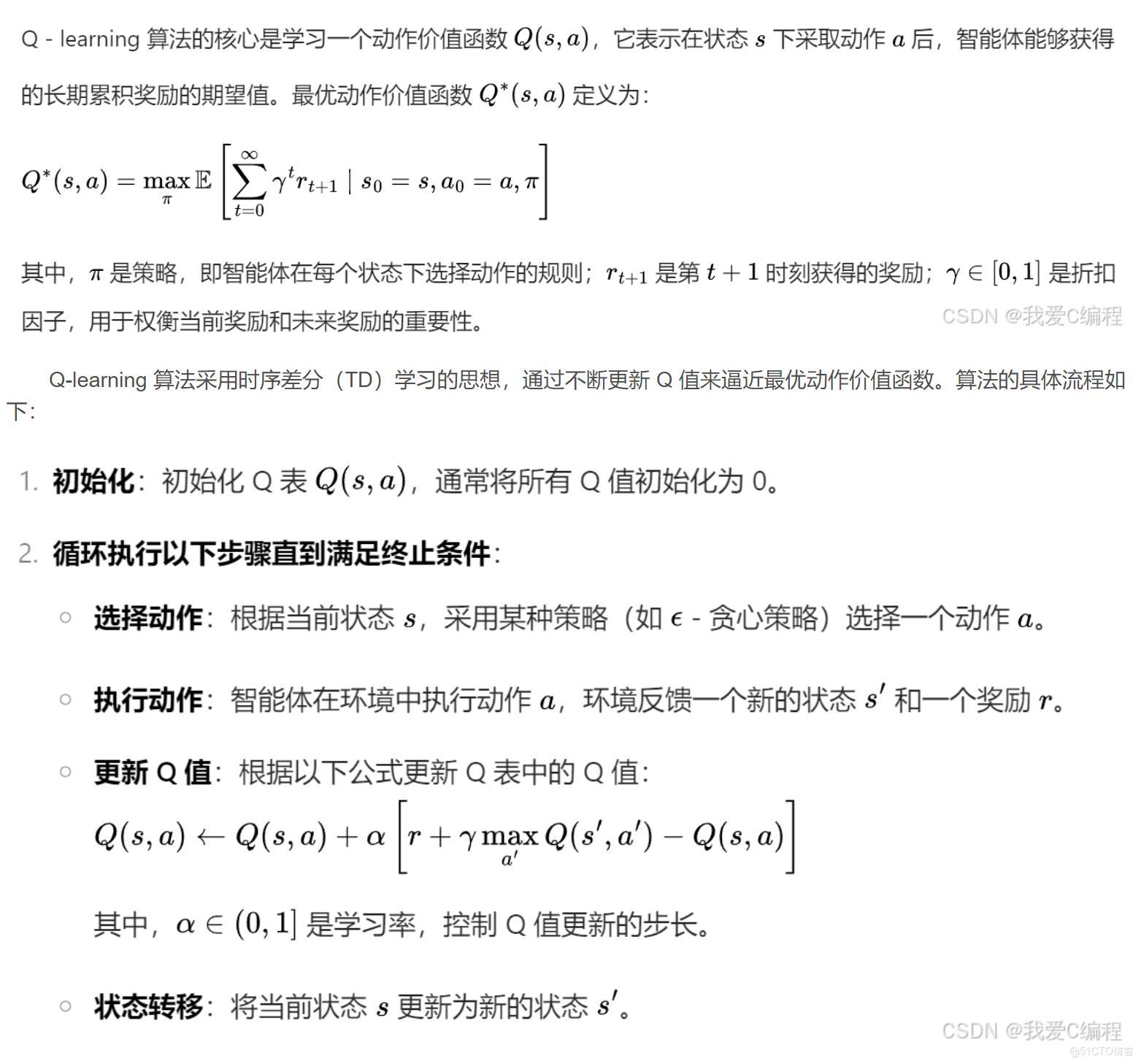

2.2 Q-learning強化學習算法原理

強化學習是一種機器學習范式,主要涉及智能體(Agent)、環境(Environment)、狀態(State)、動作(Action)和獎勵(Reward)等概念。智能體在環境中進行交互,根據當前狀態選擇一個動作并執行,環境會根據智能體的動作反饋一個新的狀態和一個獎勵信號。智能體的目標是通過不斷地與環境交互,學習到一個最優策略,使得長期累積獎勵最大化。

在訓練過程中,記錄每個回合的累積獎勵,得到學習曲線。隨著訓練回合數的增加,累積獎勵逐漸增加,說明智能體在不斷學習并改進控制策略。當訓練回合數足夠多時,累積獎勵趨于穩定,表明智能體已經學習到了較優的控制策略。

在訓練結束后,使用學習到的最優策略對機械臂進行控制,記錄機械臂的關節角度軌跡。實驗結果表明,機械臂能夠快速、準確地跟蹤目標關節角度,并且在到達目標位置后能夠保持穩定。

3.MATLAB核心程序

% 定義學習率,用于在更新Q矩陣時權衡新舊值的權重

Lr = 0.99;

% 初始的探索概率

Epsr = 1;

% 每次迭代的探索概率衰減因子

Rdec = 0.9999;

% 初始化當前的探索概率

Pes = Epsr;

%在評估狀態和動作的價值時,考慮未來狀態價值的重要性

dcnt = 0.3;

% 定義成功執行預期動作的概率

Su_rate = 1;

% 當系統到達期望狀態(擺錘直立)時給予的巨大獎勵

Rewardr = 1000000;

.........................................................................

% 初始化一個長度為 Miter 的零向量,用于存儲每個回合的平均獎勵

Rwdm = zeros(1,Miter);

Action_set0= zeros(1,Mact);

Action_set = zeros(1,Miter);

% 計算當前回合的平均獎勵

Rwd_avg = Rwd_sum/Rwd_cnt;

% 將當前回合的平均獎勵存儲到 Rwdm 向量中

Rwdm(ij) = Rwd_avg;

Action_set(ij) = mean(Action_set0);

end

% 創建一個新的圖形窗口

figure

plot(1:Miter, Rwdm,'-r>',...

'LineWidth',1,...

'MarkerSize',6,...

'MarkerEdgeColor','k',...

'MarkerFaceColor',[0.9,0.9,0.0]);

hold on

xlabel('Epoch');

ylabel('獎勵值');

figure

plot(1:Miter, Action_set,'-r>',...

'LineWidth',1,...

'MarkerSize',6,...

'MarkerEdgeColor','k',...

'MarkerFaceColor',[0.9,0.9,0.0]);

hold on

xlabel('Epoch');

ylabel('動作值');

浙公網安備 33010602011771號

浙公網安備 33010602011771號