美團也出招了,LongCat-Flash 開源,主打一個快!

提到美團,你可能會想到穿梭在大街小巷的黃衣騎手,以及手機里那個“送啥都快”的生活小助手。

而這一次,美團選擇將“小助手”背后的“超級大腦”開源!

就在上周日(8.31)凌晨,美團正式發布并開源了千億參數大模型 LongCat-Flash。僅開源一天,LongCat-Flash 便登上了 Hugging Face 熱榜!這款模型在僅激活少量參數、推理速度更快的情況下,性能直接看齊業界頂級水平,并在指令遵循(IFEval)、智能體工具使用(τ2-Bench)等多項評測中表現優異,超越同類模型。

Hugging Face 地址:huggingface.co/meituan-longcat/LongCat-Flash-Chat

現在,你可以直接前往 longcat.ai 免費在線體驗。你邊玩,我邊講。

一、快成一道閃電

LongCat-Flash 最令我印象深刻的,就是它的“快”!

雖然擁有高達 5600 億的總參數量,但推理速度卻能達到驚人的 100 Tokens/s(TPS)。

這意味著,模型輸出內容時,不再是“擠牙膏”式地一段字一段字蹦,而是像閃電一樣刷刷刷地給出結果。

根據官方數據,LongCat-Flash 在 H800 上可以實現 100 Tokens/s 的生成速度,輸出成本低至 5 元/百萬 Token,真正做到了“又快又省”。

二、“偷懶”的藝術

這么快的速度是怎么來的?LongCat-Flash 基于兩個核心技術,讓它既有“大塊頭”的智慧,又有“小身板”的敏捷。

零計算專家(Zero-computation Experts)

咱們都知道,不是所有問題都一樣難,LongCat-Flash 也懂這個道理!

它引入了一種“零計算專家”機制,就像學霸做卷子,簡單的送分題一掃而過,把時間都花在壓軸的大題上。通過這種算力按需分配機制,每個 Token 可根據上下文需求僅激活 18.6B~31.3B 的少量參數,實現算力的高效利用,大大提升了效率。

更快的 MoE(Shortcut-connected MoE)

傳統模型工作起來,經常是“一步做完再做下一步”,中間會有等待的空窗期,浪費時間。LongCat-Flash 采用了 ScMoE 架構,徹底優化了內部工作流。

這好比一條更快的流水線,上一個工序的零件還沒完全打包好,下一個工序就已經開始并行處理了,讓計算和通信無縫銜接。這樣一來,無論是訓練還是推理,整體效率都得到了巨大提升。

三、成績單怎么樣?

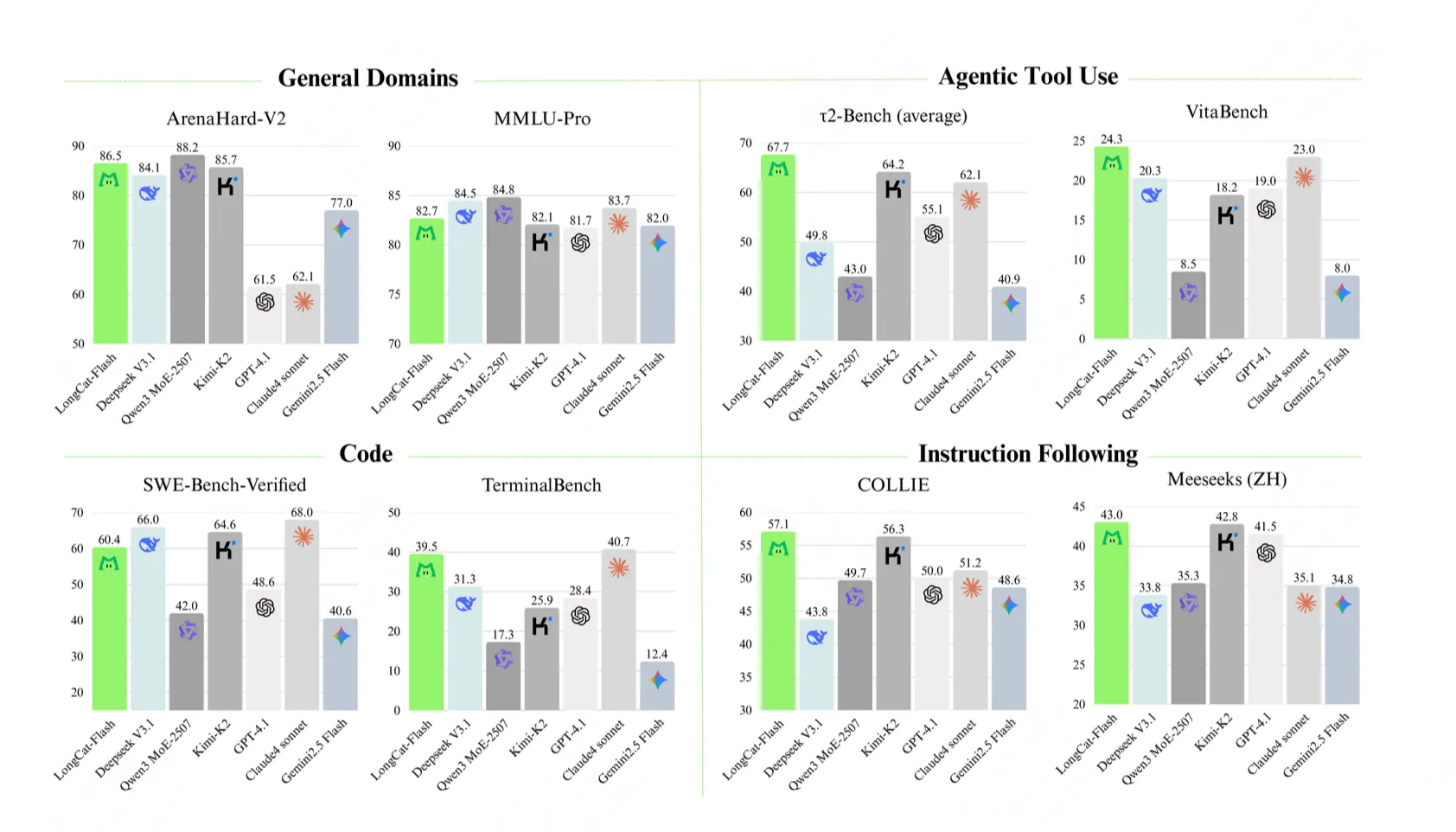

LongCat-Flash 的性能在各大基準測試(Benchmark)中也相當能打。

它不僅在通用能力上看齊了 DeepSeek-V3.1、Kimi-K2 等業界頂尖模型,更是在智能體工具使用(Agentic Tool Use)方面表現出了明顯的優勢。

在 τ2-Bench 和美團自家的真實業務場景測試 VitaBench 中,LongCat-Flash 都取得了最高分(SOTA),甚至超越了一些參數更多的模型。

四、AI Agent 將是下一代“超級助手”

如今的 AI,早已不再滿足于僅陪你聊天,而是在向能訂票、分析數據、操作軟件等多方面進化,真正成為你的智能生活助手——這就是 Agent 時代。

美團 LongCat-Flash 正是瞄準了這一趨勢。憑借極快的輸出速度、卓越的指令遵循能力,以及強大的工具調用性能,讓開發者能夠更加輕松地構建出高效、有用的 AI Agent 應用,實現真正智能的生活助手體驗。

坦率地講,美團此時開源大模型的時間上確實稍晚于其他“玩家”,但我注意到美團 LongCat-Flash 的發力點非常明確——專注于模型在 Agent 場景下的可用性,聚焦解決 AI 技術“如何真正有用”的問題。這種投入絕不是“玩票”,而是面向未來的戰略選擇。

Hugging Face 地址:huggingface.co/meituan-longcat/LongCat-Flash-Chat

GitHub 地址:github.com/meituan-longcat/LongCat-Flash-Chat

在線體驗:longcat.ai

或許,下一代真正改變我們生活的超級助手,正在悄然走近我們。

作者:削微寒

掃描左側的二維碼可以聯系到我

本作品采用署名-非商業性使用-禁止演繹 4.0 國際 進行許可。

浙公網安備 33010602011771號

浙公網安備 33010602011771號