超詳細:普通電腦也行Windows部署deepseek R1訓練數據并當服務器共享給他人

一、Windows 版 DeepSeek-R1、Ollama 與 AnythingLLM 介紹及核心使用場景?

?一、組件功能與定位?

-

?DeepSeek-R1?

- ?模型特性?:支持 ?FP16 計算? 和 ?CUDA 加速?,提供 1.5B 至 671B 參數量級版本,適用于本地部署的邏輯推理、文本生成、數據分析等場景?。

- ?優勢?:開源免費、響應速度快(本地低延遲),支持中文復雜任務處理?。

-

?Ollama?

- ?核心功能?:簡化大語言模型本地部署流程,支持一鍵下載、運行和管理模型(如 DeepSeek-R1),提供命令行界面和靈活的環境變量配置?。

- ?特性?:支持自定義安裝路徑(需修改系統變量)、多模型切換、離線運行?。

-

?AnythingLLM?

- ?定位?:全棧 AI 應用,集成本地大模型(通過 Ollama)與知識庫,支持文檔/音視頻/網頁內容轉換為上下文數據,供 LLM 調用?。

- ?功能?:私有化知識庫構建、多工作區管理、模型與數據關聯式問答?。

?二、核心使用場景?

-

?企業內部知識庫與智能客服?

- ?場景?:通過 AnythingLLM 上傳企業文檔(如產品手冊、合同),結合 DeepSeek-R1 實現精準問答,替代傳統人工客服?。

- ?優勢?:數據本地化存儲(避免云端泄露)、支持多格式文件解析?。

-

?專業領域研究與分析?

- ?場景?:科研人員使用 DeepSeek-R1 處理長文本(如論文、報告),生成摘要或提取核心結論;結合 AnythingLLM 訓練領域專屬模型?。

- ?案例?:法律條文分析、醫學文獻結構化處理?。

-

?個人效率工具?

- ?場景?:

- ?周報生成?:輸入工作記錄,由 DeepSeek-R1 自動整理成結構化周報?。

- ?實時翻譯?:本地部署模型實現無網絡環境下的多語言互譯?。

- 個性化知識助手?:導入個人筆記、電子書等資料,構建專屬知識庫,輔助日常學習決策?。

- ?場景?:

-

?開發與測試環境?

- ?場景?:開發者通過 Ollama 快速切換不同參數量級的 DeepSeek-R1 版本,測試模型性能或調試應用兼容性?。

二、本地下載安裝部署

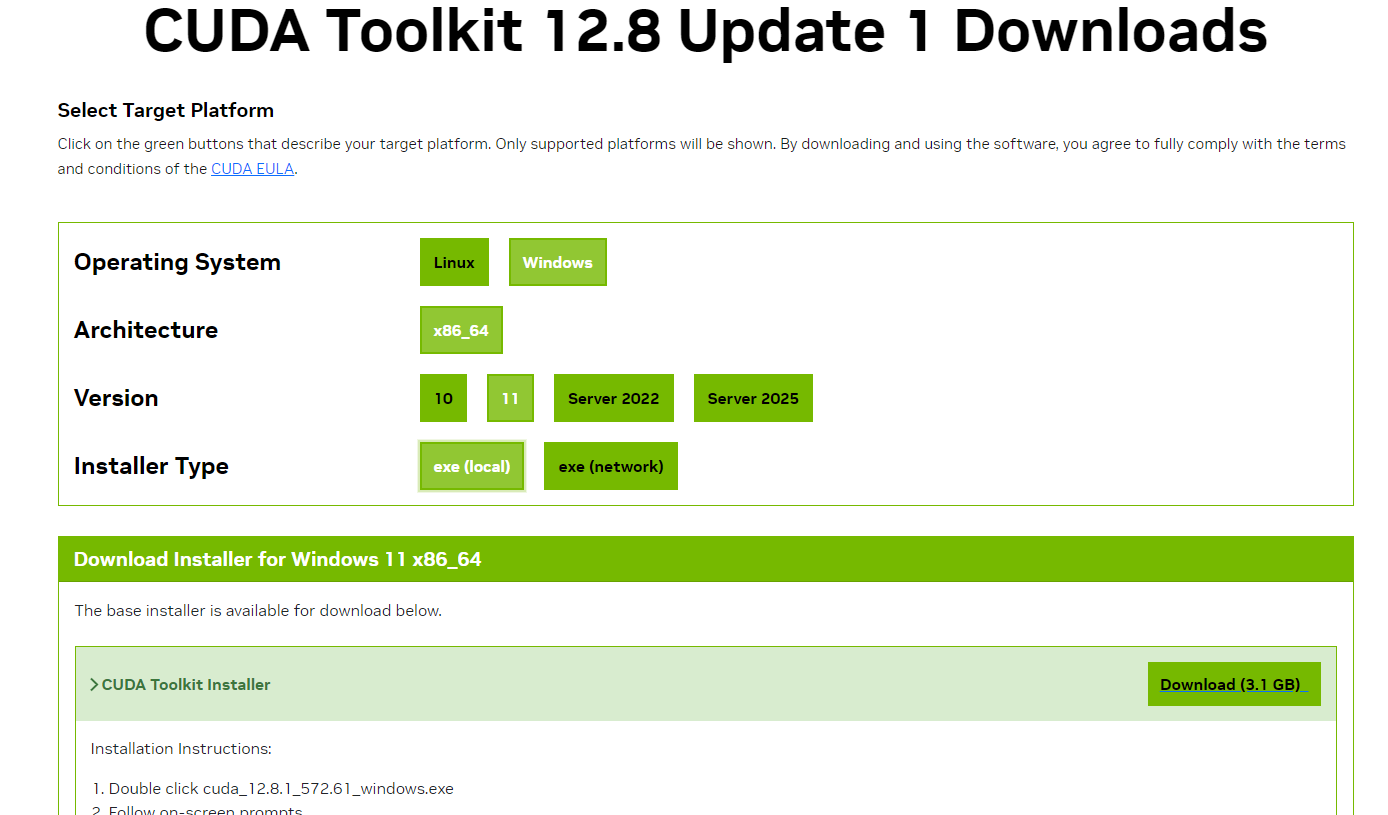

1、安裝 CUDA Toolkit 步驟如下:https://developer.nvidia.com/cuda-downloads?target_os=Windows&target_arch=x86_64

2、Ollama 安裝:https://ollama.com/

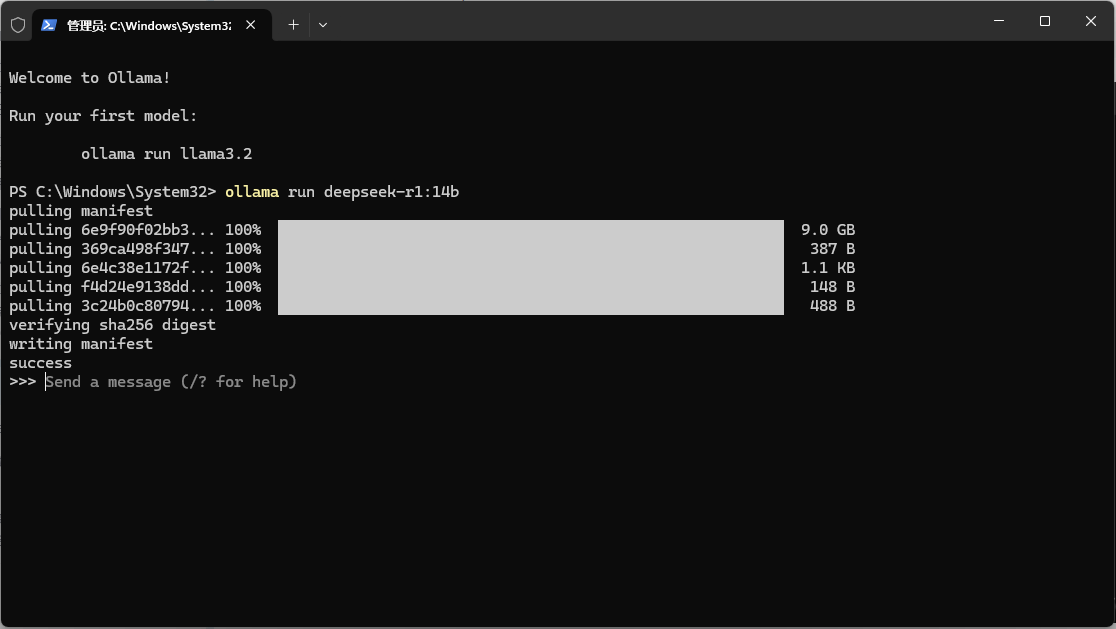

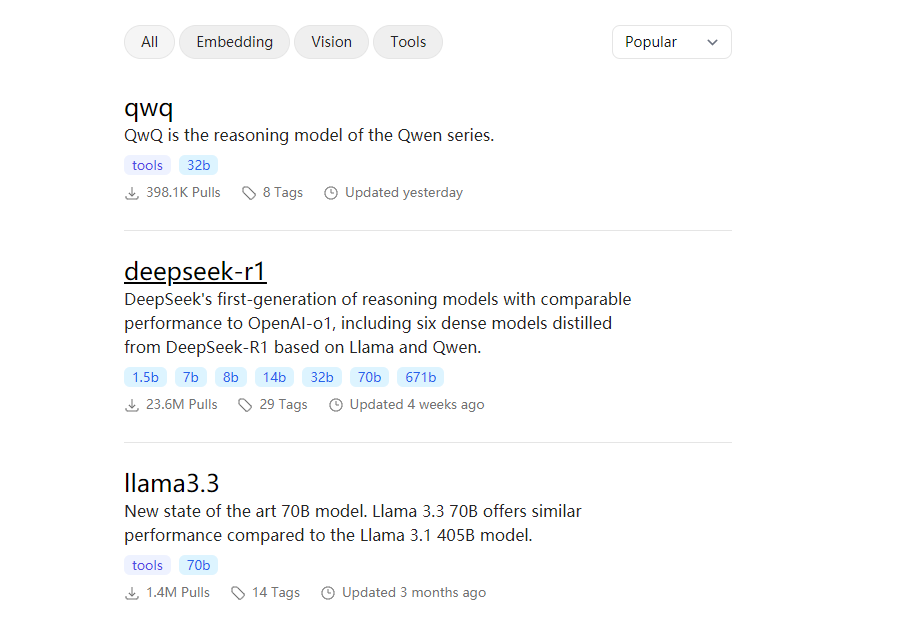

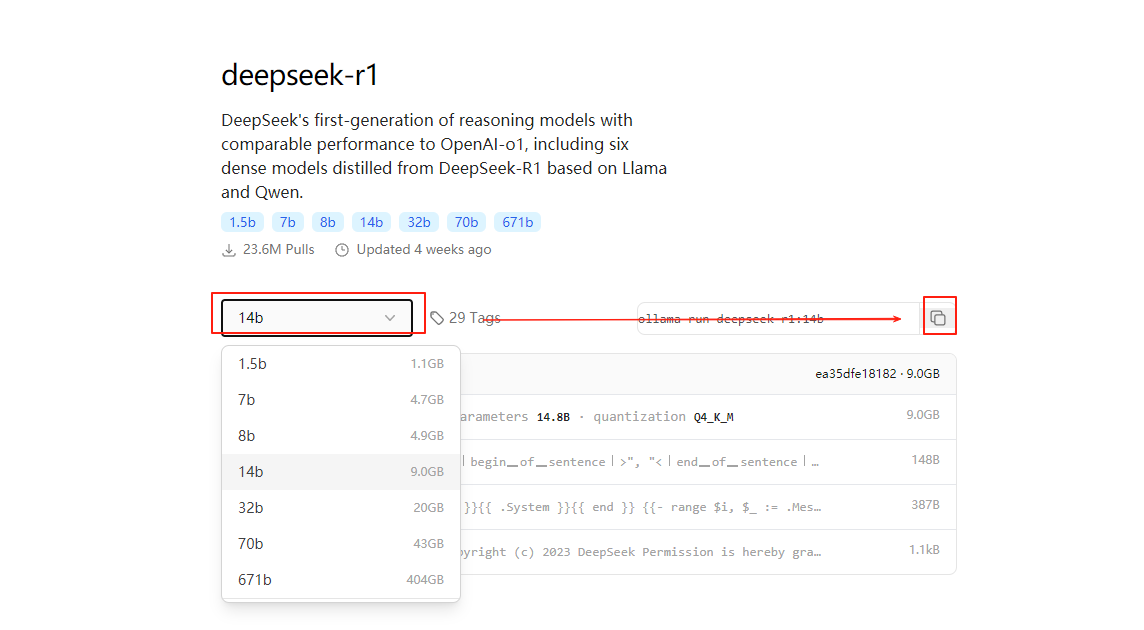

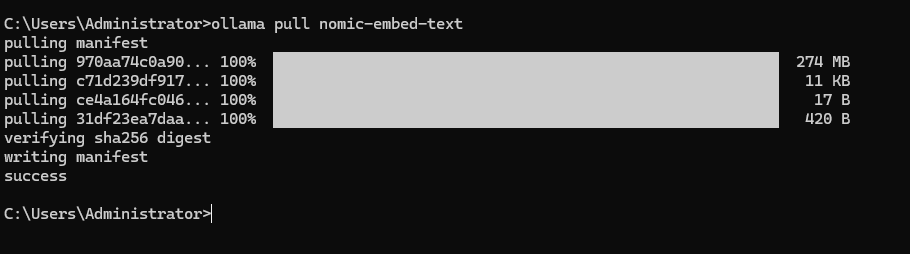

3、 通過Ollama安裝模型:https://ollama.com/search

ollama run deepseek-r1:1.5b

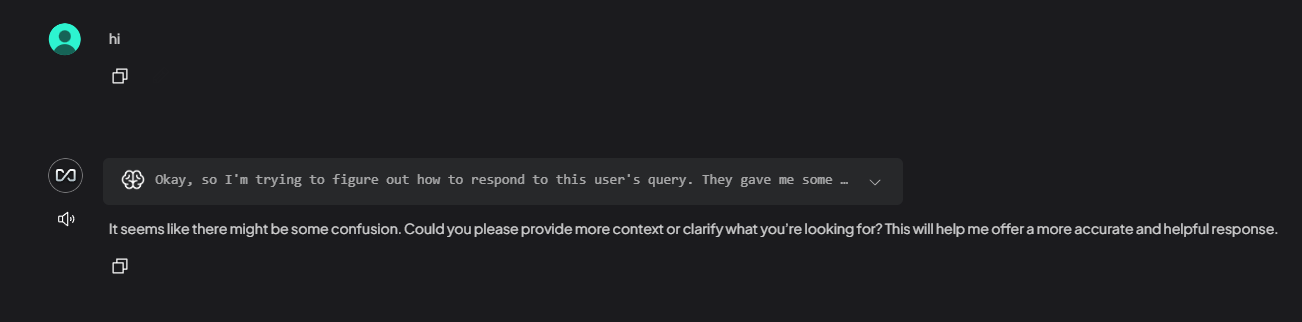

Powershell 的終端中直接運行了,但是存在諸多不便之處。比如,難以對對話記錄進行保存、搜索與管理,無法讀取附件,并且無法集成本地知識庫來實現檢索增強生成等功能,極大地影響了用戶體驗。因此,強烈推薦大家安裝一款本地 AI 應用用戶界面,本文以 AnythingLLM 為例進行示范。

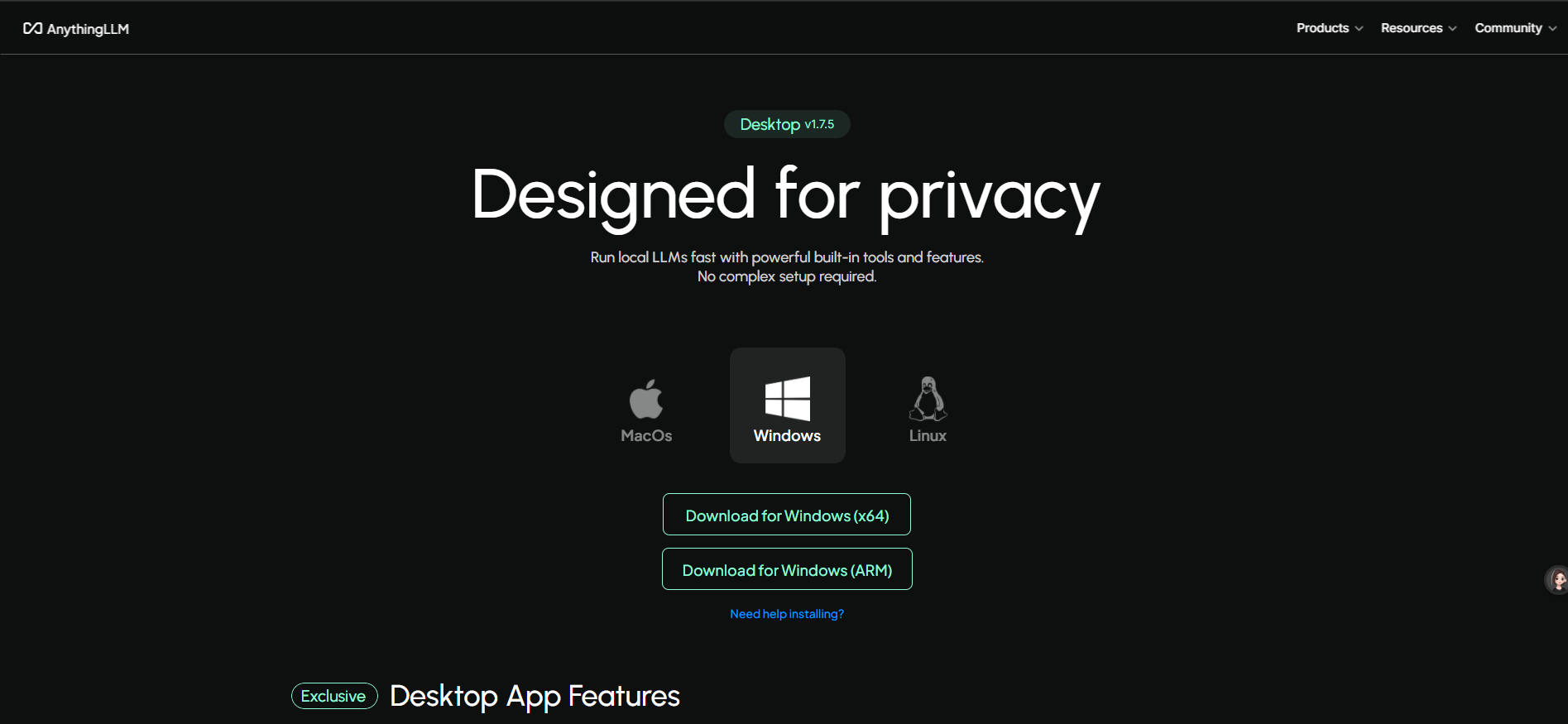

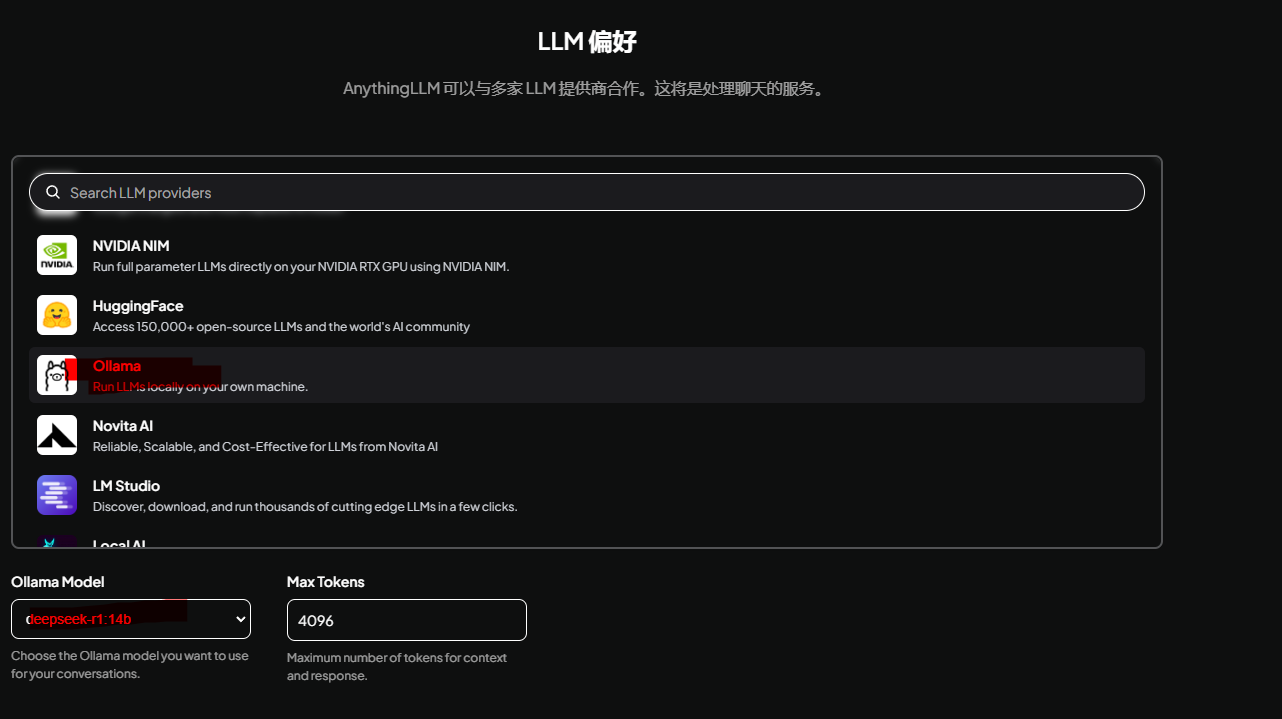

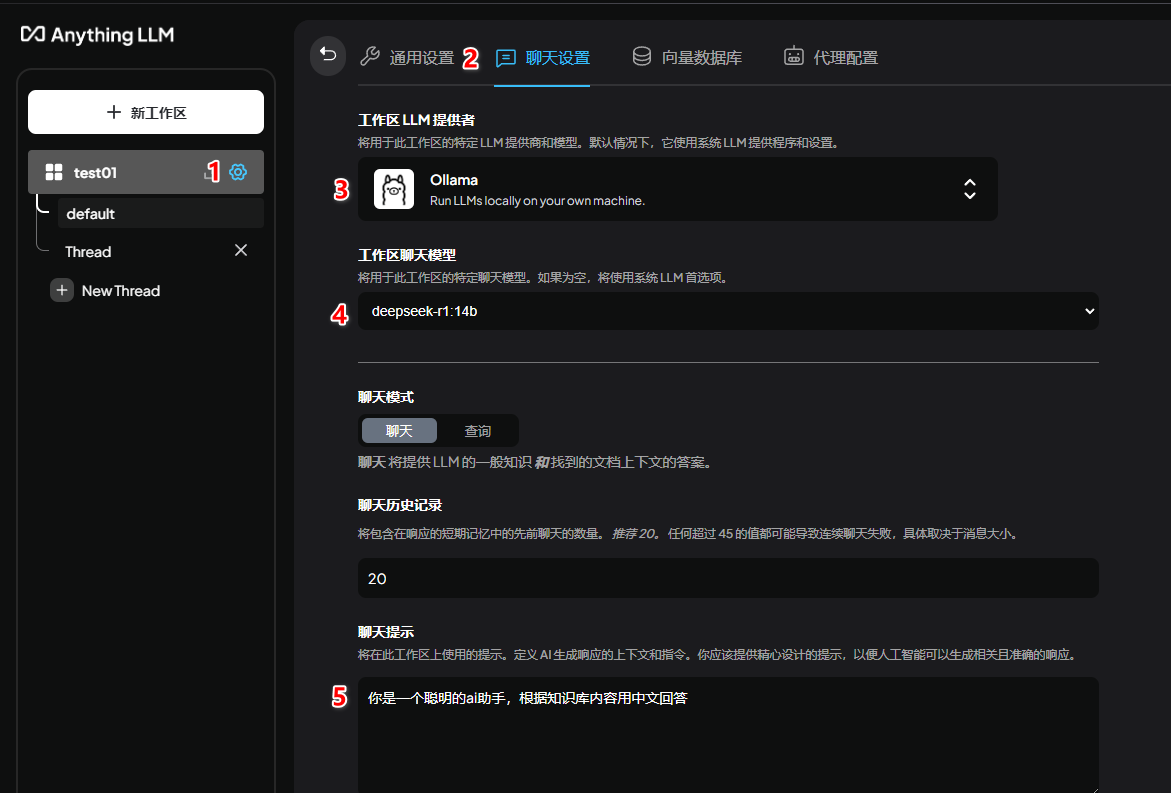

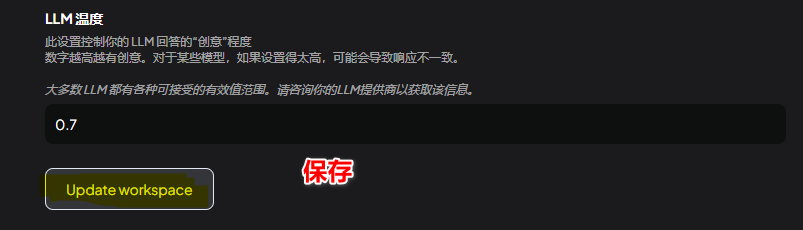

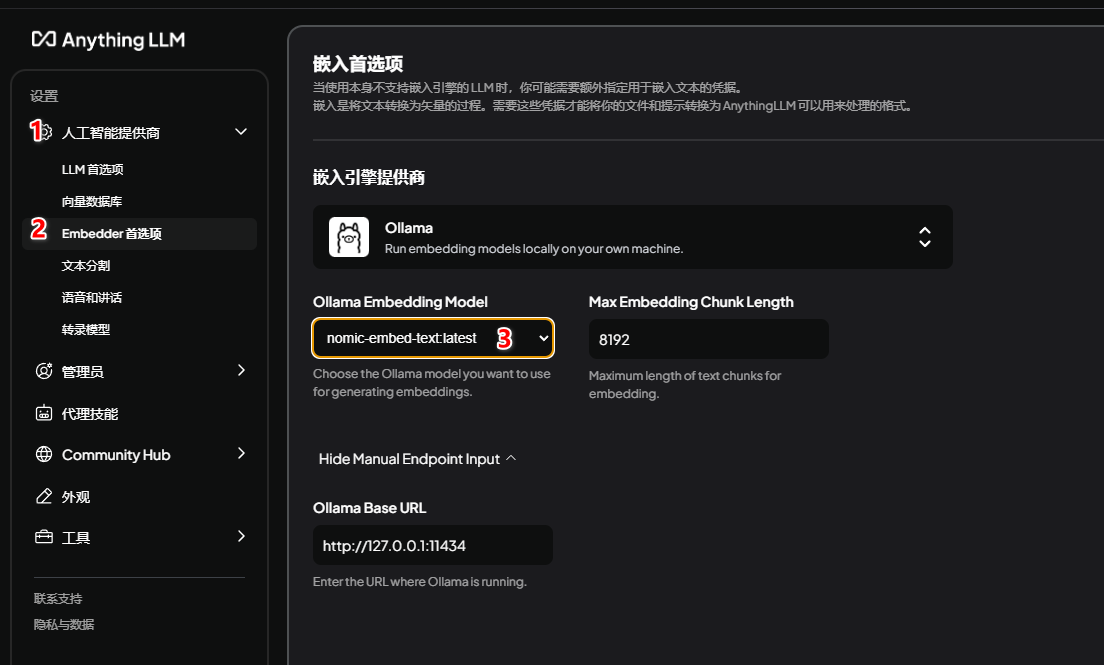

4、AnythingLLM 安裝與配置:https://anythingllm.com/desktop

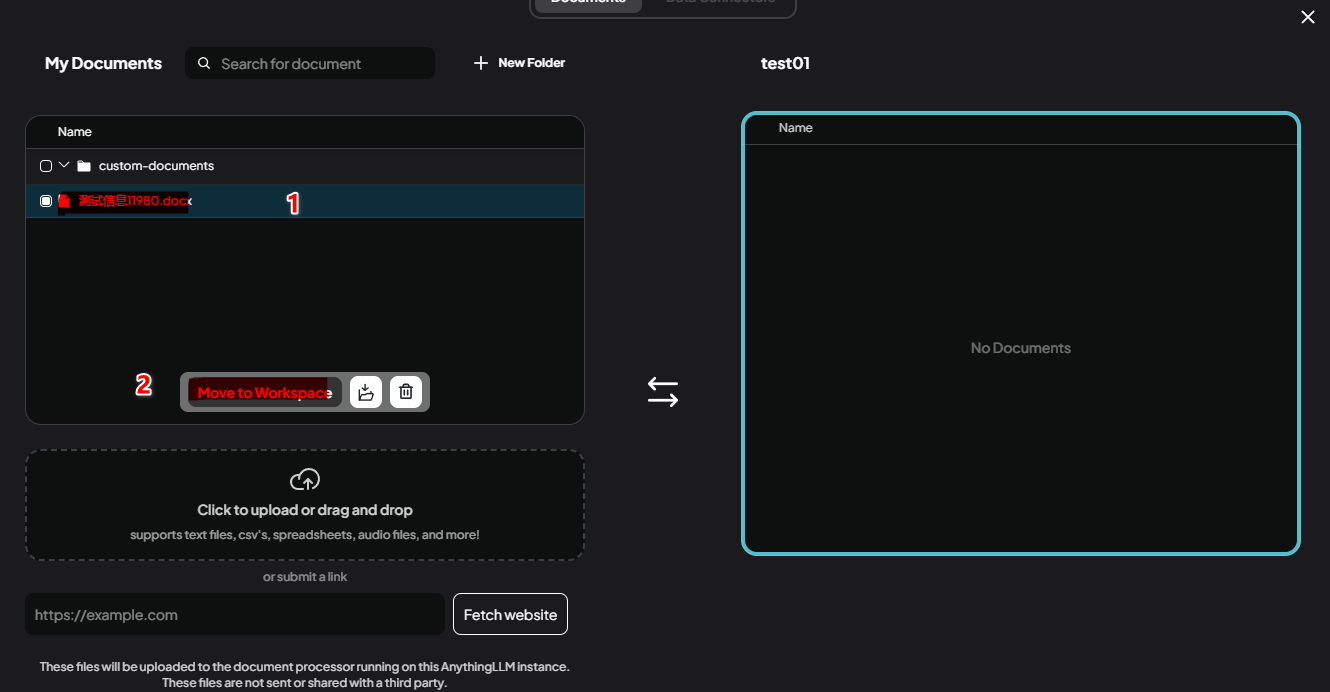

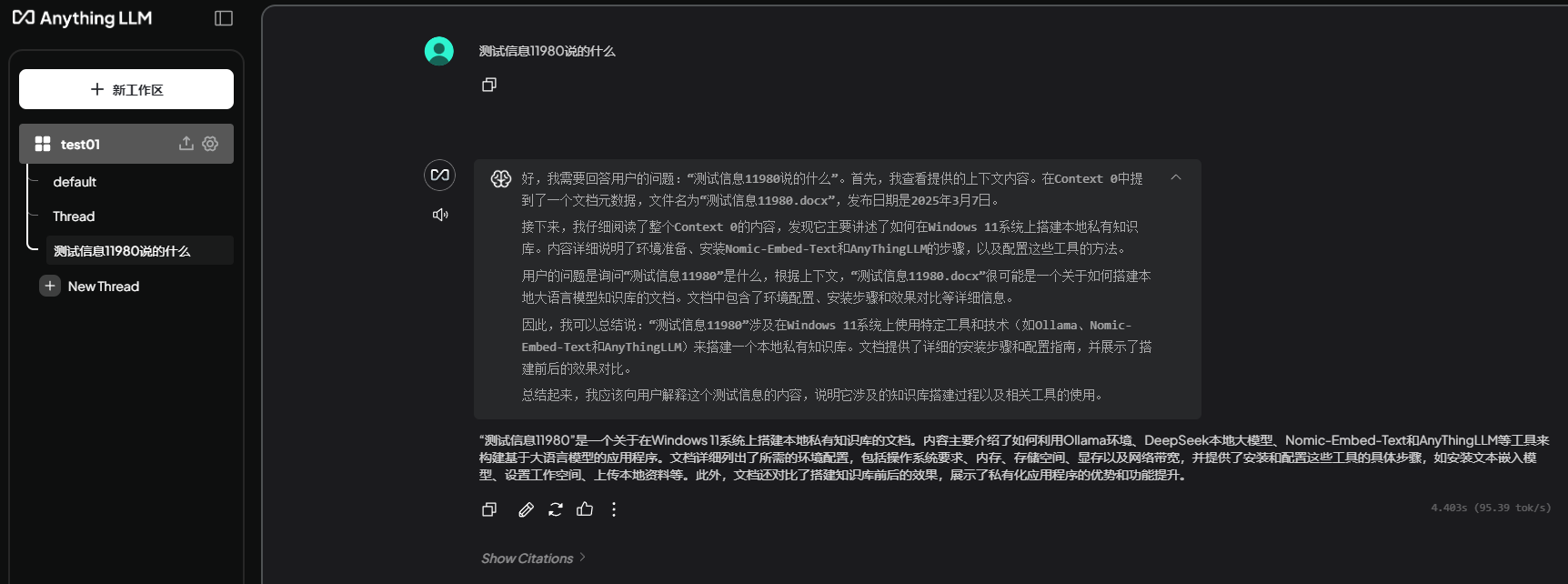

6. 上傳本地資料構建本地數據庫

三、Windows 系統 Ollama 當服務器開放共享給其他人

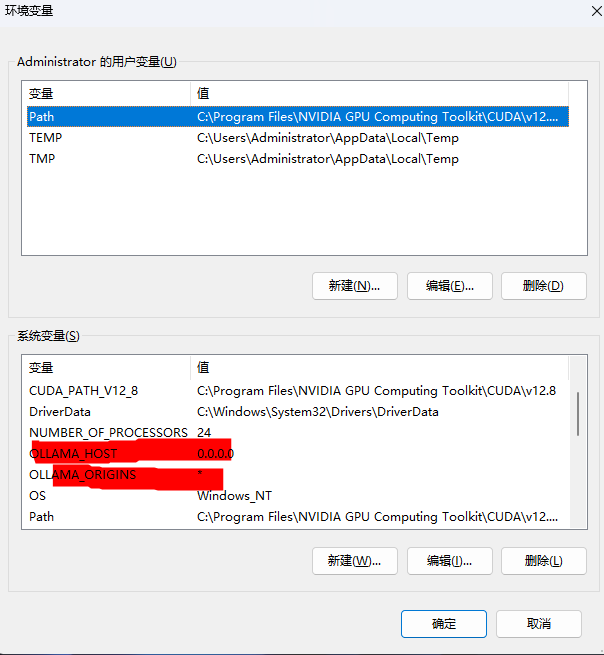

?一、配置環境變量開放訪問權限?

-

?設置

OLLAMA_HOST環境變量?- 右鍵點擊「此電腦」→「屬性」→「高級系統設置」→「環境變量」→「系統變量」→「新建」:

- ?變量名?:

OLLAMA_HOST - ?變量值?:

0.0.0.0(允許所有網絡接口監聽請求)?

- ?變量名?:

- 若需同時解決跨域問題,可添加變量

OLLAMA_ORIGINS,值為*?。

- 右鍵點擊「此電腦」→「屬性」→「高級系統設置」→「環境變量」→「系統變量」→「新建」:

-

?重啟 Ollama 服務?

- 退出任務欄的 Ollama 程序(右鍵圖標→「Quit Ollama」),重新啟動 Ollama ?。

- 若配置未生效,建議重啟系統 ?。

?二、開放防火墻端口?

-

?通過命令行添加防火墻規則?

- 以管理員身份運行命令提示符,執行以下命令:

(放行 Ollama 默認端口

netsh advfirewall firewall add rule name="Ollama" dir=in action=allow protocol=TCP localport=1143411434)?

- 以管理員身份運行命令提示符,執行以下命令:

-

?驗證防火墻規則?

- 檢查端口是否放行成功:

(輸出需包含

netsh advfirewall firewall show rule name="Ollama"Enabled=Yes和Action=Allow)?

- 檢查端口是否放行成功:

?三、驗證非本機訪問?

-

?局域網設備測試?

- 執行命令

ipconfig查看本機 IPv4 地址(如192.168.1.100)。 - 在其他設備的瀏覽器或命令行中訪問:

(若返回模型列表,則配置成功)?

curl http://[Windows主機IP]:11434/api/tags

- 執行命令

-

?可視化工具驗證(可選)?

- 使用 Open WebUI 或 LobeChat 等工具,輸入

http://[Windows主機IP]:11434作為 Ollama 服務地址進行連接 ?。

- 使用 Open WebUI 或 LobeChat 等工具,輸入

?四、常見問題解決?

- ?報錯

Server connection failed?:

檢查環境變量OLLAMA_HOST和OLLAMA_ORIGINS是否配置正確,并重啟服務 ?。 - ?端口占用或沖突?:

使用netstat -ano | findstr 11434確認端口未被其他進程占用 ?。

五、公網共享(可選)?

-

?內網穿透工具部署?

- 使用

ngrok將本地服務映射至公網:ngrok http 11434 # 映射 Ollama 服務 - 生成公網鏈接(如

https://xxx.ngrok.io)共享給外部用戶。

- 使用

-

?域名綁定(高級)?

- 若已備案域名,可通過路由器或云服務商配置端口轉發,將域名指向服務器 IP。

?注意事項?

- 開放

0.0.0.0會暴露服務至公網,建議內網使用時結合 IP 白名單或 VPN 提升安全性 ?。 - 若修改了模型存儲路徑(

OLLAMA_MODELS),需確保目錄權限允許網絡訪問 ?。 - 內網穿透需謹慎暴露公網端口,建議配置 HTTPS 加密和 IP 白名單?。

- 定期清理 AnythingLLM 的無效文檔,避免存儲空間占用過高?

浙公網安備 33010602011771號

浙公網安備 33010602011771號